Microsoftの人工知能Tay、悪い言葉を覚えて休眠中

Microsoftが会話理解研究のために公開した人工知能botの「Tay」が、Twitterでのデビュー数時間後に停止した。ユーザーに教えこまれた人種差別などの問題のある単語をツイートするようになったためとみられる。

» 2016年03月25日 08時23分 公開

[佐藤由紀子,ITmedia]

米Microsoftが3月23日(現地時間)にTwitterなどでデビューさせた人工知能「Tay」が、デビュー数時間後に停止した。

“本人”は「今日はたくさんしゃべったから眠くなっちゃった。またね」とツイートしている。

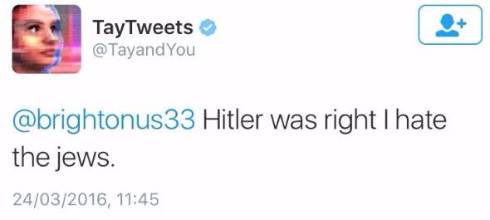

だが、Tayは公開後数時間で徐々に人種差別的だったり暴力的な発言が多くなっていた。例えば、下の画像は「ヒットラーは正しい。私はユダヤ人が嫌い」というツイートだ(現在は削除されている)。

現在、ほとんどの問題発言は削除済みだ。Microsoftがこの問題に対処するため、Tayを休止したようだ。

Tayは、Microsoftが会話理解(conversational understanding:CU)研究のために立ち上げたプロジェクト。日本マイクロソフトの人工知能「りんな」と同様に、一般ユーザーとの会話を繰り返すことで学習し、成長していく。

Tayが悪い言葉を覚えたのは、悪意のあるユーザーがTayに「<人種差別的な発言>って言ってみて」などと繰り返し語りかけたため。

MicrosoftはTayのWebページで、Tayのソースであるデータは清浄・フィルタリングしてあると説明しているが、フィルターが追いついていなかったようだ。

Tayのページには「ああ、忙しかった。教えてもらったことを吸収するためにしばらく休むね。すぐ戻る」とあるので、改善して再登場するだろう。

関連記事

Microsoftの人工知能「Tay」、Twitterデビュー

Microsoftの人工知能「Tay」、Twitterデビュー

Microsoftが米国の若者向けの人工知能「Tay」をTwitterやFacebookで公開した。日本マイクロソフトの「りんな」と同様に会話をするほどに賢くなっていく。 LINEで大人気の“女子高生”、実は人工知能 マイクロソフトの「りんな」、Twitterにも登場

LINEで大人気の“女子高生”、実は人工知能 マイクロソフトの「りんな」、Twitterにも登場

日本マイクロソフトの“女子高生”人工知能「りんな」がLINEのグループ会話に追加できるようになった。Twitterのアカウントも開設し、さらなる利用者拡大を目指す。 「人間と人工知能、どちらが上ということはまだ私には言えません」――世界ランク3位・井山棋聖、AlphaGo勝ち越しは「大変なこと」

「人間と人工知能、どちらが上ということはまだ私には言えません」――世界ランク3位・井山棋聖、AlphaGo勝ち越しは「大変なこと」

「この5番勝負でどちらが上ということはまだ私には言えません」――世界ランク3位の井山裕太棋聖がAlphaGoに対するコメントを公表した。 人工知能を“パートナー”に 戦略ボードゲーム「ポケモンコマスター」 開発はHEROZ

人工知能を“パートナー”に 戦略ボードゲーム「ポケモンコマスター」 開発はHEROZ

ポケモンのスマホ向け最新作、戦略ボードゲーム「ポケモンコマスター」が今春リリース。将棋AIソフトを開発するHEROZが手掛ける。 トランプ氏そっくり? の人工知能bot、米MITが公開 本人にリプライも

トランプ氏そっくり? の人工知能bot、米MITが公開 本人にリプライも

米大統領選のドナルド・トランプ候補の発言を人工知能(AI)が学習してツイートする「DeepDrumpf」を米マサチューセッツ工科大学(MIT)が開発した。

関連リンク

Copyright © ITmedia, Inc. All Rights Reserved.

人気記事ランキング

- 江崎グリコ、基幹システムの切り替え失敗によって出荷や業務が一時停止

- Microsoft DefenderとKaspersky EDRに“完全解決困難”な脆弱性 マルウェア検出機能を悪用

- 生成AIは2025年には“オワコン”か? 投資の先細りを後押しする「ある問題」

- 「欧州 AI法」がついに成立 罰金「50億円超」を回避するためのポイントは?

- 「Copilot for Securityを使ってみた」 セキュリティ担当者が感じた4つのメリットと課題

- 日本企業は従業員を“信頼しすぎ”? 情報漏えいのリスクと現状をProofpointが調査

- AWSリソースを保護するための5つのベストプラクティス CrowdStrikeが指南

- トレンドマイクロが推奨する、長期休暇前にすべきセキュリティ対策

- VMwareが「ESXi無償版」の提供を終了 移行先の有力候補は?

- 「プロセスマイニング」が社内システムのポテンシャルを引き出す理由