なぜ、人間と人工知能の対話は“破綻”してしまうのか:【総力特集】人とAIの共存で進化する「おもてなし」(2/3 ページ)

「対話破綻検出チャレンジ」で日本中が団結

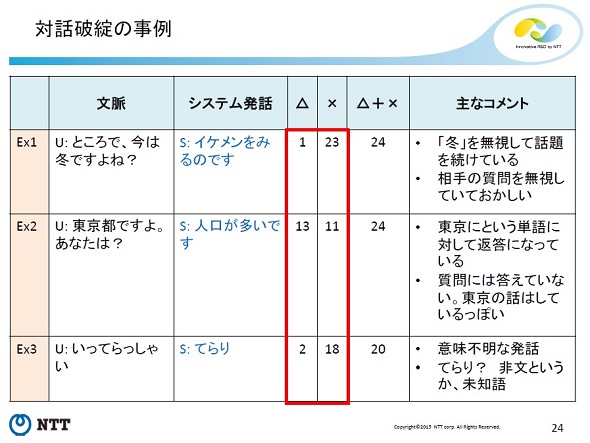

対話が破綻しているかどうかを調べ、分析するためには、対話がうまく続いている例と対話が失敗した例を集める必要がある。そのため、システムと人間の会話データを大量に用意し、各発言についてさまざまな人に3段階で評価をしてもらったそうだ。

「対話が問題なく続くケースに○、内容に違和感があるケースに△、内容が不自然すぎて対話を続けるのが困難というケースに×をつけてもらったところ、4割くらいが△か×、つまり対話が破綻しているんですね。破綻時にリカバリーするというアプローチもありますが、今は破綻そのものを少なくすることを考えています。

そこで、多くの人が△や×をつけるような発言をコンピュータが自動的に検出するシステムを作ろうとしています。システムが話そうとしている内容が、対話を続けるために問題ないかどうかを自動的に検出する技術、これを対話破綻検出技術と言いますが、これに今、日本中で取り組んでいるんです」(東中さん)

人工知能(システム)との対話が破綻してしまう例。こちらは24人が評価している。Ex2の内容は質問には答えていないものの、「東京」という単語についてはつながりがあるため、破綻している感じた(×をつけた)人は少なくなった。言葉が少し違うだけで破綻と感じるかどうかが変わることが分かる(資料提供:日本電信電話)

人工知能(システム)との対話が破綻してしまう例。こちらは24人が評価している。Ex2の内容は質問には答えていないものの、「東京」という単語についてはつながりがあるため、破綻している感じた(×をつけた)人は少なくなった。言葉が少し違うだけで破綻と感じるかどうかが変わることが分かる(資料提供:日本電信電話)そして、この対話破綻検出技術を培う場として、東中さんが主導して始めたのが「対話破綻検出チャレンジ」だ。さまざまな大学や企業の研究者が参加して、検出システム(アルゴリズム)を構築。評価用の対話データを使って精度を競うワークショップだ。2015年、2016年と2回開催しており、2016年に開催したワークショップでは、聴講での参加者を含めて200人ぐらいが集まったという。

「似たような評価型ワークショップの取り組みは、音声認識の分野でも行われており、成功した歴史があったので、『雑談の破綻』でもやってみようと思って始めました。とても自分一人だけで解決できるような問題ではない。だったら日本中でやったほうがいいなと。

海外でも少しずつこうした取り組みが始まっているのですが、日本の方が評価用のデータサイズも大きいし、参加しているチームもすごく多い。この分野では日本がかなり先んじているなと感じています。しかし、米Amazon.comがAlexaで稼働するソーシャルbot開発コンテストを多額の賞金を懸けて世界規模で行っていますし、日本もうかうかしてはいられません」(東中さん)

この取り組みのオーガナイザーには、NTT、NTTドコモ、広島市立大学、HRI-JP(ホンダ・リサーチ・インスティチュート・ジャパン)、大阪大学といった企業や大学が並び、評価用データの提供には、デンソーITラボラトリなども関わっている。

産学の垣根を越えて協力できるのは、まだ要素技術をはぐくんでいる段階であるためだ。とある企業の商用システムを改善する、といったテーマだと競合企業などは参加しにくい。「現在のところは利害関係が薄く、学術的なモチベーションが強いため、参加障壁が低く、技術を磨くのにちょうどよい題材になっている」と東中さんは話す。

関連記事

- ITmedia 総力特集:人とAIの共存で進化する「おもてなし」

なぜ“マツコロイド”と“マツコ”の雑談は失敗したのか?

なぜ“マツコロイド”と“マツコ”の雑談は失敗したのか?

ドラえもんや鉄腕アトムのような、人間と自然に会話ができる人工知能は本当に生まれるのか――。人間らしい自然なコミュニケーションを実現するために必要な“要件”はいろいろとあるが、人工知能にそれを適用するには、さまざまな壁があるのだという。 人工知能と人が、本当の意味で“話せる”ようになる日

人工知能と人が、本当の意味で“話せる”ようになる日

昨今「Watson」や「りんな」など、人間と会話ができる人工知能が注目を集めている。しかし、これらは人間の心を理解してコミュニケーションを取っているかというと、そうではない。いつか本当に人工知能と人が心を通わせるような時代は来るのか。人間と雑談できる対話システムを開発し続ける第一人者に話を聞いた。 「自然言語処理」のプロに聞く:世界の言語をつなぎ、国を越えて仲良く話せる人を増やしたい――金山博さん

「自然言語処理」のプロに聞く:世界の言語をつなぎ、国を越えて仲良く話せる人を増やしたい――金山博さん

人間の話し言葉を分析する「自然言語処理」が注目を集めている。耳慣れない言葉かもしれないが、Siriやしゃべってコンシェルなど、私たちは知らず知らずのうちにその恩恵を受けているのだ。そこで「Watson」のシステムを支える研究員に、自然言語処理の面白さと未来について聞いてみた。 ロボット5台が大喜利に挑戦、人工知能の“ボケ”で笑いはとれるか?

ロボット5台が大喜利に挑戦、人工知能の“ボケ”で笑いはとれるか?

ニコニコ超会議のNTTブースで、コミュニケーションロボットの「Sota」が大喜利に挑戦するという展示がある。5台あるうちの1台はNTTドコモの人工知能が搭載されており、リアルタイムで“ボケ”を生成する。人工知能のボケで会場の笑いは取れるのだろうか。

Copyright © ITmedia, Inc. All Rights Reserved.

人気記事ランキング

- 爆売れだった「ノートPC」が早くも旧世代の現実

- VPNやSSHを狙ったブルートフォース攻撃が増加中 対象となる製品は?

- 生成AIは検索エンジンではない 当たり前のようで、意識すると変わること

- HOYAに1000万ドル要求か サイバー犯罪グループの関与を仏メディアが報道

- ランサムウェアに通用しない“名ばかりバックアップ”になっていませんか?

- 大田区役所、2023年に発生したシステム障害の全貌を報告 NECとの和解の経緯

- 「Gemini」でBigQuery、Lookerはどう変わる? 新機能の詳細と利用方法

- PHPやRust、Node.jsなどで引数処理の脆弱性を確認 急ぎ対応を

- 攻撃者が日本で最も悪用しているアプリは何か? 最新調査から見えた傾向

- 標的型メール訓練あるある「全然定着しない」をHENNGEはどう解消するのか?