9月は例年、Appleが新しいiPhoneを発表し、合わせて新しいiOSをリリースする月です。一説によると、次期iPhoneの発表イベントは9月7日だとか。だとしたらもう、あと10日しかありません。

Appleは新製品やサービスの発表が近づくと、お気に入りのジャーナリストご指名で、「インタビューさせてあげる」ことが多いです。米国では、Recodeのウォルト・モスバーグ氏やFast Companyのリック・テッツェリ編集長、Backchannelのスティーブン・レヴィ氏などが常連となっています。

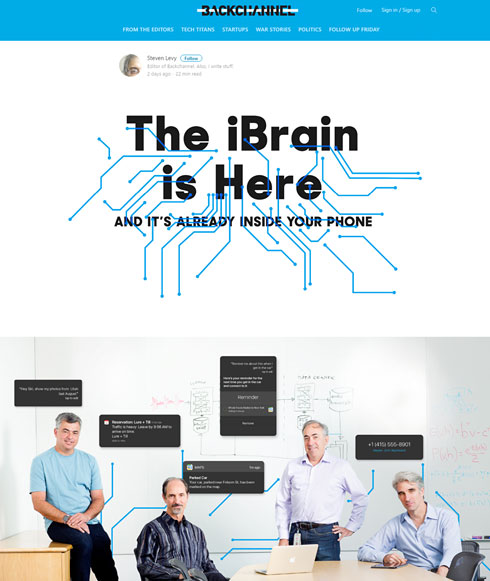

さて、今週前半にそのレヴィさんが「iBrain is Here」というタイトルのApple幹部インタビュー記事を公開しました。

インタビューのお相手は、おなじみの明るい上級副社長コンビ、エディ・キュー氏とクレイグ・フェデリギ氏、フィル・シラー上級副社長に加え、Siri(企業の方)の共同創業者で今もSiri(サービスの方)の責任者を務めるトム・グルーバー氏、Siriのシニアディレクターのアレックス・アセロ氏の5人です。

内容は主に人工知能(AI)の取り組みについて(記事タイトルのiBrainというのはそこから来てます)、特にSiriのAI機能についてです。

週末に全部読んでいただくのが一番いいですが、すごく長い記事なので、面白かったところを少しご紹介します。

Appleだって普通に人工知能を使っている──プライバシーを尊重しつつ

最近ではAI関連の記事がテクノロジー系メディアに載らない日はない印象ですが、その常連はGoogle、Facebook、Microsoftで、Appleの名前はあまり出てきません。

でも、シラー氏によると「Appleでは過去5年くらいで(人工知能技術が)かなり成長している」そうです。記事にならないのは(他社のように)AI、AIと騒ぐことはせず、ディープラーニングも機械学習も、一連の新技術の流れの一部であり、「Appleはいつも、実現したい機能に役立つ技術を採用するだけ」(シラー氏)なので、特に発表しないからみたいです。

いちいち発表はしませんが、既にApple製品の至るところにAI技術が使われているそうです(Siriはもちろん、Apple Pencilのパームリジェクションなどにも)。

ちまたでは、Appleはユーザープライバシーを尊重するあまり、(「Google Now」のような)ユーザーの予定表や連絡先と深く連係したアシスタントサービスは難しいだろうし、機械学習やディープラーニングに欠かせない餌としてのデータを集められないから、この分野では不利だと言われていますが、このインタビューでは「そういう問題は解決した」とのことです。

まず、別にユーザーのプライベートな情報を収集しなくても、そういうデータはiPhoneやiPad内にあるものを使えば十分なのだそうです。フェデリギ氏は、iPhoneの右スワイプで表示されるSpotlightの「Siriの検索候補」を例として挙げました。

機械学習が使うiPhone内のキャッシュサイズはわずか200MB前後。アプリの使用履歴、キーボードからの入力履歴、他のユーザーとのコミュニケーション履歴、顔認識などの情報(常に更新されている)が、iPhone内で機械学習を助けているそうです(Spotlight、マップ、Safariなどが参照している)。iPhoneの中にあるから、プライバシーは守られています。

餌集め問題については、「写真」のための画像認識の訓練などなら公開されている画像で可能ですが、「この辺に住んでるこういう好みの人にはこのレストランを勧める」というようなサービスのためには、どうしてもユーザーベースのデータが必要です。

そこで「iOS 10」から、匿名化したユーザーデータを収集する新しい技術「differential privacy」を採用するそうです。フェデリギ氏がその技術について説明してくれたけど、「暗号化についての本も書いた私でもついていけない内容だった」とレヴィさん。ともかくこれが始まると、プライバシーは守られたまま、お勧めレストランやフライト情報の提供など、Google Now的な、ユーザー情報と深く関連したアシスタントができるようになるようです。

SiriのAI化はiOS 10で最終段階に

キュー氏によると、Siriは4つのコンポーネントで成り立っているとのこと。それは、音声認識、自然言語理解(NLU)、命令の実行、音声あるいはテキストでのレスポンス、の4つです。

Appleは2010年に買収したSiriの技術を2011年10月発売の「iPhone 4S」から搭載しています。特に発表はしていませんが、2014年7月(世界では8月15日)に音声認識システムをニューラルネットワークベースに移行しました。知りませんでした……。そのはずです。このインタビューで初めて明かされたんですから。

ニューラルネットへの移行により、Siriでサポートする全国語で音声認識のエラーレートが半分になったそうです。

2つ目のコンポーネント、NLUで機械学習技術を採用したのは2014年11月のこと。その約1年後にさらに改良し、それで「Apple TVのSiriで『トム・ハンクスが出てるスリラー映画』と言うだけで『ダ・ヴィンチ・コード』が出てくるようになったんだよ」とフェデリギ氏は語っています。

そして、iOS 10では、4つ目のコンポーネントのうちの、声でのレスポンスにも機械学習技術が採用されます。声自体は従来通り人間の声を録音したものですが、これをツギハギするのに機械学習を使うことで、より人間っぽい話し方になるそうです。

これは楽しみです。Siriがもっと人間っぽくなったら、もしかしたら『her/世界でひとつの彼女』のような恋が生まれるかも。

関連記事

Apple Musicを仕切るノリノリの女性“Boz”はどんな人?

Apple Musicを仕切るノリノリの女性“Boz”はどんな人?

Apple幹部らしからぬビジュアルとパフォーマンスでWWDC 2016の会場を盛り上げたApple Music担当の女性“Boz”に迫ります。 Appleの「Home」アプリはGoogleより1歩リードかも

Appleの「Home」アプリはGoogleより1歩リードかも

じわじわとAppleのスマートホームが進化しています。 決算会見に見え隠れする米IT企業トップの個性

決算会見に見え隠れする米IT企業トップの個性

終始冷静な人、顔に出る人、ファッションが楽しみな人、いろいろです。 人工知能にヘイトスピーチを覚えさせる残念な人たち

人工知能にヘイトスピーチを覚えさせる残念な人たち

差別的発言を繰り返した人工知能「Tay」が話題ですが、それを仕込んだのはもちろん人間です。しかし、こうした行為は結果的に人工知能を鍛えるかもしれません。

関連リンク

Copyright © ITmedia, Inc. All Rights Reserved.