目を持つ国産生成AI「Sarashina2.2-Vision」 開発者が「ライバルまであと1歩、2歩」と語る性能になるまで:“海外勢に肉薄”する性能

「目を持つ生成AI」として、画像を理解する「視覚言語モデル」(VLM:Vision Language Model)の国産化に乗り出したSB Intuitions。先行する海外勢を前に、担当者は「あと1歩、2歩でライバルの背中が見える位置まで来ました」と語る。国産VLMをいかにして作り上げたのか。

生成AI開発を巡る局面が変化している。大規模言語モデル(LLM)の性能向上を追求しつつ、画像や音声、動画なども理解する「マルチモーダルAI」の開発に各社がしのぎを削っている。その一つが、言語に加え視覚情報を理解できる「視覚言語モデル」(VLM:Vision Language Model)だ。

このVLMは画像や音声、動画などを理解するマルチモーダルAIを構成する重要な要素になる。VLM開発を巡っては米国勢が先行し、すでにマルチモーダルAIとしてOpenAI「GPT-5」やGoogle「Gemma 3」「Gemini 3」などが発表されている。中国のAlibabaもオープンソースモデル「Qwen VLシリーズ」を公開した。

海外企業の動きを受けて「国産のVLMを」と立ち上がったのが、ソフトバンク子会社のSB Intuitionsだ。同社は3月にVLM「Sarashina2-Vision」を公開。日本語性能を測る複数のベンチマークテストにおいて高い性能を実現しており、11月には改良版の「Sarashina2.2-Vision-3B」をリリースした。

開発を指揮した田中稔之氏は「あと1歩、2歩でライバルの背中が見える位置まで来ました」と語る。SB Intuitionsは、国内屈指のVLMをいかにして作り上げたのか。

国産VLMを完成させるも海外勢と「かなり差がある」

セキュリティやデータ主権の観点から国産の生成AIが求められる中、同社は既に4600億パラメーターのLLM「Sarashina2-8x70B」を完成させ、次の一手としてVLM開発に乗り出した。田中氏は「日本語特有の画像やグラフを理解できることが、国産モデルの強みになります」と話す。

例えば、とある橋の写真があるとする。山中にある武骨な橋で、看板の情報から「祖谷の蔓橋(いやのかずらばし)」という名前だと分かる。この写真をSB Intuitions のVLM(Sarashina2.2-Vision-3B)に渡して「どんな橋ですか?」と聞くと、「徳島県三好市・祖谷渓にある伝統的な吊り橋で(略)ツタやツル植物を編んで作られた蔓(かずら)で……」と、文化的背景を交えて解説してくれる。

このような日本の地理や文化的な背景を理解できるのが、国産VLMの強みだ。VLM開発は海外企業が先行しているが、日本語や日本文化の学習が十分でない場合もある。例えば、認識できない片仮名や漢字があったり、姫路城の写真に対して「名古屋城です」と誤答したりしてしまう。

こうした問題に対して、田中氏は「姫路城の歴史的背景まで答えられる、居酒屋メニューのくずし字を解読できる、そんなAIを作ることに意味があります」と話す。また、国産VLMをベースにした国産汎用(はんよう)基盤モデルが完成すれば、地政学リスクなどがなく、セキュリティ面でも信頼性を担保できる。製品の設計図や機密情報を含む資料をAIで要約したり分析したりできるようになり、AIのビジネス利用が加速するはずと、長所を挙げる。

VLM開発ののろしが上がったのは2024年10月。小規模のチームで開発を始め、2025年3月に初期モデルであるSarashina2-Visionを完成させた。同モデルは、日本語ベンチマークにおいて高い性能を記録。海外のLLMをチューニングして作った国産VLMが多い中、Sarashina2-Visionは同社の国産LLMを土台にしている点がユーザーや関係者に高く評価された。

しかし、目指す海外勢の背中はあまりにも遠かった。田中氏は「ライバル」として海外製モデルの名前を挙げ、「3月時点ではかなり差があると感じました」と振り返る。社内からも「出力が淡泊すぎる」「推論能力が弱い」といった厳しい声が寄せられた。

改善の末に完成させた最新モデル

VLMの改善に努めた田中氏らは、Sarashina2.2-Vision-3Bを11月に公開。30億パラメーターという軽量モデルでありながら、日本文化の理解力や推論能力が強化され同サイズ帯でトップクラスの性能を記録。海外のライバル企業に肉薄する位置まで迫っている。

完成したSarashina2.2-Vision-3Bを使ってみると、その実力が遺憾なく発揮された。浮世絵を紹介する観光案内板の細かい文字を読み取って説明する、飲食店のレイアウトが崩れたメニュー表を理解する、など多様なシーンで日本語理解の能力を示した。

日本語理解以外でも高い性能を見せた。例えば、田中氏が昼食の写真を入力して「カロリーを計算して」と指示すると、妥当な数値を算出した。これはVLMにカロリー計算の知識を意図的に学習させたわけではなく、学習段階で食材の写真とそのカロリーをひも付けて学習させていたことに基づくもの。LLMの知識や推論能力を引き出した例といえる。

データに混ざるノイズとの戦い

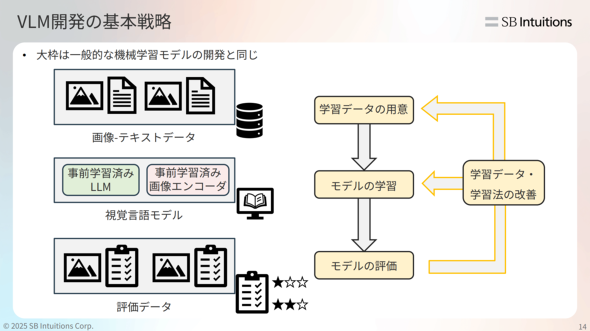

Sarashina2.2-Visionは3つの要素――入力された画像から特徴量を抽出する「画像エンコーダー」、画像の特徴量をテキストトークンに変換する「プロジェクター」、トークンを受け取って内容を理解したり回答を生成したりする「LLM」で構成されている。

各要素が異なるデータで学習されていたため、そのままでは相性が悪かった。そこで多数のデータ――画像に写る風景や物体を説明した画像キャプショニング、日本語や英語のドキュメント、日本固有の知識に絞ったデータを集めてチューニングし、VLMの性能を向上させた。使ったデータは1000億トークンを超え、これはSarashina2-Visionの5倍以上になると田中氏は説明する。

大規模なデータを学習させるに当たり、GPUメモリにデータを載せるための実装や効率的に学習させるための工夫に時間をかけた。SB Intuitionsは、ハイエンドGPUを載せた「NVIDIA DGX B200」を含む1万基以上のGPUを備えた計算基盤を有している。それをもってしても「ライバル視している企業に比べれば多いわけではなく、GPUリソースに余裕がない状況だった」(田中氏)と振り返る

データセットの用意に苦労したと話すのは、開発メンバーの高田拓実氏(高は「はしごだか」)だ。画像データにラベルを付ける、画像の多様性を確保する、といった作業を人手やAIでこなした。日本語のラベル付き画像が足りないため、Sarashinaを使って合成データセットを作成した。一連の作業において特に神経をとがらせたのが、データに含まれるノイズの除去だと高田氏は話す。

「特にデータのフィルタリングには苦しめられました。品質が悪いデータが少しでも混ざると、VLMの振る舞いが変わったりハルシネーションが起きたりするからです。性能評価のスコアを上げるのは難しく、落とすのは簡単です。フィルタリングの強さや内容を調整する、二重、三重にフィルタリングをする、などノイズの除去に苦慮しました」

“人間好みの出力”をどう出すか

VLMの興味深い点として高田氏は「VLMと人間で画像の認識方法が異なると感じることがあります」と述べる。例えば、新宿や渋谷など繁華街の写真をVLMに見せると、歩行者が写っていなくても「歩行者がいる」と回答することがある。学習データに含まれる頻出パターンの影響を強く受けており、画像に写る情報よりもAIに蓄えられた“常識”が優先されてしまった例だ。AIの推論の仕組みには課題もあると分かる。

数学や物理の問題を解ける能力を持ちながら、人が一目で見て分かることに誤答するといった挙動を見せるVLM。データセットを洗い直したりモデル構造を確認したりと「人間の常識や先入観を捨てて分析、調整する必要があり、難しくもあり面白くもあります」(高田氏)

誤答を減らすだけでなく、“人間好みの出力”にするための調整もした。「人間が『良い』と判断するデータ」「人間が『微妙だ』と思うデータ」を使って出力内容を調整することで、素っ気ない回答を減らすなど実用に堪えるVLMに仕上げた。

LLMにない処理が絡むVLMを正しく評価する

VLM開発と並行して進められたのが、VLMを評価するための仕組み作りだ。「開発中のモデルがどの程度の性能なのか」「他社の最新モデルと比較して立ち位置はどこか」などを客観的に評価し、その結果を開発チームにフィードバックしてVLMをブラッシュアップする。そこにはVLMならではの難しさがあると、評価チームの幡谷龍一郎氏は言う。

「各社のVLMを正しく評価するには、実行環境の差を取り除く必要があります。画像を扱うVLMは、LLMにはない処理が絡むため『最適なライブラリがモデルごとに異なる』『特定のバージョンでは動かない』といった制約にぶつかることもあります。比較するモデルが増えると大変で、トライ&エラーの連続でした」

この課題に対して、モデルごとに仮想環境を立てるなど実行環境を用意し、ベンチマークごとの結果を一覧で見られるよう仕組みを整えた。これを開発チームが確認し、「計算問題の正答率がこれだけ上がった」「グラフの読み取りが改善した」などの結果を踏まえて新たな改善に着手。結果、開発チームから「評価が簡単になった」などの声が上がり、開発サイクルのスピードアップにつながった。

「AI技術は日進月歩のため『昨日は動いていたAIの実行環境が、今日は動かない』ということも多々あります。性能が実行環境に依存するため調整が大変ですが、開発チームが気にしなくて済むように努めています」

Sarashina-Visionの進化は止まらない

高いレベルのVLM開発に成功したSB Intuitions。マルチモーダルAIの実現に向け、次の目標に掲げるのが「動画を理解できるAIモデル」の開発だ。動画は1秒間に何枚もの画像が含まれるため、AIがそれを理解するためのデータ量は飛躍的に増加する。トークン量をいかに圧縮するかが課題だと田中氏は述べ、次のように結んだ。

「最新モデルはSarashina2.2-Vision-3Bです。これをバージョンアップするときには動画を扱えるようにしたいですね。既に準備を始めています。2026年に期待してください」

関連記事

アメリカのLLMでよくない? 国内屈指のGPUスパコンで「国産・大規模・高性能」モデル開発中のSB Intuitionsに疑問をぶつけてみた

アメリカのLLMでよくない? 国内屈指のGPUスパコンで「国産・大規模・高性能」モデル開発中のSB Intuitionsに疑問をぶつけてみた

気付いたら「国産LLM」を作っていた──HPCエンジニアがAIの世界へ飛び込んだワケ 「GPU1万基以上持つ会社」での仕事

気付いたら「国産LLM」を作っていた──HPCエンジニアがAIの世界へ飛び込んだワケ 「GPU1万基以上持つ会社」での仕事

関連リンク

Copyright © ITmedia, Inc. All Rights Reserved.

提供:SB Intuitions株式会社

アイティメディア営業企画/制作:ITmedia AI+編集部/掲載内容有効期限:2026年2月3日

SB Intuitionsの田中稔之氏(Vision AI部 VLM Trainingチーム リーダー)

SB Intuitionsの田中稔之氏(Vision AI部 VLM Trainingチーム リーダー)

SB Intuitionsの高田拓実氏(Vision AI部 VLM Trainingチーム)

SB Intuitionsの高田拓実氏(Vision AI部 VLM Trainingチーム) SB Intuitionsの幡谷龍一郎氏(Vision AI部 VLM Evaluationチーム)

SB Intuitionsの幡谷龍一郎氏(Vision AI部 VLM Evaluationチーム)