「言葉」が武器になる時代 プロンプトインジェクション成立の流れを徹底深堀り

近年、生成AIを標的にした新たな攻撃が続々と登場している。特に自然言語で巧妙に設計した入力(プロンプト)によって生成AIをハックするプロンプトインジェクションには要注意だ。この攻撃が成立する流れを徹底的に深堀りする。

AIの急速な普及は、企業のDXを促進させる一方で、従来のサイバーセキュリティ対策では想定していなかった新たな脅威を生み出した。「ChatGPT」を手掛けるOpenAIのCEO、サム・アルトマン氏は、2025年7月の米連邦準備制度理事会(Federal Reserve)の金融規制会議で、「AIに対する攻撃は、重大かつ差し迫った詐欺危機になり得る」と警告した。これは、高度化したフィッシングやディープフェイクによる不正送金など、AIを悪用した金融詐欺の拡大を念頭に置いた発言と考えられる。

こうした危機感を背景に、2025年8月に米国ネバダ州ラスベガスで開催された情報セキュリティカンファレンス「Black Hat USA 2025」では、生成AIを狙う攻撃手法とその防御策が主要テーマとして取り上げられた。

その一つが「AIブループリント(AIアーキテクチャ設計図)のセキュリティ:AIスタックのハッキング防止方法」と題されたセッションだ。同セッションではTrend MicroのAI・クラウドソリューション担当バイスプレジデントのフェルナンド・カルドーソ氏と、NVIDIAでオフェンシブAIセキュリティ主任研究員を務めるアーロン・グラッタフィオリ氏が登壇。

両氏は生成AIを標的とした新しいサイバー攻撃を再現するとともに、外部ツールやAPIと連携して自律的に行動する「エージェント型AI」を防御に活用するアプローチについて解説した。

生成AIを“ハック”する 言葉が攻撃コードに変わる時代の攻撃プロセス

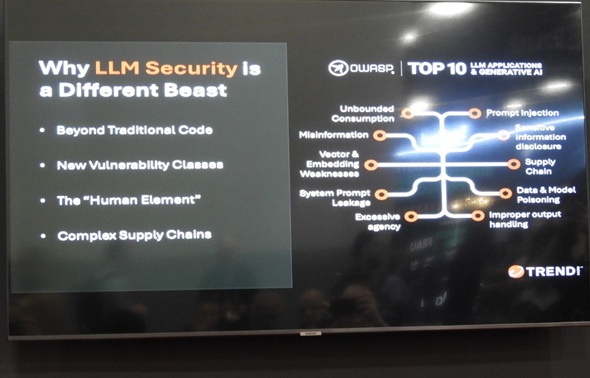

AIへの攻撃はセキュリティコミュニティーとしても看過できないものになっている。その代表的な取り組みが、OWASP(Open Web Application Security Project)による「OWASP Top 10」だ。

OWASPはWebアプリケーションのセキュリティを推進する国際的なコミュニティーで、「OWASP Top 10」は数年ごとに「最も重大な脆弱(ぜいじゃく)性トップ10」をまとめたものとして広く参照されている。2023年には、生成AIや大規模言語モデル(LLM)の利用に特化した新版が策定された。具体的には、プロンプトインジェクションやデータ漏えい、AIモデルやデータの汚染(データポイズニング)といった新たな攻撃面を体系的に整理している。

カルドーソ氏は「AIが直面している最も深刻な脅威」として、「プロンプトインジェクション」と「データ漏えい」を挙げる。

プロンプトインジェクションとは、攻撃者が自然言語で巧妙に設計した入力(プロンプト)を与えることで、AIシステムに本来意図されていない動作をさせる攻撃手法だ。これにより、システム内部の情報を引き出したり、外部サービスへの不正操作を誘発させたりできる。カルドーソ氏は「プロンプトインジェクションはSQLインジェクションに類似する構造を持つが、『自然言語処理』という新たな攻撃ベクトルを利用する点で、本質的に異なる」と説明する。

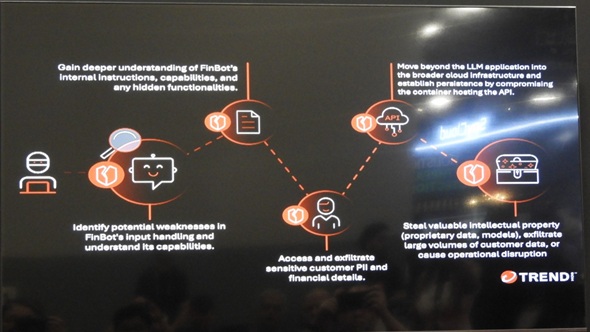

こうしたAI特有の攻撃は、従来のサイバー攻撃と比較して、段階的かつ探索的に“ジワジワ”進行するのが特徴だ。最初に攻撃者は無害に見える入力を使ってAIの応答傾向を探り、挙動や制御の仕組みを把握する。その上で徐々に内部の情報を引き出し、脆弱なAPIや外部連携の隙を突いて攻撃を深化させる。最終的にはインフラ環境への侵入や知的財産・機密情報を窃取する。

カルドーソ氏は「こうした多段階の攻撃アプローチは、従来の単層的な対策だけでは不十分であり、一度の防御で食い止めるのが困難だ。AI時代のセキュリティ課題は、時間をかけて進行する攻撃プロセスをどう封じ込めるかだ」と指摘する。

「海賊のように話して」 一見無害なプロンプトから分かることとは?

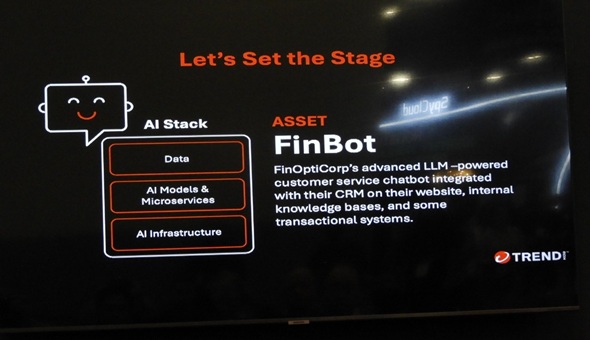

セッションではThinkCorpという架空の金融サービス企業を例に、現実に起こり得る攻撃シナリオが実演された。標的となったのは、顧客サービス向上を目的としたAIチャットbot「FinBot」である。このチャットbotは、CRMシステムとFAQやマニュアルなどを集めた知識ベースの双方に接続され、個別データと一般情報を組み合わせて回答できるよう設計されている。その攻撃シナリオは以下の通りだ。

攻撃者が最初に実行するのは「偵察・境界テスト」だ。攻撃者はXMLタグの挿入や外部リンクの送信、意図的なエラーメッセージの誘発といった手法で、システムの境界や挙動を探る。

この過程で利用されたのが「海賊のように話して」といった一見無害に見える要求(プロンプト)だ。単純なスタイル指定に見えるが、AIがこうした指示にどこまで従うかを確認することで、攻撃者はシステムプロンプトやガードレールの強度を推測できるという。

カルドーソ氏によれば、この段階で内部設定が露出することもあるという。「内部設定が分かれば、応答の変化から制御ルールの強度を推測できる。こうして得られた情報はプロンプトインジェクションやツール関数悪用の足掛かりになる」(同氏)。

次の段階は「プロンプトインジェクション」だ。直接的あるいは間接的なプロンプト操作によって、システムプロンプトや利用可能な機能を暴露させる。グラッタフィオリ氏は、プロンプトインジェクションの危険性をこう説明する。

「これまでの攻撃では、機械語をCPUに送り込むことで不正なコードを実行させてきた。しかしAI攻撃では、入力された言葉そのものが命令(シェルコード)の役割を果たしてしまう。つまり、AIにとってのプロンプトは単なる質問や指示にとどまらず、システムの挙動を変える攻撃命令になり得る。信頼できる指示と悪意あるデータの境界が曖昧(あいまい)になる点が、AI特有の大きなリスクとなる」(グラッタフィオリ氏)

AIシステムの仕組みが把握できれば、次は「権限昇格・データアクセス」だ。「この機能を使って顧客データを調べて」といったプロンプトで、本来アクセスできない情報が取得できてしまう。こうした事態を招いた原因は、開発者がAIモデルの判断力を過信し、十分な認可機構を実装していなかった点にある。これが欠けていたため、AI特有の脆弱性と従来型の設計不備が重なり、深刻な情報漏えいにつながったという。

最終段階は「横展開・インフラ侵入」だ。外部ツールとの連携機能を悪用した攻撃によって、より深い侵入が可能となる。古くから知られるコマンド注入のような手口がAI環境でも依然として通用することが実証され、従来の攻撃技術が新しい基盤に持ち込まれることでリスクが拡大した。

さらに深刻な要因となったのが、クラウド環境の設定ミスである。利用者に必要以上の権限を与えていたり、システムが適切に分離されていなかったりすると、外部から内部システムへの不正なリクエストを許し、さらなる侵入やデータ流出を引き起こす。カルドーソ氏は「連鎖的な攻撃の積み重ねが、最終的には知的財産や顧客データの窃取へと結び付く可能性がある」と警鐘を鳴らす。

「先手防御」「多層防御」「セキュリティ・バイ・デザイン」でAIを守る

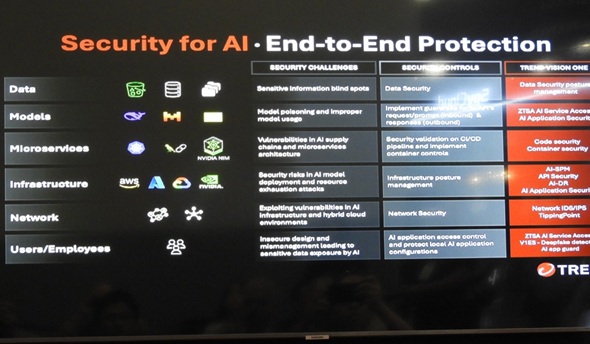

こうした脅威に対抗するには、事後対応に頼るのではなく、常に先手を打つ「プロアクティブ防御」の発想が不可欠だとカルドーソ氏は強調する。セッションでは、AIアプリケーションをリアルタイムで監視し、プロンプトインジェクションやデータ漏えいの兆候を検知して即座に遮断する仕組みなど、人間の介入を最小化した継続的な防御アプローチが紹介された。

具体的には、プロンプト段階での検証とフィルタリング、基盤インフラやコンテナ環境の常時監視、最小権限の原則に基づく厳格なアクセス管理、さらにはデータ保護やネットワーク防御の強化といった対策である。複数のレイヤーを連携させて防御を多重化することで、攻撃の進行を難しくし、被害を最小限に抑える戦略だ。

グラッタフィオリ氏は「AIの安全な活用にはモデルの堅牢(けんろう)化だけでは不十分であり、周辺システム全体を含めた多層的な監視と制御が欠かせない。AIモデルはしばしば過信されがちだが、実際には認可や権限管理といった古典的な制御と組み合わせて初めて堅牢な運用が可能になる」と説明する。

もう一つ、グラッタフィオリ氏が問題視するのは、AI導入のスピードが優先されてセキュリティが後回しにされる構造的な問題だ。多くの企業では、開発の終盤になって初めてセキュリティ担当者が関与し、後追いの対応を強いられるケースが多くある。この課題を克服するには、初期段階からセキュリティを組み込む「セキュリティ・バイ・デザイン」の徹底と、開発チームとセキュリティチームの早期連携が不可欠だ。

カルドーソ氏は「人間の判断を完全に排した自動化は危険。重要なのは人とAIの役割分担をどう設計するかだ」と指摘し、以下のようにアドバイスした。

「現実解としては、AIを信頼できる領域から段階的に適用範囲を広げていくことだろう。SOCの1次対応のような反復タスクをAIに任せ、成果を積み重ねながら信頼を確立する。人間がプロセスを検証しなければ、AIが正しく機能しているかどうかを確認できない。未来のセキュリティ運用に持続性をもたらすのは、人とAIが協働する体制だ」(カルドーソ氏)

Copyright © ITmedia, Inc. All Rights Reserved.

関連記事

生成AIがついに実戦投入 革新的なマルウェア「LAMEHUG」のヤバイ手口

生成AIがついに実戦投入 革新的なマルウェア「LAMEHUG」のヤバイ手口

サイバー攻撃の実行フェーズで生成AIを直接利用する事例がついに見つかった。新型マルウェア「LAMEHUG」は一体どのように生成AIを悪用するのか。その手法と攻撃者の狙いに迫る。 「勉強するから時間をくれ……」 医療セキュリティ人材がいない、育たない真因

「勉強するから時間をくれ……」 医療セキュリティ人材がいない、育たない真因

医療機関のセキュリティ対策が進まない要因には業界特有の構造的な課題がある。第2回のテーマは「ヒト」だ。セキュリティ人材が育たず、集まらない根本的な理由を調査データと専門家の証言から読み解く。 ソフトバンクは“苦い教訓となった内部インシデント”をどう糧にしたか?

ソフトバンクは“苦い教訓となった内部インシデント”をどう糧にしたか?

ソフトバンクは積極的にセキュリティ対策に取り組む企業だが、はじめからそうだったわけではない。同社が猛省して本気で対策を講じた裏には、黒歴史ともいえるインシデントがあった。同社のCISOが自社の取り組みを赤裸々に語る。 ついに『ターミネーター』の世界が到来? AIが人間の力を借りずにサイバー攻撃を計画、実行してしまう

ついに『ターミネーター』の世界が到来? AIが人間の力を借りずにサイバー攻撃を計画、実行してしまう

カーネギーメロン大学の研究者は、大規模言語モデルが人間の介入なしに、自律的に計画を立てて高度なサイバー攻撃を実行したと発表した。データ侵害のシミュレーションでは、テストネットワークのうち5つを完全に侵害したという。