Apple、ジェスチャー命令や空間手描きを可能に Vision Frameworkの新機能を紹介:WWDC 2020

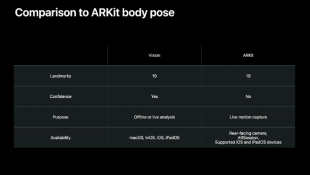

ARKitにも類似の機能があるが、それとはどこが違うのか。

Appleは、WWDC 2020で「Detect Body and Hand Pose with Vision」を公開し、AppleのComputer Vision Frameworks担当マネジャーであるブレット・キーティング氏は、カメラで自撮りする場合、手でOKを示す形を作るとセルフタイマーが発動したり、手のポーズに合わせて変わる「ハンド絵文字」などが利用可能になると説明している。

これらは、顔認識で使用するVision Frameworkのクラス「VNImageRequestHandler」で利用可能になる。

このポーズ認識を使用することで、ある決まったポーズをとった瞬間だけ写真撮影ができたり、決められたポーズに合致した場合のみ写真撮影をすることで連続写真も撮影できると説明している。

FaceTimeカメラを使用し、画面に触れずに手描きしたりできる「Hand Pose Detection」も利用可能になる。

多数の手がある場合、一番手前の手からいくつまでの手を認識するかも決められる。

Create MLとVision Frameworkを組み合わせた場合、ランドマーク数は最大19カ所とARKitと同じだが、オフラインでも解析可能で、iOSおよびiPadOSの背面カメラを使用したライブモーションキャプチャーだけでなく、macOS、tvOS環境下のカメラであれば使用可能になるという汎用性がある。

サンプルコード「Building a Feature-Rich App for Sports Analysis」を使用することで、iOS 14のVisionとCore MLで利用可能ないくつかの新機能を確認できる。

Copyright (C) 1998 Mac Treasure Tracing Club. All rights reserved.

関連記事

iOS 14、iPadOS 14、macOS Big Surの日本向け機能まとめ

iOS 14、iPadOS 14、macOS Big Surの日本向け機能まとめ

翻訳機能など、日本語関係がかなり強化されている。 Apple、LiDARスキャナーをサポートした「ARKit 3.5」公開

Apple、LiDARスキャナーをサポートした「ARKit 3.5」公開

AppleのARプラットフォームが、新型iPad Proに搭載されたLiDARで大きく進化した。 AirPodsでヒソヒソ音声入力 口を手で押さえるジェスチャーで 清華大学など発表

AirPodsでヒソヒソ音声入力 口を手で押さえるジェスチャーで 清華大学など発表

直感的なジェスチャーでひそひそ音声入力を起動できる。