Apple、児童保護目的でユーザーの「メッセージ」とiCloudの「写真」の画像検出を実施へ

Appleは児童保護の目的でユーザーのコンテンツを検出する機能を追加する。「メッセージ」とiCloudの「写真」が対象。まずは米国で年内に開始する計画だ。

米Appleは8月5日(現地時間)、児童保護の目的でサービスに3つの新機能を追加すると発表した。「コミュニケーションツールを使って児童を虐待する悪人から児童を保護し、児童性的虐待コンテンツ(Child Sexual Abuse Material、CSAM)の拡散を制限したい」としている。

発表されたのは、「メッセージ」アプリでやり取りされるCSAMを検出して警告する機能、クラウドストレージiCloud上に保存されている画像にCSAMがある場合、これを検出してアカウントを無効にする機能、Siriや検索でCSAM関連の検索をすると警告する機能の3つだ。

いずれもまずは米国で、iOS 15、iPadOS 15、watchOS 8、macOS Montereyのアップデートで年内に追加される見込みだ。

「メッセージ」でのCSAM警告

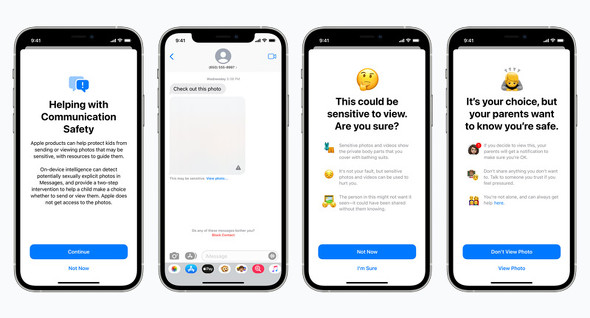

メッセージで性的に露骨な写真を児童と送受信しようとすると、当事者である児童とその保護者に警告するようになる。

CSAMを受信すると画像がグレー表示になって警告が表示される。それでも画像を見ようとすると、「見たら両親にメッセージを送る」と警告する。児童が自分の性的に露骨な写真を送信しようとした場合も同じような警告が表示される。

CSAMかどうかの解析は、端末内の機械学習機能を使って行うため、Appleはメッセージにアクセスしない。

この機能は、Appleの「ファミリー共有」を使っているユーザー向け。初期設定は無効になっており、オプトインで利用する。また、12歳以下の児童が対象だ。

iCloudの「写真」でCSAMを検出したらユーザーアカウントを無効に

iOSおよびiPadOSの新技術で、iCloudの「写真」に保存されている既知のCSAM画像を検出できるようになった。この技術をiOSおよびiPadOSのバージョン15に搭載する。こちらはオプトインではなく、iCloudの「写真」を使っている米国ユーザーが対象になる。

この技術で「写真」に一定数以上(一定数が何枚なのかは非公表)のCSAM画像が保存されていると確認できた場合、そのユーザーのアカウントを無効にし、米非営利団体の全米行方不明・被搾取児童センター(NCMEC)に報告する。アカウント無効が誤りだと思うユーザーは、復元を求められる。

この技術はAppleがiCloud内の画像をスキャンするわけではなく、NCMECなどが提供している既知のCSAM画像ハッシュのデータベースと端末上のデータのマッチングを行う。まずハッシュデータベースをユーザーの端末に保存し、ユーザーが既知のCSAM画像を保存しようとするとマッチングプロセスで検出する。この照合プロセスは暗号化されており、一致があるかどうかのみを判断する。

既知のCSAM画像と一致するかどうかを照合するので、例えばユーザーの娘の入浴画像などがCSAMとして検出されることはない。

このプロセスでCSAMが多数あると判断された場合、Appleは手動で確認してから当局に報告し、アカウントを無効にする。この確認も、Appleが画像そのものを目視するのではなく、CSAMデータベースのアイテムと一致する画像の“安全バウチャー”を検査する。この方法についてはAppleが公開している資料(PDF)を参照されたい。

Siriと検索での警告

ユーザーがSiriや検索でCSAMに関連するワードを検索すると、警告する。Appleのサンプルには「オンラインでの児童搾取を報告するためのシステムがあります(報告する)」「児童虐待を描いたマテリアルは違法です。危険な考えや行動を持つ大人のための匿名のヘルプラインとガイダンスがあります(ヘルプについての詳細を見る)」という警告が表示されている。

Copyright © ITmedia, Inc. All Rights Reserved.

関連記事

「Google フォト」対「Box」 プランの比較から見る各社の狙い

「Google フォト」対「Box」 プランの比較から見る各社の狙い

2021年5月末に終了した、「Google フォト」の無料無制限バックアップサービス。移行を検討するユーザーにとって、移行先の有力候補の一つである「Box」と比較し、各サービスの狙いを読み解く。 米巨大オンライン掲示板「Reddit」で大騒動 運営の恣意的な投稿削除にユーザー反抗、一時は事実上の機能不全に

米巨大オンライン掲示板「Reddit」で大騒動 運営の恣意的な投稿削除にユーザー反抗、一時は事実上の機能不全に

米巨大オンライン掲示板「Reddit」で、サイト開設以来最大ともいえる炎上と経営危機があった。運営の恣意的な削除に対し、ユーザーは“板”の非公開で応戦。サイトは事実上の機能不全に陥った。顛末や背景を解説する。 Apple、4月最終週の「iOS 14.5」リリースでATTのトラッキング申請機能スタート

Apple、4月最終週の「iOS 14.5」リリースでATTのトラッキング申請機能スタート

Appleが4月26日の週に「iOS 14.5」をリリースすると発表した。このアップデートで、かねて予告していた「AppTrackingTransparency」(ATT)を通じてのアプリでのトラッキング許可カードの表示が始まる。