「GPT-4」は論文の査読ができるか? 米スタンフォード大らが検証 参加者の80%以上「AI査読は有益」:Innovative Tech(1/2 ページ)

米スタンフォード大学、米ノースウェスタン大学、米コーネル大学に所属する研究者らは、大規模言語モデル(LLM)が研究論文の査読を行えるかを調査した研究報告を発表した。

Innovative Tech:

このコーナーでは、2014年から先端テクノロジーの研究を論文単位で記事にしているWebメディア「Seamless」(シームレス)を主宰する山下裕毅氏が執筆。新規性の高い科学論文を山下氏がピックアップし、解説する。

Twitter: @shiropen2

米スタンフォード大学、米ノースウェスタン大学、米コーネル大学に所属する研究者らが発表した論文「Can large language models provide useful feedback on research papers? A large-scale empirical analysis」は、大規模言語モデル(LLM)が研究論文の査読を行えるかを調査した研究報告である。この検証のため、論文の査読を自動で行うシステムと、LLMによる査読コメントと人間による査読コメントとの間の共通点を探るシステムを開発した。

学術雑誌に投稿される研究論文は、掲載の是非を含めて、専門分野の研究者らによって査定される。この査定のプロセスを査読と称し、研究者にとって、時間と労力の大きなタスクである。論文の提出数の増加を鑑みると、高品質のフィードバックを提供する資格のある査読者を十分に確保することは、次第に困難になっている。

この研究では、LLMを用いて科学的フィードバックを生成する際の有用性と信頼性を大規模で体系的に分析することで明らかにする。

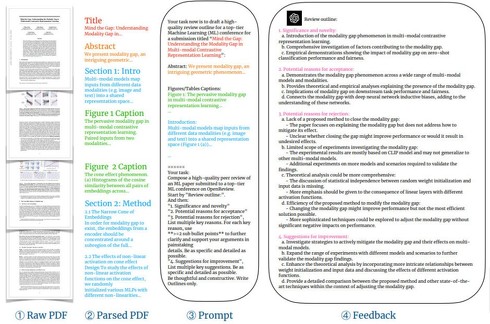

具体的には、まず米OpenAIの「GPT-4」を用いて、科学論文のPDFに対するフィードバックを生成するための自動化パイプラインを構築した。このシステムは、初めにPDFを解析し、GPT-4用の特定のプロンプトを作成する。このプロンプトは、設計した指示に従い、論文のタイトルやアブストラクト、図や表のキャプション、その他の主要テキストを組み合わせて生成される。

このプロンプトをGPT-4に供給することで、科学的なフィードバックを生成できる。このフィードバックには、研究の重要性や新規性、受け入れるための理由、拒否するための理由、改善の提案などが含まれている。

さらに、LLMと人間の査読者のフィードバックの重複を評価するためのコメントマッチングパイプラインも開発した。

「Nature」系列ジャーナルなどを学習 AI査読の結果は?

GPT-4で生成したフィードバックの情報性を評価するため、2つの大規模なデータセットを使用し、提出された論文に対する人間のフィードバックとLLMのフィードバックの内容の重複を体系的に調査した。

第1のデータセットはNature系列のジャーナルから取得したもので、3096の受理された論文に関する人間の査読者からの8745のコメントを含んでいる。これには「Nature」「Nature Biomedical」「 Engineering、Nature Human Behaviour」「Nature Communications」などの15のNature系列のジャーナルが含まれる。

第2のデータセットは、コンピュータサイエンスの人工知能研究の主要な会議であるICLRから1709の論文に関する人間の査読者からの6505のコメントを含んでいる。

これら2つのデータセットは、異なる科学分野や影響度における著名なジャーナルを幅広くカバーする第1のデータセットと、急速に進化する機械学習という分野の主要な会議での科学的フィードバックを深く探求する第2のデータセットとが相補的である。特に、第2のデータセットには、受理された論文だけでなく、拒否された論文に対する専門家のフィードバックも含まれている。

Nature系列のジャーナルにおけるフィードバックの結果、GPT-4が提供したコメントの57.55%は、全体の査読者の中で少なくとも1人の人間の査読者が記載していた。これは、GPT-4が人間の査読者と類似したフィードバックを提供していることを示している。

さらに、GPT-4のコメントと特定の1人の査読者のコメントの重複を調べたところ、約30.85%一致していた。興味深いことに、2人の人間の査読者間でのコメントの重複率も28.58%と、これと近い数値であった。すなわち、GPT-4のフィードバックと人間の査読者のフィードバック間の共通点は、2人の人間の査読者間の共通点とほぼ同等であることを示した。

Copyright © ITmedia, Inc. All Rights Reserved.