速報

Stability AI、テキスト→動画の「Stable Video Diffusion」をGitHubで公開

Stability AIは、テキストから動画を生成するAIモデル「Stable Video Diffusion」のリサーチプレビュー版をGitHubで公開した。テキスト入力のためのWebツールを入手するにはウェイティングリストに登録する必要がある。

英Stability AIは11月21日(現地時間)、テキストから動画を生成するAIモデル「Stable Video Diffusion」のリサーチプレビュー版をリリースしたと発表した。

同社の画像モデル「Stable Diffusion」をベースにしており、コードはGitHubで公開した。ローカルでモデルを実行するためのウェイトはHugging Faceで公開している。

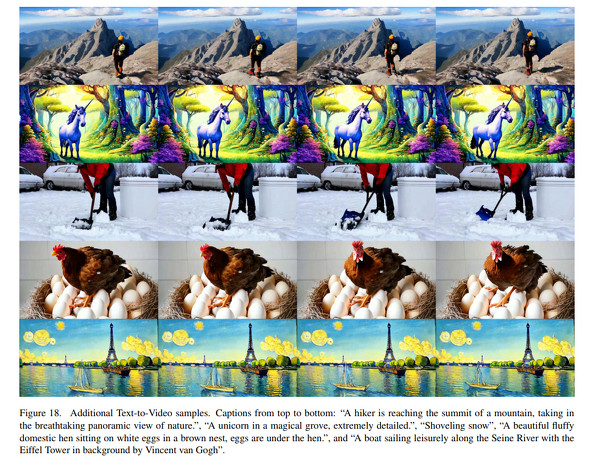

このモデルは、テキストから画像への事前トレーニング、低解像度の動画の大規模なデータセットによる動画の事前トレーニング、高解像度動画の小規模データセットを使った動画の微調整という3フェーズでトレーニングされている。

公開されたリサーチプレビュー版は、2つの画像から動画を生成するモデルのみで、テキストから動画への変換は、現在ウェイティングリストに登録する状態になっているWebツールが必要だ。

リサーチプレビュー版では、3〜30フレーム/秒のフレームレートで14フレームと25フレームの2種類の動画を生成できる。

テキストから動画を生成するモデルは、米Googleや米Metaも発表している。

Copyright © ITmedia, Inc. All Rights Reserved.

関連記事

Meta、独自の動画生成AI「Emu Video」と編集AI「Emu Edit」を紹介

Meta、独自の動画生成AI「Emu Video」と編集AI「Emu Edit」を紹介

Metaは、9月に発表した独自の画像生成基盤モデル「Emu」に基づく2つのモデルを発表した。4秒のリアルな動画を生成できる「Emu Video」とプロンプトで画像を編集する「Emu Edit」だ。 Google、文章から動画を生成するAI「Imagen Video」を紹介 Metaに続き

Google、文章から動画を生成するAI「Imagen Video」を紹介 Metaに続き

Google Researchは、短い文章から短い動画を生成するAIシステム「Imagen Video」を発表した。Metaの「Make-A-Video」と同様にまだ不自然でぼやけてはいるが、テキストレンダリングや3D表示などが可能。悪用軽減対策ができるまではモデルとコードは公開しない。 アドビ、生成AIを刷新 画像を貼って「このテイストで出力して」も可能に テキスト→動画生成も開発中

アドビ、生成AIを刷新 画像を貼って「このテイストで出力して」も可能に テキスト→動画生成も開発中

2023年3月にβ版を提供し、9月から正式提供をスタートした米Adobeの生成AI「Firefly」に早速アップデートが入った。プロンプトから画像を生成するモデルが後継の「Adobe Firefly Image 2 Model」に刷新された。 Stability AI、テキストで作曲できる生成AI「Stable Audio」

Stability AI、テキストで作曲できる生成AI「Stable Audio」

Stabioity AIは、音楽生成AIモデル「Stable Audio」を公開した。Webアプリの無料版では、最長45秒のトラックを生成し、ダウンロードできる。 Stability AI、スケッチを高度な画像に変換する「Stable Doodle」無償公開

Stability AI、スケッチを高度な画像に変換する「Stable Doodle」無償公開

画像生成AI「Stable Diffusion」を手掛けるStability AIは、ラフなスケッチを高度な画像に変換する新ツール「Stable Doodle」を公開した。Webおよびモバイルアプリで利用可能だ。