Meta、コード最適化のためのAIモデル「LLM Compiler」を商用ライセンスで公開

Metaは、コードサイズを大幅に削減したり、プログラムの実行速度を向上させるためのLLMモデル「Meta LLM Compiler」を発表した。商用ライセンスでリリースした。

米Metaは6月27日(現地時間)、コード最適化のためのLLMモデル「Meta Large Language Model Compiler」(以下「LLM Compiler」)を発表した。特別な商用ライセンスの下でリリースしており、Hugging Faceでダウンロードできる。70億パラメータと130億パラメータの2サイズ構成だ。

LLM Compilerは、研究者や開発者がコードの最適化とコンパイラの最適化をさらに研究開発するための、スケーラブルで費用対効果の高い基盤を確立することを目指しているという。このモデルを利用することで、コードサイズを大幅に削減したり、プログラムの実行速度を向上させることができるとしている。

従来のコード最適化手法は、手作業で設計された特徴やグラフニューラルネットワークに依存しており、プログラムの表現が不完全だが、LLM Compilerは「ソースプログラムを完全かつロスレスな表現で受け入れることができる」という。

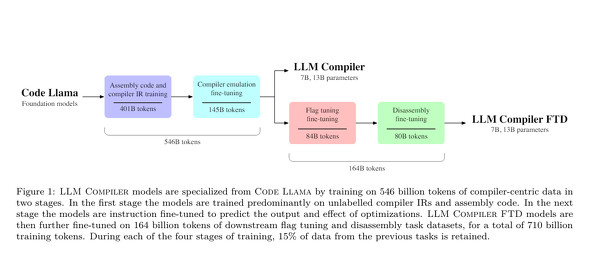

LLM Compilerのトレーニングパイプラインは、Code Llamaの初期化、アセンブリコードとコンパイラIRの事前トレーニング、コンパイラエミュレーションのための命令の微調整、ダウンストリームコンパイラタスクの拡張という4つの段階で構成されている。

LLM Compilerは、最適化フラグチューニングと逆アセンブリという2つのダウンストリームコンパイルタスク向けに適合されている。

トレーニングに使用した自動チューニング手法と比較すると、LLM Compiler FTDは追加のコンパイルを必要とせずに最適化の可能性の77%を実現するという。逆アセンブルする場合、LLM Compiler FTDは14%の確率で正しい逆アセンブリを作成する。どちらのタスクでも、LLM Compiler FTDモデルは同等のLLM Code LlamaおよびGPT-4 Turboを大幅に上回るとしている。

ただし、入力のシーケンスの長さ(コンテキストウィンドウ)の上限は1万6000トークンなので、長いプログラムコードでは利用できないだろう。

Metaはコンテキストウィンドウの拡大に取り組んでいるという。また、モデル出力の精度も課題なので、利用者はLLM Compiler固有の評価ベンチマークを使ってモデルを評価するよう勧めている。

Copyright © ITmedia, Inc. All Rights Reserved.

関連記事

Meta、無料で商用可の新LLM「Llama 3」、ほぼすべてのクラウドでアクセス可能に

Meta、無料で商用可の新LLM「Llama 3」、ほぼすべてのクラウドでアクセス可能に

Metaは、オープンソースのLLM最新版「Llama 3」をパラメータ80億と700億の2モデルで公開した。AWSやAzure、Google Coudなどで利用可能になる。誤った拒否率が大幅に減少したとしている。 Meta、AIアシスタント「Meta AI」をInstagramやMessengerでロールアウト

Meta、AIアシスタント「Meta AI」をInstagramやMessengerでロールアウト

Metaは、昨年のConnectで予告したAIアシスタント「Meta AI」をInstagramなどの同社サービスで展開していくと発表した。同日発表の新LLM「Llama 3」で構築した。まずは英語版のみを数十カ国で提供する。 Meta、責任ある安全な生成AI開発を促す「Purple Llama」を発表

Meta、責任ある安全な生成AI開発を促す「Purple Llama」を発表

LLMのLlamaをオープンソースで公開しているMetaは、「責任ある安全な生成AI」の開発を促すプロジェクト「Purple Llama」を発表した。まずはLLM向けのサイバーセキュリティ評価ベンチマークセットをリリースした。 Meta、コーディング用生成AIモデル「Code Llama」リリース

Meta、コーディング用生成AIモデル「Code Llama」リリース

Metaは、大規模言語モデル「Llama 2」上に構築した生成AIコーディングツール「Code Llama」をリリースした。Llama 2と同じコミュニティライセンスで、無料で研究および商用利用できる。