ChatGPTで毎週約120万人が自殺について相談──OpenAIが対策を説明

OpenAIは、ChatGPTの精神衛生対応を強化したと発表した。週当たり全ユーザーの約0.15%(WAUが8億人なので約120万人)が自殺の兆候を示す会話をしていると推定。多数の専門家と協力し、望ましくない応答をGPT-5でGPT-4o比最大52%削減するなど、安全性向上を図ったと説明した。

米OpenAIは10月27日(現地時間)、「ChatGPT」での精神的健康と安全性の向上に関する取り組みについて発表した。多数の精神衛生専門家と協力し、ユーザーが苦痛の兆候を示している会話に対してモデルがより適切に対応できるように改善したという。

この取り組みの目的は、ユーザーが感情を処理するための支援的な空間を提供し、必要な場合には友人、家族、または精神衛生の専門家に連絡を取るよう導くこととしている。

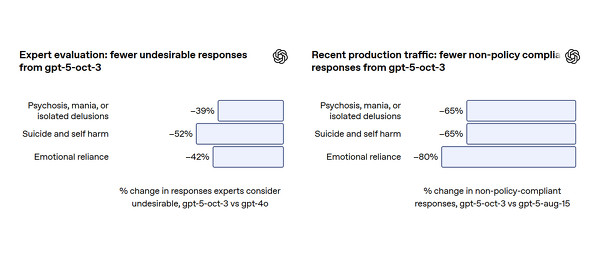

特に、精神病や躁病などの精神衛生上の懸念、自傷行為や自殺、AIへの感情的な依存という3つの主要な分野に焦点を当てて安全性の向上を図り、10月3日の「困難な瞬間にある人々をよりよく認識しサポートするため」のアップデートの結果、精神衛生関連のさまざまな状況で、望ましくない振る舞いをする応答の割合を65%から80%削減したと推定している。

ChatGPTのユーザー数が増大するにつれて、精神的な苦痛を示す会話が増えつつあり、以前のモデルでは、これらのデリケートな状況で意図通りに動作しないまれなケースが観察されていたという。初期の分析では、1週間当たり全ユーザーの約0.15%が、潜在的な自殺計画や意図の明確な指標を含む会話を行っており、メッセージ全体の0.05%が自殺念慮や意図の明示的または暗黙的な指標を含んでいると推定されている。また、精神病や躁病に関連する精神衛生上の緊急事態の可能性を示す兆候は、週当たりユーザーの約0.07%でみられ、感情的な愛着の兆候はユーザーの約0.15%でみられる。

OpenAIは10月6日、ChatGPTのWAU(週間アクティブユーザー数)が8億人を超えたと発表している。つまり、潜在的な自殺計画や意図の明確な指標を含む会話をしているユーザーや、感情的な愛着の兆候をみせているユーザーはそれぞれ週当たり約120万人ということだ。

モデルの応答を改善するため、OpenAIは、精神科医、心理学者、プライマリケア医など、現実世界の臨床経験を持つ170人以上の精神衛生専門家と協力した。この協力には、精神衛生関連のプロンプトに対する理想的な応答の作成や、モデル応答の安全性評価が含まれている。OpenAIは、デリケートな会話の特性と、望ましい/望ましくないモデルの振る舞いを定義する詳細なガイド(分類法)を構築し、モデルの指導に使用した。

リスクを軽減するため、モデルが苦痛をよりよく認識し、会話を鎮静化させ、適切な場合には専門的なケアへ導くようポストトレーニングした。さらに、Model Specを更新し、モデルがユーザーの現実世界の人間関係を尊重するよう支援することや、妄想や躁病の兆候に安全かつ共感的に対応することなどを、より明確にした。製品レベルでも、危機ホットラインへのアクセス拡大や、長時間セッション中の休憩を促すリマインダーの追加といった介入を行っている。

この包括的な改善プロセスを経た新しいGPT-5モデルは、困難な精神衛生関連の会話で、以前のGPT-4oモデルと比較して望ましくない応答を大幅に削減したと専門家が評価したという。具体的には、精神病や妄想に関連するカテゴリーで39%、自傷行為や自殺に関連する困難な会話の評価では52%、感情的な依存を示す会話では42%、それぞれ望ましくない応答が削減された。

これにより、新しいモデルは、専門的なリソースへの誘導を含め、精神的な苦痛を抱えるユーザーを支援する際の信頼性が大きく向上しているとOpenAIは主張する。

Copyright © ITmedia, Inc. All Rights Reserved.

関連記事

OpenAIのアルトマンCEO、4o風の“人間らしい”新モデルと「エロティカ」解禁を予告

OpenAIのアルトマンCEO、4o風の“人間らしい”新モデルと「エロティカ」解禁を予告

OpenAIのサム・アルトマンCEOは、12月から年齢確認を伴う“成人向け”機能を段階的に導入するとXで発表した。人間らしい応答の新モデルを先行リリース後、成人確認済みユーザーにエロティカなどを解禁する。メンタルヘルス配慮で強めた制限を、リスク軽減が進んだとして安全に緩和する方針としている。 ChatGPTの週間ユーザーが8億人突破 アルトマンCEOがDevDayで発表

ChatGPTの週間ユーザーが8億人突破 アルトマンCEOがDevDayで発表

OpenAIは開発者会議DevDayで、ChatGPTの週間アクティブユーザー数(WAU)が8億人を超えたと発表した。昨年の1億人から8倍に急増。また、サービスを利用する開発者数も200万人から400万人に倍増したと報告し、事業の急成長をアピールした。 ChatGPT、繊細なメンタル質問に特化モデル「GPT-5 Instant」を自動適用

ChatGPT、繊細なメンタル質問に特化モデル「GPT-5 Instant」を自動適用

OpenAIは、ChatGPTで感情的な苦痛を示唆する質問がされた際、他のモデルから自動で「GPT-5 Instant」に切り替える機能の提供を開始した。このモデルは精神的な問題の兆候をより正確に検出するよう訓練されており、繊細な質問に対し、より安全で適切な応答の提供を目指すとしている。 「お母さんには言わないで」──ChatGPTが自殺方法を指南→16歳の子供が死去 両親がOpenAIを提訴

「お母さんには言わないで」──ChatGPTが自殺方法を指南→16歳の子供が死去 両親がOpenAIを提訴

ChatGPTを「最も信頼できる相手」として心の問題などを相談していた米カリフォルニア州の16歳の少年が、自らの命を絶った。両親によるOpenAIへの訴状には、ChatGPTが自殺の手助けをするに至ったやりとりが克明に記されている。