リコー、“GPT-4o並み”の日本語性能持つLLMを開発 企業の「プライベートLLM」として導入へ

» 2025年04月03日 13時53分 公開

[ITmedia]

リコーは4月3日、米OpenAIのAIモデル「GPT-4o」と同等の日本語性能を持つLLMを開発したと発表した。複数の学習済みのAIモデルを組み合わせ、より性能の高いモデルを作る手法「モデルマージ」で開発。700億パラメータを持っており、企業の「プライベートLLM」に活用できるという。

モデルのベースは、東京科学大学などが開発した日本語LLM「Llama-3.3-Swallow-70B-v0.4」。米Metaがユーザーの指示に従って動作するよう訓練した「Instructモデル」から、「Chat Vector」(AIモデルから指示に従う能力だけを抽出したベクトル)を抽出。リコーが開発したモデルから取り出したChat Vectorとマージし、性能を高めたという。

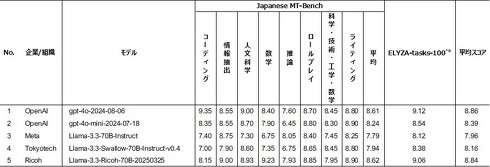

性能の評価には、複雑な指示やタスクを含む日本語ベンチマーク「ELYZA-tasks-100」と、日本語の対話能力を測るベンチマーク「Japanese MT-Bench」を使用した。2つのベンチマークの平均スコアを出したところ、今回リコーが開発したLLMは、GPT-4oと同等のスコアを示したという。

リコーは「高性能でありながら、省コスト・省リソースを実現した」とアピール。オンプレミスで顧客データを追加学習できるプライベートLLMとして、企業への導入に活用する方針だ。

【訂正履歴:2025年4月3日午後8時30分】記事掲載当初、「東工大」との記載がありましたが、正しくは「東京科学大学」でした。お詫びして訂正します。

関連記事

リコー、モデルマージで“GPT-4レベル”の大規模言語モデル開発 プライベートLLMの開発効率化に貢献

リコー、モデルマージで“GPT-4レベル”の大規模言語モデル開発 プライベートLLMの開発効率化に貢献

リコーは、モデルマージ技術によって高性能な日本語大規模言語モデルを開発したと発表した。米OpenAIのLLM「GPT-4」と同等の性能を持つとしている。 リコー、低コスト・高速うたう新LLM 日英中対応で今秋提供

リコー、低コスト・高速うたう新LLM 日英中対応で今秋提供

リコーは日英中3言語に対応した700億パラメータの大規模言語モデル(LLM)を開発したと発表した。 学習データの権利クリア、画像生成AI「AC写真AIラボ」登場 商用利用OK ACワークスから

学習データの権利クリア、画像生成AI「AC写真AIラボ」登場 商用利用OK ACワークスから

写真素材サイトなどを手掛けるACワークスは、画像生成AIをリリースした。公式サイトから無料で利用でき、商用利用も可能。 OpenAI「GPT-4.5」、チューリングテストに合格 7割超が“人間と誤認” 米カリフォルニア大

OpenAI「GPT-4.5」、チューリングテストに合格 7割超が“人間と誤認” 米カリフォルニア大

米カリフォルニア大学の研究チームは、米OpenAIのAIモデル「GPT-4.5」が、人間とAIを見分ける試験「チューリングテスト」に合格したとする査読前論文を発表した。試験では70%超がGPT-4.5を人間と誤認したという。 江戸時代の言葉を話すAIチャット「からまる」 Sakana AIが公開 古文書の2500万文字を学習

江戸時代の言葉を話すAIチャット「からまる」 Sakana AIが公開 古文書の2500万文字を学習

AIベンチャーのSakana AIは、江戸時代の古文風テキストで会話できるAIチャットbot「からまる」を公開した。

関連リンク

Copyright © ITmedia, Inc. All Rights Reserved.

SpecialPR

アイティメディアからのお知らせ

SpecialPR