ITmedia NEWS >

企業・業界動向 >

Meta、4000言語の話し言葉を理解する多言語LLM「MMS」をオープンソース化

» 2023年05月23日 11時30分 公開

[ITmedia]

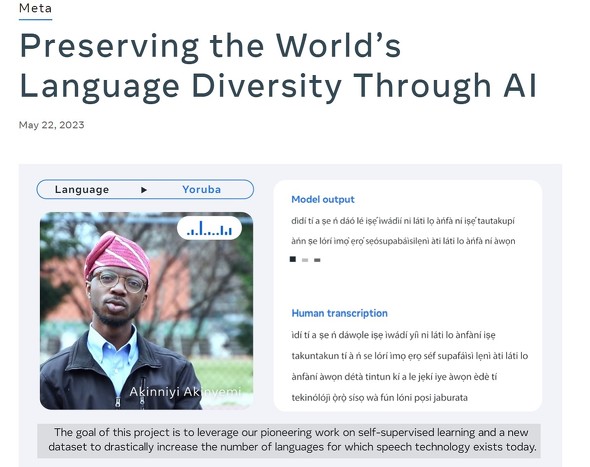

米Metaは5月22日(現地時間)、4000以上の音声言語を識別できる多言語大規模言語モデル「Massively Multilingual Speech」(MMS)のモデルとを研究コミュニティにオープンソースで公開したと発表した。

MMSプロジェクトでは、自己教師あり学習モデルの「wav2vec 2.0」、1100以上のラベル付き言語データ、約4000のラベルなし言語データのデータセットを使ってモデルを構築したという。4000以上の音声言語識別は既存技術の40倍の能力だとしている。

言語の音声データ収集に当たっては、多くの言語に翻訳されている聖書などの宗教文書の音声録音を活用した。1100以上の言語で新約聖書の朗読のデータセットを作成することで、言語ごとに平均32時間のデータを用意した。

プロジェクトの詳細については公式ブログを参照されたい。

「われわれの目標は、人々が好きな言語で情報に簡単にアクセスできるようにすること」で、「VRやAR、メッセージングサービスに至るまで、多様なサービスで人々が自分の母国語を使いつつ周囲の声を理解できるようになる」と語った。

つまり、メタバースでの自由な交流もMMSの目的の1つということだろう。

関連記事

Meta、AI強化に向けた自社開発のAIチップ、スパコン、データセンター、生成AIアシスタントを発表

Meta、AI強化に向けた自社開発のAIチップ、スパコン、データセンター、生成AIアシスタントを発表

MetaはAIに関する取り組みについて発表した。自社開発のAIチップ2種、スパコン「RCS」の進捗、GitHub Copilotのような「Code Compose」、AIデータセンターについてだ。 Meta、独自大規模言語モデル(LLM)の「LLaMA」を限定リリース

Meta、独自大規模言語モデル(LLM)の「LLaMA」を限定リリース

Metaは独自の大規模言語モデル「LLaMA」(Large Language Model Meta AI)を研究者向けにリリースした。「ChatGPT」のLLM「GPT-3.5」よりも小規模でも高性能としている。 Meta(旧Facebook)、ユニバーサル翻訳などメタバース構築に向けたAIプロジェクトを紹介

Meta(旧Facebook)、ユニバーサル翻訳などメタバース構築に向けたAIプロジェクトを紹介

Meta(旧Facebook)は、メタバース構築のために取り組んでいる複数のAIプロジェクトについて説明した。エンドツーエンドのニューラルモデル「Project CAIRaoke」やリアルタイム音声翻訳システムなどだ。 Meta、200言語対応のAI翻訳プロジェクト「NLLB-200」をオープンソース化

Meta、200言語対応のAI翻訳プロジェクト「NLLB-200」をオープンソース化

Metaは、200言語を中間言語なしに翻訳するAIモデル「NLLB-200」をオープンソース化する。FacebookやInstagramでも採用する他、「より多くの人々がメタバースにアクセスできるようになる」としている。

関連リンク

Copyright © ITmedia, Inc. All Rights Reserved.

Special

PRアイティメディアからのお知らせ

SpecialPR

あなたにおすすめの記事PR