| News | 2002年5月31日 03:55 PM 更新 |

っぽいかもしれない

「タマゴかヒナか」〜NHK放送技術研究所レポート(1/2)

世田谷区・砧のNHK放送技術研究所が一般公開された。「タマゴかヒナか」というキャッチフレーズで、映像関連の基礎技術が展示されている。わたしみたいな技術ミーハーはこういう基礎技術ものが大好きだ

5月17日から19日まで、東京世田谷区砧のNHK放送技術研究所の一般公開があった。毎年この時期に行われているものなのだけど、今年は研究所の建物自体が新築されたということもあり(旧研究所の隣にビルをたてて移転というスタイル。そのために去年は砧の公開はなかった)、展示にも力が入っている。

もっとも、そんなことがなくても、わたしみたいな技術ミーハーはこういう基礎技術ものが大好きだ。ことしは「タマゴかヒナか」ってキャッチフレーズを掲げていたけど、なんかこの「海の物とも山の物ともつかない」感覚をついてくるところはうまい*1。

展示の一つの柱は「ISDB(Integrated Services Digital Broadcasting)の高度化」。地上波デジタル時代を踏まえた電送技術やコンテンツの研究だ。ただ、ここは実用化が近そうなものが多くて、わたしにはかえって面白くない。悪いけどすっとばして趣味に走らせてもらう。

オブジェクト連動データ放送サービス

リモコンなし、キャリブレーションなしの、指差しポインタシステム。テレビ画面に向かっている視聴者が、画面の任意の場所を指差すと、その位置にポインタが移動するというもの。指の方には何にもしかけはない。ほんとに指差すだけ*2。

しかけは、ディスプレイのそばにある立体カメラだ。これがユーザーを常に撮影していて、「目」と「指先」の3次元位置を測定している。そして、その2つを結ぶ線の想像延長線がディスプレイと交わったところにポインタを置くのだ。ようするに、ユーザーから見れば常に指先の向こう側にポインタが見えることになるわけ。

これはうまいことを考えた。2点を計測するということで、キャリブレーションの必要がなくなる。デモでは、ありもののカメラを使ったから、外づけ9眼の大きなものだったけど、原理的には2眼でOK。ディスプレイに内蔵させてしまうつもりなのだそうだ(これで、カメラとディスプレイのキャリブレーションの必要もなくなる)。

「指先」は「いちばんでっばっているところ」を検出しているので、おのぞみなら足の指でポイントしたってかまわない(目の高さに足をあげられるならね)。

デモでは、「決定」には音声認識を使っていた。これはなんか画竜点睛を欠くような気がした。せっかくだったら、指先で空中にチェックマークを書くみたいなジェスチャーでやってみたいじゃない。

聞いてみた。当然、それも考えているそうだ。ただ、ここでは人間の持っているインターフェースのうち、使えるものはどれでも使おうっていう考え方もあって、そのために音声認識という方式を選んだらしい(なお、ヘッドセットをつけているのはデモ会場がうるさいため。普通の部屋だったら据え置きのマイクで問題ない)。なんでも使えるようにしておけば、インターフェースのどれかが使えない状態であっても、他のものが使えるということにもなる。

NHKだから、テレビ画面のサッカーの選手を指差すとその人の情報を得られる*3っていう形のデモだったんだけど、このインターフェースそのものはもっと広くテレビ画面を飛びだしても使えそうだ。

新世代バーチャルスタジオ

今回の展示のひとつの目玉。

バーチャルスタジオとは、スタジオで撮影しているお姉さんの画像にリアルタイムでCGや実写の背景を重ねるものだ。

このような場面で撮った画面が……

こんなふうになる

つなぎめもわからない(真ん中の柱より左はリアル、右はバーチャル)

それだけだったらいままででもクロマキーなどで実現しているのだけど、こんどのは原理的に大きな違いがある。

お姉さんを撮影するときに、画像データと一緒に奥行きデータも「撮影」しているのだ。奥行きデータというのはRGBと同じような第4のチャンネル(つまりアルファチャンネルだ)として扱われ、近くにいるものは白く、遠くにいるものは黒く表示されている。

奥行情報を一緒に「撮影」するAxi-Visionカメラ

これによってお姉さんを、その場所にある「オブジェクト」として切りだすことができる。そうなればあとは簡単だ。お姉さんオブジェクトも要素の一つとしたバーチャルスタジオ空間を、コンピュータの中で再構築すればいい。

お姉さんの周りをCGのちょうちょがくるくる回るなんてときも、ちょうが向こう側に回ったら見えなくなるなんてことがあたりまえにできる(これはクロマキーではむずかしい)。デモでは、お姉さんがだんだんうしろに下がって、バーチャルふすまのある位置よりも向こう側にいってしまうと、スーっとかき消すように見えなくなってしまうなんていうのをやっていた*4。

奥行データの取得には赤外線を使う。短い周期で強弱をくりかえす(パルスではなく三角波)赤外線ライトを被写体にあて、その反射光を赤外線カメラ(実際には撮影カメラと一体化されている)で得る。そして、明るさが増加していくタイミングと、減少していくタイミングで撮影した2つの画像を比較すれば、対象物の明るさ(赤外線反射率)によらない距離データが得られるというわけ。

Axi-Visionを正面からみたところ。周りに4つあるのが、赤外線LEDによるライト。これで1Wに相当する。

映像検索のための顔画像認識技術

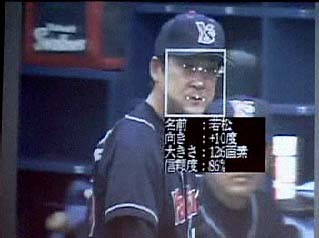

ニュースやスポーツの放送で映っている人が誰なのかを、リアルタイムで認識させようという研究。正面画像を使った顔認識は、セキュリティの分野などで実用化されてきているけど、こちらは正面をむいているとは限らない、どうかするとしゃべったり笑ったりしている画像での認識である。

このために、ひとりの人の顔についていろんな方向から撮った写真のデータベースを用意することにした。この元データは過去のニュース等の映像を使えばいい。このデータベース作成はいまのところ人間の手による。

いま、処理は完全にソフトウェアで行なわれているのだけど、それだと認識に実時間の100倍くらいの時間がかかってしまう(つまり1フレームの認識に100フレームの時間かかるということ)に。ハードウェアをおこしたりアルゴリズムを改良することで、これをリアルタイムにするのがこれからの目標。

リアルタイムにできるようになればこんなふうになるというモデル。

s*1ちょっと、むかしの旭化成のコマーシャルは想像したけどね。

*2もちろん日立製作所デザイン本部のポインタシステムのことを思い出した(記事1、記事2、記事3)。

*3つまり前提として、テレビにうつっている選手がオブジェクトとしてとらえられているということがあるのだ。デジタル放送技術のメリットの一つである。

*4奥行きデータの取得に誤差があるために、消えるときに一瞬粒子状のノイズがみえる。技術的にはまずいのだろうけど、ここではそれがディソルブみたいでおもしろかった。

[こばやしゆたか, ITmedia]

Copyright © ITmedia, Inc. All Rights Reserved.

前のページ | 1/2 | 次のページ