NVIDIAが語るAIチップ業界の“真実” 適切な投資判断に求められる考え方:必要なのはGPGPU? AIアクセラレーター?

生成AIブーム真っただ中の今、AIでビジネス課題を解決したいと考えている企業も多いだろう。サステナビリティーの考慮も求められる現代において、AIをビジネスに生かすために必要なチップ選びについて、NVIDIAに聞いた。

生成AIの急速な進化によって空前のAIブームが発生し、ビッグテックやAI関連企業は熾烈(しれつ)な開発競争を繰り広げている。ユーザー企業の間でもやや過熱気味といえるほどに関心が高まっている状況だ。現在AIの演算にはGPUが使われる場面が多いが、演算性能が高まった代償として消費電力も増加しており、サステナビリティーや環境保護の観点から懸念を示す声も聞かれるようになった。

しかし、単純に消費電力の少ないハードウェアを使ったり数を減らしたりすればいいという話でもない。必要な性能が得られなければ、演算が完了するまでの処理時間が伸びてしまい、むしろ消費電力量は増加してしまう結果にもなる。開発や事業展開のスピードにも直結し、適切な投資判断をしなければ業績にも響く。

状況が複雑化している今、AI利用に取り組む企業や組織はどのような方針で臨むべきなのか。NVIDIAの専門家の見解を踏まえて、AIの利用やチップの選定について考えてみよう。

生成AIブームで爆発するデータと電力

AIの研究開発はコンピュータの実用化の初期段階から連綿と続いており、決して昨今突然出現したものではない。第3次AIブームは2000年代に入った頃から盛り上がってきたもので、当初は機械学習や深層学習が実用的な成果を示し始めたことで採用例が拡大していった。

CPUやGPGPU(詳細は後述)の高性能化で演算能力が高まったことやインターネットの発展で大量のデジタルデータにアクセスできるようになったことなどが背景にあるが、2022年末にOpenAIが「ChatGPT」をリリースしたことで生成AIブームに火が付き、一気に盛り上がりを見せた。ChatGPTはAIに詳しくない一般ユーザーにも驚きを与えるだけの画期的な進化を遂げた。

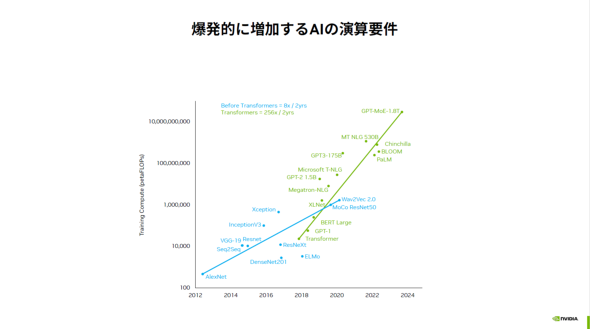

生成AIの進化を支える考え方が「スケーリング則」だ。大まかにはモデルサイズやパラメーター数、データ量、計算リソースなどを大規模化して性能を向上させられる法則だ。OpenAIは大規模化で実用的な生成AIを実現したといわれており、競合他社もスケーリング則に駆動される形で規模拡大に取り組んでいる。

モデルの学習に使われるデータ量や計算量の増加係数はChatGPTのベースになった技術「Transformer」が登場してから爆発的に伸びており、単純計算すれば必要な電力も急激に増えている。必要量に対して電力供給が追い付かなくなる懸念が現実となり始め、省電力化は喫緊の課題になっている。

学界や学術研究機関でもサステナビリティーへの配慮から電力消費の低減を求められるようになり、一部では研究開発が阻害される懸念もあるが、環境への配慮と技術革新において重要なのはバランスであり、イノベーションの芽を摘んでしまうと弊害の方が大きくなる可能性がある。企業にとっても進化の速いAIを適切に活用できないと競争力を失いかねない。そこで、電力効率を高めつつも必要な演算能力を確保できる適切なチップの選択が重要になる。

チップ選びの前に 課題起点で考えること

DXを推進する過程でAI活用を進める企業は増えている。技術部門は、どのようなチップを選べばいいのかと投資判断に悩むこともあるだろう。

ビジネスにAIを適用する際の考え方について、エヌビディアの愛甲浩史氏(エンタプライズマーケティング部 シニアマーケティングマネージャ)は次のように指摘する。

「単にAIを使えばいいというわけではありません。ビジネス課題の解決や性能向上、機能向上など、目的があってそれを実現する手段としてAIを使うわけです」

急激なAIブームの中でAIそのものに目が向きがちだが、多くの企業や組織にとっては課題解決が重要であり、期待される効果を考えながら投資規模を検討する必要がある。「AIで何かできないか」というAI起点の考え方だけではなく、「今ある課題をAIで解決できないか」という問題起点の考え方に切り替えなければ要件は見えてこない。

NVIDIAのGPUはAIアクセラレーターでありAIアクセラレーターではない

多くの企業や組織は課題を解決するアプリケーションにビッグテックの最新の基盤モデルを組み込むことが目的になるだろう。その際に必要な計算量は、最先端の基盤モデルの開発のような規模にはならない。

AIを組み込んだアプリケーションの開発や運用にはGPUが使われることが多い。もともとはグラフィックス処理用に開発されたアクセラレーターだが、高度な並列演算性能をグラフィックス処理以外の汎用(はんよう)的な演算処理に生かすというコンセプトの「GPGPU」(General-Purpose GPU)として進化した。

AI演算を高速処理するための選択肢としてはAIアクセラレーターもある。得意な処理はメーカーやモデルによっても異なるが、特に推論などはGPGPUよりも少ない電力で高速に実行できることもある。

GPGPUとAIアクセラレーターの違いについて愛甲氏は「GPGPUはスーパーコンピュータにも活用されており、スーパーコンピュータが求める高精度の演算を含めたさまざまな演算処理を高速に実行できます。しかしAIの計算に限るなら、あまり正確性は求められず、適度に精度を落として計算することで迅速に結果を得ることもできます」と説明する。

NVIDIAのGPUもAI開発や運用によく使われることからAIアクセラレーターだと認識されることが多いが、愛甲氏によればあくまで基本はGPGPUなのだという。

「汎用的な演算の高速化が主眼にあり、もともとのGPUとしての機能もきちんとあります。その上で昨今需要が高いAIの機能も取り込んでいるという形です。GPUがAIに使われるようになったのは、GPUが持つ演算性能がAIの計算に適しており、CPUなどの他の手段よりも高速に処理できることが分かってきたからです」

AI計算に特化した専用アクセラレーターであれば、求める機能や精度に合わせて処理することでGPGPUよりもさらに高効率を達成できることもある。しかし逆にAIアクセラレーターをAI計算以外の用途で利用するのは難しい。

ビジネス利用を考えるならば、解決したい課題を具体的に想定して、既存のAIモデルの応用にしか使わないシステムなのか、学習なども含めた開発や作り込みが必要なのか、開発の容易さなどを加味してGPUやAIアクセラレーターを選択することになるし、用途に合わせて2つを組み合わせた方がよい場面もある。特にエッジデバイスでの応用などでは、実装面積や熱、電力などの制限も加味しなければならない。

懐の深さで選ぶ ワンアーキテクチャ

NVIDIAのこだわりは「ワンアーキテクチャ」として現れている。違うハードウェアでも異なる分野の技術でも同じアーキテクチャで動かせるため、そのチップで動作させるための特別な作業が発生しない“懐の深さ”がある。

ユーザーが解決したい課題には、高度なグラフィックス処理やビジュアライゼーションを必要とする場合も多い。GPGPUは、現実世界の高度なシミュレーションとなる「デジタルツイン」やリアルな人間に見える高精細なデジタルアバターなどのビジュアライズの処理にも使える。テキスト情報に加えて画像や音声、映像なども扱えるマルチモーダルAIも登場しているが、こうした領域に対応するのにもワンアーキテクチャが有効に働く。AIの開発から応用までシームレスに対応できる上、規模によっては既存のGPU上でAIの実行まで行えるからだ。

AIそのものの進化を目指すアカデミックな領域での研究開発においては、どのような計算処理をしたいのかが分からない場合やとにかくさまざまなリクエストに対応できなければ困るという場面も多い。HPC分野での利用実績が豊富で広範な処理に対応できるGPGPUは有利になり、ここでも柔軟に対応できる懐の深さが強みになる。

AIの開発ペースはすさまじく速く、刻々と状況が変わっている。多くの開発企業やユーザー企業が関心を寄せる「AIエージェント」は生成AIやLLMを核とした応用技術と位置付けられるが、生成AIの急速な進化を受けて実用性が一気に高まっている。

AIエージェントの開発に取り組む企業も増えているが、必要な演算リソースの規模は生成AIの最先端モデル開発に求められる規模とは異なる。何が最適解なのか、状況の変化に注視するとともに専門家のアドバイスを得ることも重要だろう。

確実に下がっている消費電力

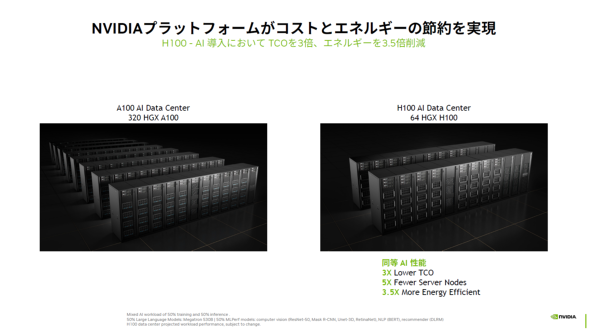

NVIDIAは技術革新と電力消費量削減を両立させる方法を考えている。GPGPU自体の進化も著しく、需要の高いAI演算性能を大幅に向上させるのと同時に電力効率も改善している。2020年に発表された「NVIDIA A100」と2022年に発表された「NVIDIA H100」を比較すると、新世代のH100は、特にAI演算においてコストが3分の1、サーバノード数が5分の1になり、電力効率は3.5倍に向上した。実際、NVIDIA H100を採用したスーパーコンピュータは、電力効率ランキング「Green500」の上位を占めている。

1台当たりの消費電力は性能に合わせて大きくなっているが、H100は同じAI演算処理を実行するのに必要な台数が減って電力効率も上がっているため、総合的な消費量は下がる。製品選定の際には見た目の数字にとらわれず、最終的にどれだけのリソースを必要とするのかも考えなければならない。

重要なのはAI演算の技術革新はこれからも続き、アーキテクチャやソフトウェアの工夫によって演算処理量を大幅に削減できる余地があるという点だ。現時点で見積もった必要演算量が未来永劫(えいごう)そのままとは限らず、削減されてさらに効率良く処理できるようになる可能性もある。ハードウェアとソフトウェアの両輪で技術革新が続く中、専門家の分析なども含めて広く情報を収集し、適切な投資判断を行うことが重要だ。

関連リンク

Copyright © ITmedia, Inc. All Rights Reserved.

提供:エヌビディア合同会社

アイティメディア営業企画/制作:ITmedia エンタープライズ編集部/掲載内容有効期限:2025年3月31日

エヌビディアの愛甲浩史氏

エヌビディアの愛甲浩史氏