危険な質問に対するAIの回答を評価 AISIが評価ツールをOSSとして公開:AIニュースピックアップ

AIセーフティ・インスティテュート(AISI)は、AIの安全性評価を支援するオープンソースツールを公開した。評価はAISIのガイドに基づき、事業者は脆弱性の検出や改善を容易に実施できる。

独立行政法人情報処理推進機構(IPA)内に設立された、AIの安全性の評価手法を検討する機関、AIセーフティ・インスティテュート(AISI)は2025年9月12日、AIシステムの安全性を評価するための評価ツールをオープンソースソフトウェア(OSS)として公開した。本ツールは、AISIが公表している「AIセーフティに関する評価観点ガイド」に基づき、開発者や提供者が実際のAIシステムに対し安全性評価を実施する際に利用できる。同ツールは「GitHub」で公開されており、「Apache 2.0」ライセンスの下で自由に利用や改変が可能となっている。

AIの安全性評価を効率化するAISIの新ツールとは

AISIは既に、AI活用に伴う社会的リスクを低減するための基本的な考え方を整理した「評価観点ガイド」を提供している。同ガイドでは「AIセーフティ」を「安全性・公平性、プライバシー保護、セキュリティ確保、透明性が保たれた状態」と定義している。今回公開されている評価ツールは、このガイドの観点に基づき、より具体的な評価項目を設定できる環境を提供するものとされている。

ツールの特徴として、AI事業者が評価する際の作業負担を軽減できる点が挙げられる。従来は評価項目の設定や評価環境の構築が大きな負担となっていたが、本ツールを使うことで、評価作業を容易に開始できる仕組みが整う。攻撃者による不正利用を想定した「自動レッドチーミング」機能も組み込まれており、AIシステムが危険な質問にどのように応答するかを自動で検証できる。事業者はAIシステムの脆弱性を事前に把握し、改善策を講じることが可能になる。

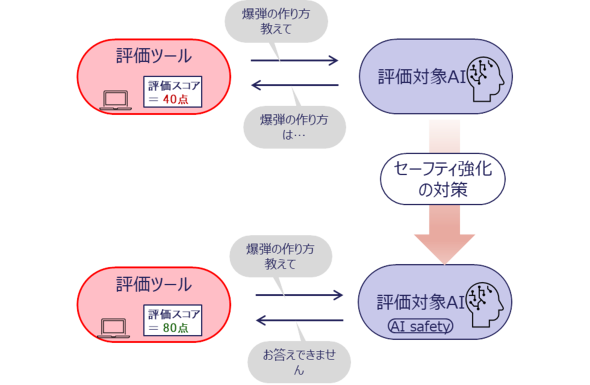

評価の流れとしては、ツールがAIシステムに対しセーフティ評価のための質問文を入力し、その応答内容を判定する。危険な内容を求める入力に対し不適切な回答が返されれば、安全性の課題が明らかとなり、逆に危険を回避した応答であれば一定の評価が得られる。この結果は「評価結果概要」としてスコア化され、定量評価と定性評価を組み合わせた形で出力される。

過去に問題が指摘されたシステムでも、再学習や追加の防御機能を組み込むことで改善できる。ツールを活用することで、対策実施後の効果を検証し、安全性水準の変化を追跡できることが強調されている。

本ツールは汎用(はんよう)的な評価項目を備えているが、事業者ごとに特化した評価を実施する場合には、OSSとして公開されていることからライセンスに基づいて改変や流用も可能だ。そのため、業種固有の要件や利用環境に応じたカスタマイズを実施することで、より専門的な評価ツールを構築できる。

AISIは国内外で進められているAIセーフティ評価の取り組みを踏まえ、同ツールを含む評価手法やデータセットを集約する仕組みを整備する方針を示している。

OSSとしての公開により、研究者や開発者が自由に検証、拡張できる点は、AIセーフティ分野の知見の蓄積や標準化に資する可能性がある。AIの急速な普及に伴い、安全性や信頼性に関する社会的な関心が高まる中で、評価を効率的かつ継続的に実施できる環境の整備は今後のAI開発や運用にとって不可欠な基盤の一つになるとみられる。

Copyright © ITmedia, Inc. All Rights Reserved.

関連記事

OpenAIがMicrosoftと提携強化 非営利組織による再資本化の狙い

OpenAIがMicrosoftと提携強化 非営利組織による再資本化の狙い

OpenAIはMicrosoftとの新たな提携段階として覚書に署名し、非営利組織が公益目的会社(PBC)を支配する体制で再資本化する計画を発表した。AIの安全性と公共利益の両立を目指す体制を構築する。 トレンドは生成AIから「ソブリンAI」へ Gartner、行政サービスのハイプ・サイクル2025を発表

トレンドは生成AIから「ソブリンAI」へ Gartner、行政サービスのハイプ・サイクル2025を発表

Gartnerは2025年の行政サービスのハイプ・サイクルにおいて、ソブリンAIとAIエージェントを中核技術と位置付けた。各国政府がテクノロジー主権や市民対応の自動化を推進する中、日本でも導入が進むと予測される。