なぜ今「オンプレLLM」なのか? リコーとHPEに聞く、データ主権時代のAI戦略:独自データの活用で差をつける

ビジネスで生成AIを利用する動きが急速に広がる中で、オンプレミスLLM(大規模言語モデル)のニーズが高まっている。なぜ今「オンプレLLM」なのか。導入時の注意点は何か。専門家に話を聞いた。

総務省の「令和7年版 情報通信白書」によると、生成AIを積極的、または領域を限定して活用する方針を定めている企業の割合は49.7%となり、前年度の調査(42.7%)から増加した。このように企業における生成AIの利用が広がる中で、クラウドの生成AIを利用するリスクへの懸念から、オンプレミス環境で利用したいというニーズも高まっている。

なぜ今「オンプレLLM」なのか

普段利用しているクラウドサービスで生成AIを利用する企業もあるが、特に機密情報や個人情報を取り扱う業務においてはデータの経路とデータソースが不透明なことが懸念点だ。こうした背景からオンプレミスで生成AIを利用したいというニーズが高まっている、とリコーでAI関連製品の企画を担当する佐々木亮氏は語る。

「オンプレミスであれば全ての情報を社内ネットワークで処理するので、社外へのデータ流出を心配し過ぎずに生成AIを使えます。当社の独自LLMをお客さまに提供するに当たって、より安心して利用できる環境を求める企業が増えていると感じます」

AI向けのインフラを提供する日本ヒューレット・パッカード(以下、HPE)でAIアンバサダーを務める古賀政純氏も、オンプレミスが注目される理由を以下のように説明する。

「クラウドにデータを送信することが企業のポリシーやコンプライアンス規定に違反するケースがあります。経済安全保障上の観点から国を越えたデータの送受信を制限し、保管場所を国内サーバに限定したいというニーズもあります。私たちはインフラの提供者として、そのようなニーズに応えるための製品の拡充に力を入れています」

企業が“自社LLM”導入で直面する壁

しかし、オンプレミスに生成AIを導入して運用するのは課題も多い。その一つとして、AIの急速な進化に対応し、最適な組み合わせを選定するのが難しいという点が挙げられると、リコーでAI関連製品の開発を担う小野康宏氏は言う。

「一番の問題は、生成AIが新しい技術でありトレンドに追随するだけでも大変だという点です。高性能なオープンモデルが日々リリースされ、エージェントやMCP(Model Context Protocol)などの新しいキーワードが登場しています。自社の要件に合ったものを選ぶには、互換性や安定性を確保するための検証作業に専門知識と多くの工数が必要になります」

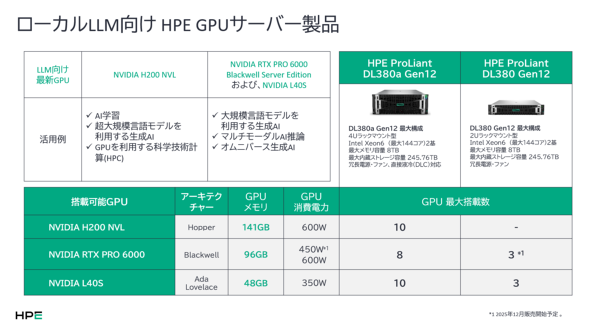

HPEでAI向けインフラの販売を担当する北本貴宏氏も「AIインフラの導入経験がないお客さまも多く、適切なハードウェアを選定したり運用したりするのが難しい企業も多いのが現実です」と話す。LLMを利用するにはGPUなどの計算資源の確保と管理が不可欠で、ネットワークや電源、冷却装置なども用意しなければならない。機微なデータを保存・処理するためのセキュアなハードウェアを選ぶ必要もある。

「RICOH オンプレLLMスターターキット」が開く可能性

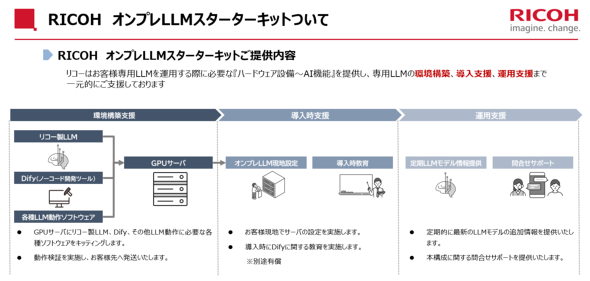

これらの課題を抱える企業向けにリコーが販売するのが「RICOH オンプレLLMスターターキット」(以下、スターターキット)だ。GPUサーバを含めたインフラ一式にリコー製LLMや生成AIアプリケーション開発用のソフトウェアをプリインストールして提供する。リコーが適切なハードウェアとソフトウェアの組み合わせを検証・選定することで導入のハードルを大きく下げているのが特徴だ。

佐々木氏は同キットを企画するに当たって特に重視したポイントとして、「AIの民主化」と「手厚い運用支援」の2点を挙げた。

AIの民主化とは、AIを特定部門の専門家だけが利用するのではなく、全ての従業員がAIを利用できる状態を指す。スターターキットにはノーコードで生成AIアプリケーションを開発できるプラットフォーム「Dify」がインストールされており、プログラミング経験がない従業員でも業務に合ったアプリケーションを簡単に作成できる。

ユーザーの習熟度に合わせた教育支援や、システム管理者およびアプリケーション作成者を対象としたQ&Aサポートなどの運用支援メニューも用意して顧客の生成AI活用を促進させる。

リコーが独自に開発したLLMを利用できる点もスターターキットの強みだ。LLMを業務で利用する際は、モデルの性能だけでなく業務との相性も重要になる。リコーのLLMは、日本企業が業務で使いやすいようにオープンモデルを調整している。日本語の対話能力を評価するベンチマークテストにおいて、本稿執筆時点におけるOpenAIの最新モデル「GPT-5」と同等の性能が出ているという。もちろん、サードパーティー製のモデルを使うことも可能だ。小野氏は「今後も独自モデルの改良やサードパーティー製モデルの動作検証を進めて、オンプレミスでも最新の生成AIを活用できるようにお客さまを支援します」と強調した。

スターターキットのインフラを支えるのが、リコーと協業するHPEだ。HPEは、豊富な製品群と実績によってインフラの信頼性とセキュリティをハードウェアレベルで確保する役割を担う。一例を挙げると、「HPE ProLiantサーバー」は専用セキュリティプロセッサなどを搭載することで、米国政府の調達基準で使用される暗号モジュールのセキュリティ評価レベル「FIPS 140-3 レベル3」に準拠するように設計されている。

リコーが顧客のニーズに合わせたAIインフラを提供できるのも、HPEによるバックアップがあればこそだ。HPEは、PoC(概念実証)やベンチマークテストに利用する機材をそろえた検証用の設備を持っている。この検証環境を積極的に活用することで、リコーは顧客の業務に合わせたインフラやアプリケーションの構成を事前に確認でき、製品の迅速な提供と改修を実現している。

“ハイブリッドAI”時代のニーズに応える

近年の急速なAIの進化は、企業の戦略策定に新しい視点を要求している。古賀氏は、今後の業界の方向性について次のように語る。

「これからはエージェント型AIが主流になり、業務の自動化はますます進みます。製造業をはじめとして物理世界でのAI活用も拡大し、エッジコンピューティングの重要性も増すでしょう。経済安全保障上の観点から、データを外部に出さない『ソブリンAI』もさらに注目されることが予想されます。これらの要因によって、AI活用はオンプレミス化やハイブリッドクラウド化が加速すると考えられます」

リコーのスターターキットは、この“ハイブリッドAI”時代のニーズに応えるソリューションだ。佐々木氏は、このソリューションが企業の今後のAI戦略にもたらす価値について次のように述べる。

「このスターターキットであれば、セキュリティやコンプライアンスなどの要件が厳しい業務にも、手軽かつ安全に生成AIを導入できます。さまざまなユースケースに対して適材適所で生成AIを導入したい企業のニーズに応えるために、当社はオンプレミスやハイブリッドクラウドでの生成AI活用の選択肢を提供します」

リコーとHPEは、先端のLLM技術と信頼性の高いインフラを両立させながら今後も進化し続ける生成AIのトレンドに確実に追随する方針だ。

Amazonギフトカードが当たる!アンケート実施中

本記事に関連して「生成AI基盤」についてのアンケートを実施しています。回答された方の中から抽選で10名様に、Amazonギフトカード(Eメールタイプ)3000円分をプレゼントいたします。当選者には、アイティメディアIDにご登録のメールアドレス宛にギフトをお送りします。当選者発表はギフトの送付をもってご連絡とさせていただきます。ぜひ下記アンケートフォームよりご回答ください。

ログイン または 会員登録(無料)いただくとアンケートフォームが表示されます。オレンジ色の「アンケートに回答する」ボタンからアンケート回答をお願いいたします。

Copyright © ITmedia, Inc. All Rights Reserved.

関連リンク

提供:リコージャパン株式会社、日本ヒューレット・パッカード合同会社

アイティメディア営業企画/制作:ITmedia エンタープライズ編集部/掲載内容有効期限:2025年12月10日