コメディー作品の“笑いどころ”を機械学習で予測 「ビッグバン・セオリー」でユーモア学ぶ:Innovative Tech

シットコムが簡単に作れてしまうかもしれないし、ぜんぜん笑ってくれないかもしれない。

Innovative Tech:

このコーナーでは、テクノロジーの最新研究を紹介するWebメディア「Seamless」を主宰する山下裕毅氏が執筆。新規性の高い科学論文を山下氏がピックアップし、解説する。

インドのIndian Institute of Technology Kanpur(IIT Kanpur)と英バース大学の研究チームが開発した「Multimodal Humor Dataset: Predicting Laughter tracks for Sitcoms」は、米国のコメディー動画から笑いの場面を予測するユーモア検出器だ。対話の内容を基に観客が笑っている場面かどうかを判断できる機械学習を設計する。

今回の研究は、「フルハウス」や「フレンズ」など米国に多いコメディージャンル「シットコム」(シチュエーションコメディー)が対象。中でも、「ビッグバン・セオリー」という大ヒット作品から、新たに大規模データセット「Multimodal Humor Dataset」(MHD)を構築した。

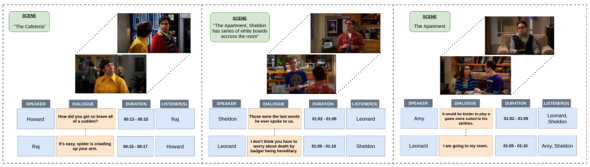

データセットは、話者や聞き手の名前を含む全対話シーンのせりふ情報と、それに関連するビデオクリップの視覚情報で構成。対話シーンの開始時刻と終了時刻も含まれる。せりふによる笑いだけでなく、会話の間やリアクションなどの視覚的要素も考慮する。

データセットは、全ての対話シーンに対して、ユーモア/非ユーモアを手動でラベル付けした。ラベル付けの基準は、観客の笑い声が対話シーンに挿入されているか否か。「ビッグバン・セオリー」にはスタジオ撮影の様子を見に来ている観客の自然な笑い声が入っている。

データセットを分析し評価するため、言語と視覚情報の両方を用いたモデル「Multimodal self attention model」(MSAM)を構築し実行した結果、約80%という比較的良好な精度で“笑いどころ”を判定できた。

このモデルが他のシットコムのタイトルにも適応できるのかの検証を実施。「フレンズ」と「ママと恋に落ちるまで」「NYボンビー・ガール」で評価した結果、検出精度の低下(2〜3%)が見られたものの、改善の可能性はあるという。

Copyright © ITmedia, Inc. All Rights Reserved.

関連記事

スクリーンが動いても高速追従 液体レンズを使ったAFプロジェクションマッピング

スクリーンが動いても高速追従 液体レンズを使ったAFプロジェクションマッピング

動的なプロジェクトマッピングで課題となっていたフォーカス問題を解消する。 20機の小型ロボット群をハンドジェスチャーで直感操作 スタンフォード大など開発

20機の小型ロボット群をハンドジェスチャーで直感操作 スタンフォード大など開発

群ロボットの操作を不慣れなユーザーがしやすいようにした。 一般人が撮影したネット上の写真から建物を高品質に3D化するGoogleの機械学習技術

一般人が撮影したネット上の写真から建物を高品質に3D化するGoogleの機械学習技術

観光客が撮影してネットで公開している写真を利用できる。