iOS 16の「被写体切り抜き機能」が意外と楽しい 誰でも“クソコラ職人”に(1/2 ページ)

iPhone向けの新OS「iOS 16」が9月13日、配信開始された。その中でも、注目を集めているのが「画像を調べる」機能だ。

iPhone向けの新OS「iOS 16」が9月13日、配信開始された。刷新されたロック画面の他、ウィジェットなどのカスタマイズ、写真内の日本語テキストの抽出などが可能になった他、集中モードのアプリ内実装など、ユーザーの目に入る情報をコントロールする機能も追加されている。

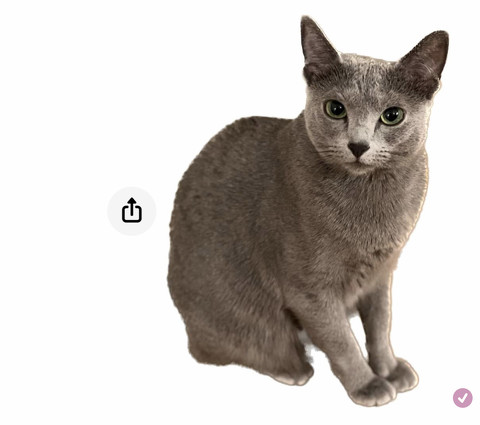

その中でも、注目を集めているのが「画像を調べる」機能だ。これは、写真内の被写体を長めにタップすると、被写体だけを切り抜いてクリップボードに保存するというもの。「A12 Bionic」搭載モデル以上が対象で、切り抜きにはチップ内のNeural Engineを活用。つまり、機械学習の力で実現している。

クリップボードに保存されるため、さまざまなアプリに貼り付けることができる。メモ帳に貼ったり、資料作成時の素材として使ったり、MessengerやLINEでスタンプ代わりに送ったり、Googleレンズでそのまま検索したり、Instagramのストーリーズで雑なコラージュ(通称:クソコラ)を作って投稿することも可能だ。ただし、LINEは画像データの透過部分が黒くなるので、漆黒の中に被写体が浮かび上がって無駄に怖い。白抜きだと良かったのだが。

肝心な切り抜きの精度だが、背景がシンプルなほどきれいに切り抜いてくれる。被写体は人物以外でもOKで、動物やクルマ、ビルなどさまざま。夜に撮影した被写体でも予想以上にきれいに切り抜いてくれる。ただし、周囲に他のオブジェクトが写り込んでいると、精度が悪くなったり、うまく被写体を認識してくれない場合もある。

Copyright © ITmedia, Inc. All Rights Reserved.