画像生成AIが“ロボットの動き”を生成 英ICL「DALL-E-Bot」開発:Innovative Tech

英Imperial College London(ICL)の研究チームは、テキスト入力に応じて自動生成した画像を目標に、ロボットが動いて物体を再配置するシステムを提案した研究報告を発表した。

Innovative Tech:

このコーナーでは、テクノロジーの最新研究を紹介するWebメディア「Seamless」を主宰する山下裕毅氏が執筆。新規性の高い科学論文を山下氏がピックアップし、解説する。

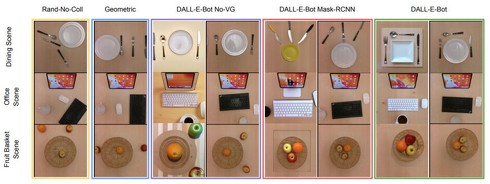

英Imperial College London(ICL)の研究チームが発表した論文「DALL-E-Bot: Introducing Web-Scale Diffusion Models to Robotics」は、テキスト入力に応じて自動生成した画像を目標に、ロボットが動いて物体を再配置するシステムを提案した研究報告だ。

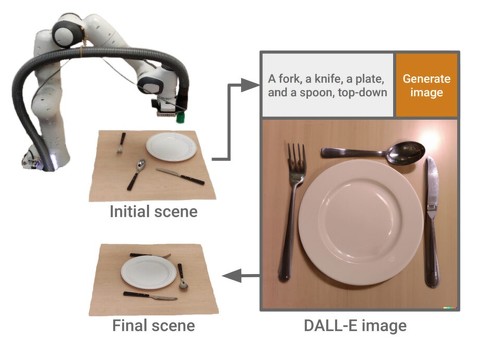

ロボットに搭載するカメラが現状を撮影し、その画像をもとに自然言語によるプロンプトを作成してText-to-imageモデルに入力すると人間のように配置、整列させた新しい画像を生成できる。ロボットはその画像をゴールにアームを動かし物体をつかんで移動させる。例えば、お皿、ナイフ、スプーン、フォークが机上に散らばっている状態を、ロボットに整頓させるタスクで応用する。

昨今、入力テキストから画像を生成するText-to-imageモデルが流行している。これはCLIPのエンコードとノイズ推定を行う拡散モデルのデコードによる画像生成技術で構成しており、高品質で多様な画像を生成できる。

このようなモデルは、現実的な情景の画像を生成することができるため、物体を自然に配置する方法も理解していなければならない。例えば、「キッチン」というテキストで画像を生成すると、ソファや床に散乱した皿よりも、テーブルや棚の上にきちんと置かれた皿が表示される可能性が高くなる。これはロボット工学への応用につながると研究チームは考えた。

ロボット工学において、物体再配置タスクの目標状態を予測することは課題の1つである。その目標予測にText-to-imageモデルを活用したのがこのフレームワークとなる。乱雑に配置された初期画像を使い、物体が整列された再配置の目標状態を予測させるフレームワークだ。

パイプラインでは、まずロボットが撮影した画像をもとにオブジェクトのテキスト記述を推論し、次にDALL-E 2に渡してそれらのオブジェクトの自然で人間らしい配置を表す新しい画像を生成してもらう。最後にその画像に従ってロボットアームでオブジェクトを物理的に配置する。

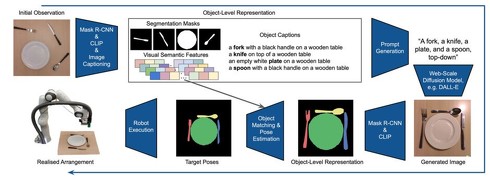

具体的には、最初の観察画像は、セグメンテーションマスク、オブジェクトキャプション、CLIP視覚特徴ベクトルからなるオブジェクトごとの記述に変換される。次に、シーン内のオブジェクトを説明するテキストプロンプトを構築し、DALL-E 2に渡して、オブジェクトを人間のように配置する再配置タスクのゴール画像を作成する。

次に、初期画像と生成画像のオブジェクトをCLIPの視覚的特徴を用いてマッチングさせ、そのセグメンテーションマスクを合わせて姿勢を推定する。最後に、ロボットが推定された姿勢に基づいて、予測された配置を実現するためにシーンの再配置を行う。

なお、DALL-E 2は一般に公開されているものをそのまま使用しており、データの収集や学習は必要としない。これは重要なことで、望ましい配置の例を収集し、そのシーンに特化したモデルを学習する必要がある先行研究を超えて、ゼロショットで自律的に配置換えを行うことができる。Text-to-imageモデルの新たな応用といえるだろう。

Source and Image Credits: Kapelyukh, Ivan, Vitalis Vosylius, and Edward Johns. “DALL-E-Bot: Introducing Web-Scale Diffusion Models to Robotics.” arXiv preprint arXiv:2210.02438(2022).

Copyright © ITmedia, Inc. All Rights Reserved.

関連記事

文章から“VRシーン”を作成するAI 4K解像度でHDRパノラマを出力 シンガポールのチームが発表

文章から“VRシーン”を作成するAI 4K解像度でHDRパノラマを出力 シンガポールのチームが発表

シンガポールのNanyang Technological Universityによる研究者らは、4Kの解像度を持つHDRパノラマを生成するためのゼロショット・テキスト駆動型フレームワークを提案した研究報告を発表した。 画像生成AIで漫画っぽい物語が作れるモデル「StoryDALL-E」

画像生成AIで漫画っぽい物語が作れるモデル「StoryDALL-E」

米UNC Chapel Hillの研究チームは、テキストから画像を生成するText-to-Imageモデルで漫画風の物語(ビジュアルストーリー)を構築できるシステムを開発した。登場人物のせりふは生成されないが、一貫して登場人物や背景の整合性がとれた一連の画像を生成する。 進化したAIによる成果物の権利は誰のもの? Midjourneyだけではない、小説、映画、音楽で既にAI生成物は広まっている

進化したAIによる成果物の権利は誰のもの? Midjourneyだけではない、小説、映画、音楽で既にAI生成物は広まっている

言葉から画像を作り出すMidjourneyが話題だが、AIを創作に生かそうという研究開発はあらゆるジャンルで進んでいる。 AI作成の画像を修正する技術 単語を変えて「自転車に乗る猫」を「車に乗る猫」に 米Googleらが開発

AI作成の画像を修正する技術 単語を変えて「自転車に乗る猫」を「車に乗る猫」に 米Googleらが開発

米Google ResearchとイスラエルのTel Aviv Universityの研究チームは、AIが文章から生成した画像に修正を加えられる技術を開発した。入力に使った文章の一部を修正することで画像全体を大幅に変えず、その部分だけをピンポイントで変えられる。 「Azure OpenAI Service」でAI画家「DALL・E 2」利用が可能に

「Azure OpenAI Service」でAI画家「DALL・E 2」利用が可能に

Microsoftは、「Azure OpenAI Service」で利用できる言語モデルに「DALL・E 2」を追加すると発表した。玩具のMattelがミニカーの「ホットウィール」設計に利用していると紹介。