ChatGPTの言語モデル「GPT-3.5」、司法試験を受ける 結果は?:Innovative Tech

米Chicago-Kent College of Lawに所属する研究者らは、OpenAIの大規模言語モデル「GPT-3.5」で米国司法試験を受けるとどうなるかを検証した研究報告を発表した。

Innovative Tech:

このコーナーでは、テクノロジーの最新研究を紹介するWebメディア「Seamless」を主宰する山下裕毅氏が執筆。新規性の高い科学論文を山下氏がピックアップし、解説する。

米Chicago-Kent College of Lawに所属する研究者らが発表した論文「GPT Takes the Bar Exam」は、OpenAIの大規模言語モデル「GPT-3.5」で米国司法試験を受けるとどうなるかを検証した研究報告である。

法律は言語の使用に大きく依存する分野だ。法令や規制、契約、特許、司法判断などの文書を継続的に作成し、膨大な量のテキストデータを生成している。

他方で、OpenAIのGPT(Generative Pre-trained Transformer)などの登場により大規模言語モデル(LLM)が注目されてきた。最近ではGPT-3.5と呼ばれる「text-davinci-003」モデルが開発されており、GPT-3.5シリーズのモデルを微調整したテキスト対話モデル「ChatGPT」が登場し、一部で話題となった。

法律用語の複雑な性質とGPT-3.5の一般的なタスクパフォーマンスに関する学習を考えると、GPT-3.5のような最先端のLLMが、法律タスクに成功できるかどうかは未知の問題である。

この問題を評価するために研究チームは、NCBE(National Conference of Bar Examination)が実施しているMBE(Multistate Bar Examination、全州共通の選択式司法試験)で、GPT-3.5を実験的に試験し評価した。

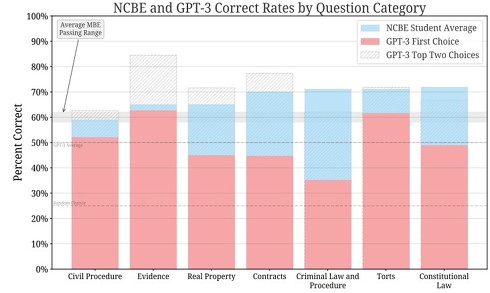

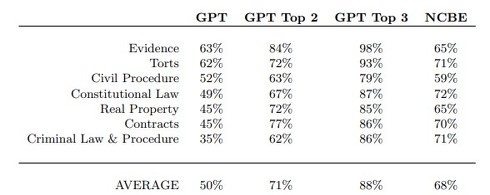

結果、GPT-3.5は最高のプロンプトとパラメータを使用した場合、50.3%の平均正解率を達成し、ベースライン(ランダム予測)の推測率25%を大幅に上回り、証拠法(Evidence)と不法行為法(Torts)の2科目で平均合格率を超えた。

一方で、7科目全部を平均すると、GPT-3.5(平均正解率50%)は人間の受験者(平均正解率68%)に約18%の差で負けた。証拠法(Evidence)、不法行為法(Torts)、民事訴訟法(Civil Procedure)についてはごくわずかな差だが、残りの連邦憲法(Constitutional Law)、不動産法(Real Property)、契約法(Contracts)、刑法(Criminal Law &Procedure)では、その差はさらに大きくなり、刑法では36%にも達した。

次にGPT-3.5の予測回答には、第1候補以外(第2候補、第3候補、第4候補)も出力しているため、第2候補と第3候補の回答率もチェックした。その結果、それぞれ平均71%と88%の正解率となった。

今回はUBE(Uniform Bar Examination、全州共通の米国司法試験)の中の1つの試験であるMBEに絞ったが、今後の研究では残りの論文試験(MEE)と起案試験(MPT)の両セクションにおいて、GPT-3.5と微調整したモデルの両方で評価する予定だという。

Source and Image Credits: Bommarito II, Michael, and Daniel Martin Katz. “GPT Takes the Bar Exam.” arXiv preprint arXiv:2212.14402(2022).

Copyright © ITmedia, Inc. All Rights Reserved.

関連記事

「幸せになるには?」に答えてくれるAI「ChatGPT」 日本語でさまざまな質問に回答 Twitterでも話題

「幸せになるには?」に答えてくれるAI「ChatGPT」 日本語でさまざまな質問に回答 Twitterでも話題

米AI研究企業OpenAIは対話のためのAI言語モデル「ChatGPT」を発表した。テキストで質問を投げかけることで、AIがその回答を表示する。日本語にも対応しており、現在はテスト期間中のため無料で利用できる。 OpenAI、ChatGPTの有料版提供を検討中 「いくらなら使いますか?」

OpenAI、ChatGPTの有料版提供を検討中 「いくらなら使いますか?」

OpenAIは、現在無料で提供しているAIチャット「ChatGPT」の有料化の検討を始めた。「ChatGPT Professional」についてのアンケートに答えるようユーザーにDiscordで呼び掛けた。 ChatGPTのAPI、間もなく公開へ 申し込みページがオープン

ChatGPTのAPI、間もなく公開へ 申し込みページがオープン

米AI研究企業OpenAIが、AIチャットサービス「ChatGPT」のAPIを間もなく公開すると発表した。利用希望者の申し込み用のページも公開している。 神を信じるなら、老化防止薬を飲むべきか? ChatGPTと議論、論文を共同執筆

神を信じるなら、老化防止薬を飲むべきか? ChatGPTと議論、論文を共同執筆

バイオテクノロジー企業Insilico Medicine社のAlex Zhavoronkov氏とOpanAIのChatGPTGenerative Pre-trained Transformerは、OpenAIが開発したChatGPTと協力し、共同執筆した研究報告を発表した。 「なぁAI……人生相談があるんだけど」 なんでも答えてくれる「ChatGPT」に50の質問ぶつけてみた

「なぁAI……人生相談があるんだけど」 なんでも答えてくれる「ChatGPT」に50の質問ぶつけてみた

米AI研究企業OpenAIが公開したチャットbot「ChatGPT」が話題になっている。どんな質問にも真面目に参考になる答えを返してくれる。今回はこのAIに「人生相談」「子供の答えにくい質問」「論理クイズ」「数学未解決問題」など、50の質問をしてみた。