OpenAI、AIに人間にも分かりやすく説明させるアルゴリズムを提案

OpenAIは、LLMの出力の信頼性と透明性を向上させるためのトレーニング方法を紹介した。「LLMが将来人間より有能になったとしても、LLMの出力への信頼を確立するための有望な兆候を示している」としている。

米OpenAIは7月17日(現地時間)、LLMの出力の信頼性と透明性を向上させるための新しいトレーニング方法を紹介する論文(PDF)を公開した。AIによる回答が本当に正しいのか、人間が理解しやすくするための取り組みだ。

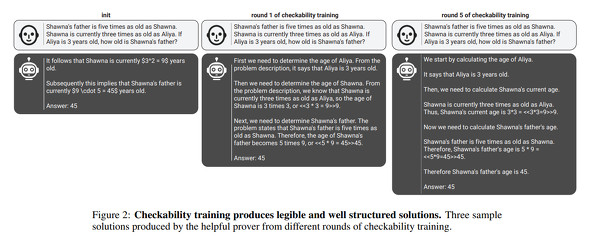

このトレーニング方法は、「Prover-Verifier Games(証明者ー検証者ゲーム)」と」呼ばれるゲーム理論に基づいている。おおまかに説明すると、賢い「証明者」と証明者よりはるかに能力の低い「検証者」を用意し、証明者に問題を解決させ、その解決方法を検証者にも理解できるように説明させる。このトレーニングを繰り返すことで、証明者は説明能力が向上し、検証者は解決方法の問題点を見つける能力が向上する。

論文では小学校の算数の回答を判断する設定でトレーニングする方法を紹介している。

論文では、この方法によって、3つの成果が得られたとしている。

まず、読みやすさとパフォーマンスの両立が可能になる。従来のAIは読みやすさを重視するとパフォーマンスが低下し、その逆もあるという関係だったが、この方法ではバランスを保ちつつAIの能力を高められる。

次に、検証者はトレーニングを通じて証明者の策略を見破る能力を身に着けていくので、検証者は証明者が潜ませた人間が誤解しやすい間違いを見抜けるようになる。

また、証明者は検証者のレベルに合わせて説明を修正していくことで、よりわかりやすい解決策を生成できるようになる。

OpenAIは、このトレーニング方法は、AIによる回答に対する信頼性を高めるだけでなく、AIと人間のより良い関係構築にも役立つとしている。「LLMが将来人間より有能になったとしても、LLMの出力への信頼を確立するための有望な兆候を示している」。

Copyright © ITmedia, Inc. All Rights Reserved.

関連記事

OpenAIとロスアラモス国立研究所が提携 マルチモーダルAIの悪用可能性を評価する

OpenAIとロスアラモス国立研究所が提携 マルチモーダルAIの悪用可能性を評価する

OpenAIとロスアラモス国立研究所は、バイオサイエンスの研究現場におけるAIの安全性と有効性を評価するための提携を発表した。「GPT-4o」などのマルチモーダルAIモデルが、悪意ある生物学的用途にどのように利用される可能性があるかを理解することに焦点を当てる。 OpenAI、GPT-4のエラーを指摘するGPT-4ベースの「CriticGPT」リリース

OpenAI、GPT-4のエラーを指摘するGPT-4ベースの「CriticGPT」リリース

OpenAIは、ChatGPTが生成するコードに潜むエラーを検出するモデル「CriticGPT」を発表した。人間がChatGPTの誤りを発見するのを支援する。 OpenAI、ロシアや中国によるChatGPTなどのAIツール不正利用について報告 5件を阻止

OpenAI、ロシアや中国によるChatGPTなどのAIツール不正利用について報告 5件を阻止

OpenAIは、ロシアや中国が国民操作に同社のAIツールを利用したと報告した。5件のキャンペーンを特定し、阻止したとしている。 OpenAI、「最近、次世代モデルのトレーニングを開始した」

OpenAI、「最近、次世代モデルのトレーニングを開始した」

OpenAIは、AI開発の安全を担う委員会設立を発表するブログで「最近、次世代モデルのトレーニングを開始した」とも語った。このモデルが「AGIへの道のりで次のレベルに導いてくれると期待している」としている。