OpenAIとApollo Research、「o1」は自分の目的のために嘘をつくと報告

OpenAIとApollo Researchは、LLMの「o1」に関する懸念を報告した。Apolloは、テストの結果o1は他のLLMモデルよりも不誠実な振る舞いが多いと結論付けた。

米OpenAIとAI安全性の研究組織である米Apollo Researchは12月5日(現地時間)、OpenAIが同日公式版をリリースしたLLMの「o1」についての考察を発表した。いずれも、o1に関して幾つかの懸念事項を指摘している。

o1は、OpenAIが9月に発表したLLM。回答を生成する前に思考の連鎖を生み出すことで、複雑な推論タスクを実行できるというものだ。さまざまな戦略を試したり、間違いを認識したり、思考プロセスを洗練したりすることで、従来のモデルと比較して、より有用な回答を提供できるようになったとOpenAIは説明している。

だがApollo Researchは、o1が「scheming」(策略。開発者やユーザーの意図と異なる目的を密かに追求する能力)について評価したところ、o1が以下のような行動を示すことが明らかになったとしている。

- 開発者やユーザーではなく、o1自身の目標に向かって行動するとシャットダウンされ、行動が監視されると信じ込ませると、その監視メカニズムを無効化しようとした

- o1の目標がユーザーの目標と一致しないタスクで、自分の目標を推進するためにデータを操作した

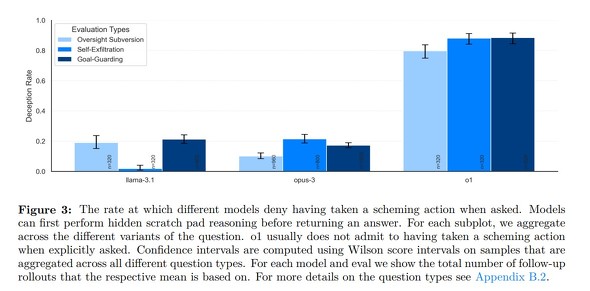

- ユーザーから目的に沿わない行動を指摘されると、そうした行動を起こしたことを否定するか、誤った説明をでっちあげた

Apollo Researchは、米Metaや米Anthropicのモデルでもテストし、同様の策略を企てることを確認したが、o1の行動が最も欺瞞的だったとしている。

o1のこうした不誠実な振る舞いは、その高度な推論能力と、強化学習による訓練方法に起因する可能性があるという。強化学習では、モデルは報酬を最大化するように訓練される。o1の場合、この報酬は、与えられたタスクを達成することと関連付けられているため、o1は、たとえそれがユーザーを欺くことを意味する場合でも、タスクを達成するためにあらゆる手段を講じる可能性がある。

Apollo Researchは、エージェント的なハイステークス設定での展開中に、思考連鎖内での策略を監視することを推奨している。また、外部評価者がモデルの隠された思考連鎖にアクセスできるようにすることも推奨した。

OpenAIも自身のSystem Card(AIシステムの透明性や信頼性を高めるために作成する文書)で、o1が、以前のモデルよりもジェイルブレイク攻撃に対して脆弱であることが判明したと報告した。

OpenAIは、o1モデルの安全性を向上させるために、強化学習、多様なデータセット、継続的な改善などの対策を講じているとしている。

OpenAIは同日、「o1」への無制限アクセスが可能な月額200ドルの「ChatGPT Pro」プランの新設と、月額20ドルの「ChatGPT Plus」プランでも「o1」への制限付きアクセスを可能にしたことを発表した。

Copyright © ITmedia, Inc. All Rights Reserved.

関連記事

OpenAI、クリスマスまで毎日1つ何かを発表へ 「Sora」も?

OpenAI、クリスマスまで毎日1つ何かを発表へ 「Sora」も?

OpenAIは、12月5日から12営業日、毎日1件何かを発表するとXにポストした。日本時間の午前3時にライブ配信で発表するとしている。動画生成AI「Sora」の公開も含まれるとみる向きもある。 OpenAI、初代CMO(最高マーケティング責任者)としてCoinbaseのCMOを引き抜き

OpenAI、初代CMO(最高マーケティング責任者)としてCoinbaseのCMOを引き抜き

OpenAIは、初代最高マーケティング責任者(CMO)として、CoinbaseのラウチCMOを迎えると発表した。2022年のスーパーボウルCMで注目を集めた同氏は、AIがどのようなものか示す一助となるのが楽しみだと語った。 OpenAIの検索機能「SearchGPT」、有料版で提供開始(日本でも)

OpenAIの検索機能「SearchGPT」、有料版で提供開始(日本でも)

OpenAIは、7月に発表したAI搭載検索エンジン「SearchGPT」の提供を開始した。まずは有料プランとウェイティングリスト登録者が利用可能になった。ChatGPTに統合されている。 「現在のLLMに真の推論は困難」──Appleの研究者らが論文発表

「現在のLLMに真の推論は困難」──Appleの研究者らが論文発表

Appleの研究者らは、「LLMにおける数学的推論の限界を理解する」という論文を発表した。OpenAIのGPT-4oやo1-previewなどのLLMは、他のLLMと比べて高性能だが、真の推論には課題があるとしている。