今年のiPhoneは「薄い」だけじゃない 実機に触れて分かった“Appleの戦略“と”隠れたAI”とは?(4/4 ページ)

今年も米Appleが新製品群を発表した。当然ながら、注目は薄型の「iPhone Air」だろう。だが、それ以外からもAppleの戦略は色々見えてくる。今回出たものを現地で触りつつ、「出なかったもの」も考えながら、今のAppleの戦略を分析してみたい。

「AirPods」と「ライブ翻訳」の意味を整理する

今回の発表で、Appleは「AI」の話をあまりしなかった。他のスマホメーカー、特に米Googleや韓国Samsungが「AI」推しであるのとは対照的と言える。

「Siri」の「AI」による強化が延期されており、「Apple Intelligence」の変化をまだ語れないという、世知辛い事情はあるだろう。

一方で、その状況を逆手に取りつつ、「まだAIでの遅れで慌てる時ではない」と言いたいのかもしれない。確かに、10人中10人とは言わないまでも、10人中5人がスマホを買い替えたくなるような「スマホにおけるAIのキラー機能」が見つかっているわけではない。

そんな状況の中でアピールされたのが「AirPods Pro 3」を使った「ライブ翻訳」だ。

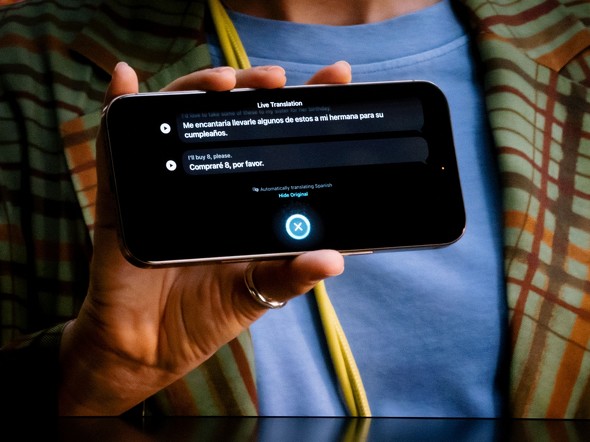

この機能は、違う言語を話している人同士が、iPhoneのオンデバイス翻訳機能を使って話すためのもの。2人ともiPhoneと「AirPods」をつけていれば音声同士で、自分だけがつけている場合には「相手にiPhoneを見せて」翻訳をする。

「AirPods Pro 3」発表の中で紹介されたものの、「AirPods Pro 3」に依存した機能ではなく、 「AirPods Pro 2」や「AirPods 4」でも使える。どちらかといえば、「iOS 26」の「Apple Intelligence」を使った機能なのだ。

なお、「ライブ翻訳」は9月の段階では日本語では使えないものの、年内には日本語対応のアップデートが行われる予定だという。

では「AirPods」以外で使えるか......というとそうではないようだ。というのは、相手の声に翻訳音声を重ねるので、両方が「フルのボリューム」だと聞こえづらい。そこで、周囲の音を聞きつつ相手の声を少し小さくして、翻訳音声は聞きやすいボリュームを維持する仕組みになっている。要はテレビでよく見る「同時通訳」のイメージだ。

イヤフォンのマイクから音を拾いつつ、そういう細かい制御をするには自社製品同士の連携の方がやりやすい。「製品連携」をウリとするAppleとしては、その部分もまた差別化要因としたいのだろう。

Copyright © ITmedia, Inc. All Rights Reserved.

関連記事

「iPhone 16」シリーズ日本価格まとめ 前モデルと値段変わらず

「iPhone 16」シリーズ日本価格まとめ 前モデルと値段変わらず

Apple Japanは、米Appleが発表した「iPhone 16」シリーズの日本価格を公開した。最も安いiPhone 16のストレージ128GBモデルは12万4800円(米国では799米ドル)。前モデルの15シリーズの発表時から、米ドル、日本円ともに価格の変更はなかった。 「iPhone 16 Pro」発表 Maxは史上最大の6.9インチ、Proにも5倍ズーム搭載 4K120fps撮影も

「iPhone 16 Pro」発表 Maxは史上最大の6.9インチ、Proにも5倍ズーム搭載 4K120fps撮影も

米Appleは9月9日(現地時間)、同社のオンラインイベントにて「iPhone 16 Pro」「iPhone 16 Pro Max」を発表した。ディスプレイサイズが大型化した他、Pro専用の新型チップ「A18 PRO」により処理性能をアップ。Pro Maxモデルのみだった5倍ズームがProにも搭載された。 ついに出たSE後継「iPhone 16e」 新廉価モデルと「16」「15」の違いは?

ついに出たSE後継「iPhone 16e」 新廉価モデルと「16」「15」の違いは?

正式発表によって詳細なスペックが判明したいま、15・16と16eを比較し、その差を改めて確認する。 Appleを米司法省がiPhoneでの市場独占で提訴 Appleは「積極的に抗弁する」

Appleを米司法省がiPhoneでの市場独占で提訴 Appleは「積極的に抗弁する」

米司法省は16州とコロンビア特別区とともに、Appleを独禁法違反で提訴した。顧客をiPhoneに依存させ、競合する端末に乗り換える可能性を低くすることを目的とした行為が違法だとしている。 そろそろ、忖度抜きで「iPhone 16e」の話をしよう

そろそろ、忖度抜きで「iPhone 16e」の話をしよう

2月28日に発売になった「iPhone16e」は、10万円を切る価格であったものの、従来の廉価モデルであったSEシリーズと比べれば高いということで「そんな価値あんの?」という話になっている。スマホのスペックにこだわる人ほど、わざわざこれを選んで買わないだろう。多くの記事が指摘するが、何で筆者が16eを買ったかというと、他の人と評価点が違うからである。