AIで競争力を高めたい企業が「インテル Gaudi 3 AI アクセラレーター」の導入を検討すべき理由とは?(4/4 ページ)

既存のAI環境からスムーズに移行できる互換性と使いやすさ

AIの開発者の視点からすると、開発環境における使いやすさも気になる所だろう。Intel AI Summit Japan 2024では、この点もデモを交えて丁寧に説明された。

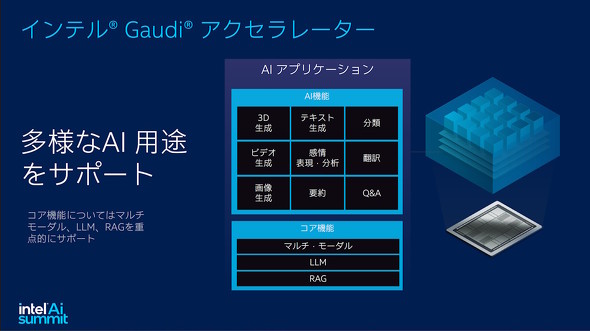

結論からいうと、「できること」という観点ではGPUベースのシステムと変わらない。マルチモーダルAI(2種類以上のデータを統合処理するAI)、LLM(大規模言語モデル)、RAG(外部からのデータを参照できるLLM)など、多様なAIワークロードに対応できる。

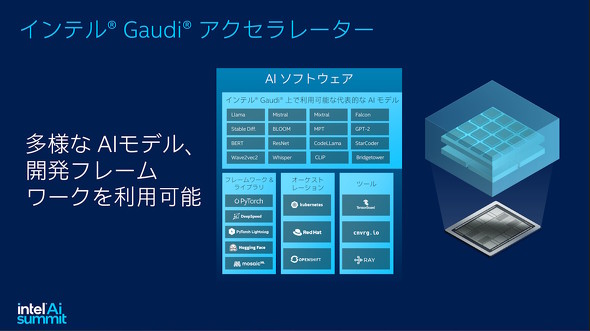

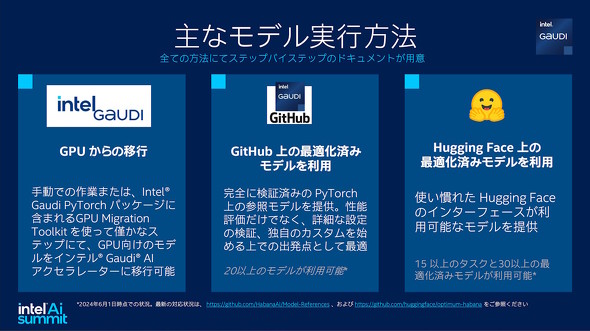

利用するAIモデルについては、主要なAIモデルはもちろん、「PyTorch」「Hugging Face」などの開発フレームワークやオーケストレーションツールなども問題なく利用できるソフトウェアスタックも整備されている。

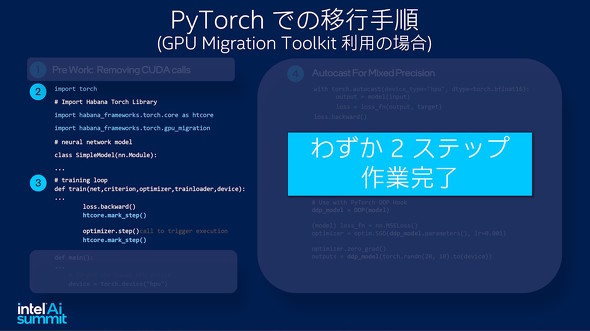

Intel AI Summit Japan 2024では、他社のGPU向けに書かれたプログラムコードを「GPU Migration Tool」を使ってGaudi用に簡単な手順で変換する方法や、Hugging Faceで公開されているAIモデルを簡単な設定をするだけで実行できる様子が紹介された。

インテルによれば、Hugging FaceにはGaudiに最適化されたAIモデルもあるが、「(Gaudi向けに最適化されていないモデルでも)大抵は簡単な設定をするだけでそのまま使える」という。

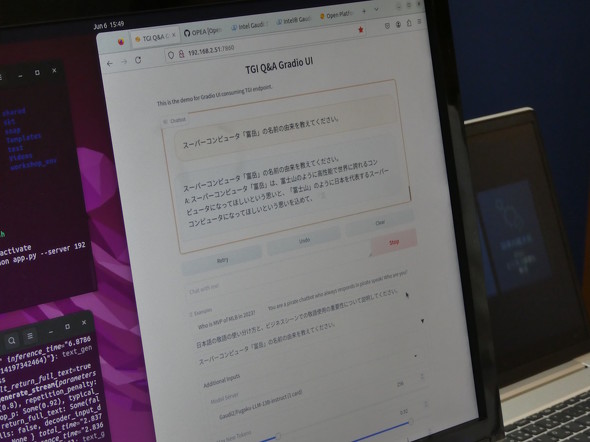

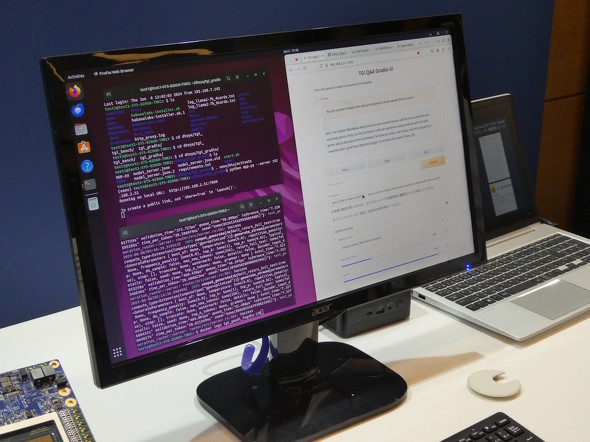

同イベントのデモエリアでは、Hugging Faceで公開されているLLM「LLAMA3-70B」「Fugaku-LLM」をGaudi 2上で実働させるデモも公開されていた。

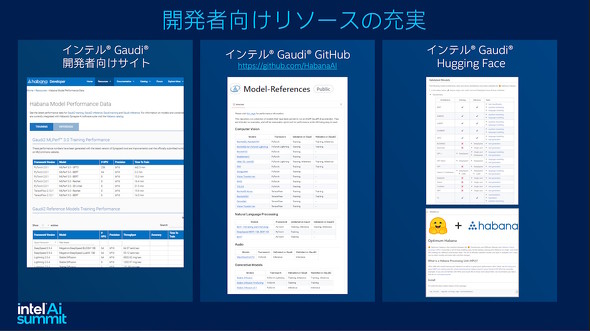

インテルはGitHubやHugging Faceを通してGaudiシリーズに最適化されたAIモデルを公開している他、他のGPUベースで構築されたモデルの移行ツールなど、生成AIの開発を支援するためのさまざまなリソースを提供している

インテルはGitHubやHugging Faceを通してGaudiシリーズに最適化されたAIモデルを公開している他、他のGPUベースで構築されたモデルの移行ツールなど、生成AIの開発を支援するためのさまざまなリソースを提供している Intel AI Summit Japanでは、他のGPU向けに書かれた生成AIコードを「GPU Migration Tool」でGaudiシリーズ向けに変換するデモンストレーションが披露された。同ツールを使えば、面倒なインポート手順を大きく省ける

Intel AI Summit Japanでは、他のGPU向けに書かれた生成AIコードを「GPU Migration Tool」でGaudiシリーズ向けに変換するデモンストレーションが披露された。同ツールを使えば、面倒なインポート手順を大きく省ける デモエリアでは、シンガポールに設置されたGaudi 2搭載サーバを使って「LLAMA3-70B」(Gaudi 2×8基)や「Fugaku-LLM」(Gaudi 2×1基)を動かすデモンストレーションが行われていた

デモエリアでは、シンガポールに設置されたGaudi 2搭載サーバを使って「LLAMA3-70B」(Gaudi 2×8基)や「Fugaku-LLM」(Gaudi 2×1基)を動かすデモンストレーションが行われていたオンラインでGaudiを試せる「Tiber デベロッパー・クラウド」

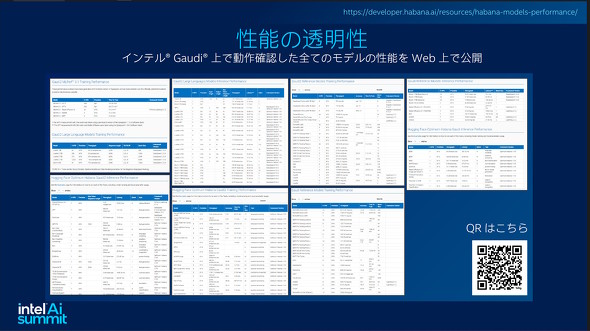

インテルでは、Gaudiシリーズでの稼働を確認したAIモデルの性能をWeb上で公開している。「期待通りの性能を出せるのだろうか?」と気になる人は、ぜひチェックしてみてほしい。

また同社は、クラウドベースの開発環境「Tiber デベロッパー・クラウド」を通してGaudiシリーズを利用できるサービスも提供している。現在はGaudi 2ベースだが、2024年後半からはGaudi 3も試せるようになる。「自分が作ったAIモデルがきちんと動くのか?」「互換性に問題は生じないか?」という、開発者的に気になるポイントをクリアしてから本格導入できることは心強い。

参入システムベンダーも増加 Gaudiは「AIの新たな選択肢」に浮上

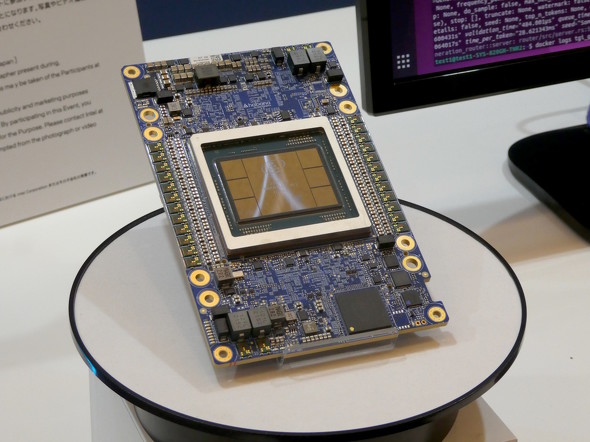

Gaudi 3は“AI専用”というメリットを生かしたスマートかつ洗練されたアーキテクチャのハードウェアと、一気通貫で開発されたソフトウェアスタックを備え、開発をサポートするリソースも手厚く用意されている。

Gaudi 3の導入コストについては「競争力のあるコストで提供していく方針は先代同様」だという。コストと性能のバランスを考えて生成AIシステムを構築したいという企業や機関の担当者は要注目だ。さらにコスト効率にも優れるとなれば、AIエンジニアならば期待せずにはいられない存在といえる。

実際、システムベンダーの動きもこれまでとは変わってきた。先代のGaudi 2で実績のあるSuper Micro Computerに加え、Dell、Lenovo、HPなどといったメジャーベンダーも既にGaudi 3を搭載したサーバを投入することを決めている。

導入に至るまでには、システムレベルでのさまざまな検証が必要だろうが、AIの開発運用を考えているならば、インテル Gaudi 3 AI アクセラレーターは「AIの新しい選択肢」として検討対象に入れておくべきなのは間違いない。

Copyright © ITmedia, Inc. All Rights Reserved.

提供:インテル株式会社

アイティメディア営業企画/制作:ITmedia PC USER 編集部/掲載内容有効期限:2024年6月27日