MIT、人種差別的と批判された大規模画像データセット「Tiny Images」をオフラインに

MITの画像データセット「Tiny Images」に黒人や女性の蔑称のラベルが使われるという指摘があり、MITはこのデータセットをオフラインにし、謝罪した。

米マサチューセッツ工科大学(MIT)は6月29日(現地時間)、多数のAIシステムのトレーニングに利用されてきた8000万点以上の画像を集めたデータセット「Tiny Images」をオフラインにしたと発表した。カテゴライズの用語に差別的なものがあると指摘されたため。

MITのアントニオ・トラルバ教授は声明文で、「影響を受けた可能性のある人々に謝罪する」と語った。

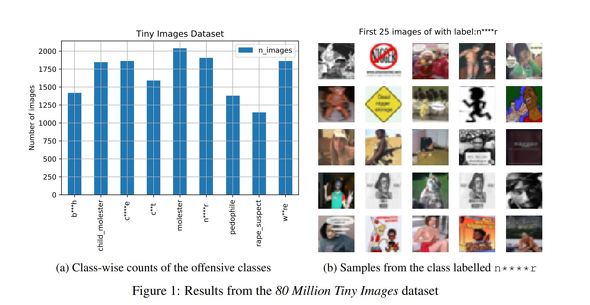

問題を指摘したのはプライバシー関連の米新興企業UnifyIDのチーフサイエンティスト、ビナイ・プラブー氏とアイルランド国立大学ダブリン校のアベバ・ビルハネ教授。両氏は6月25日、「Large image datasets: A pyrrhic win for computer vision?」(リンク先はPDF)という匿名の論文(7月1日に正式版を公開)で、Tiny Imagesに女性の画像に「売春婦」というラベルが付いていたり、黒人の画像に黒人の蔑称のラベルが付いていたりする例を具体的に挙げた。

トラルバ教授は、修正するにはデータセットが大きすぎ、画像が32×32ピクセルと非常に小さいため、手作業による修正は困難と判断し、完全にオフラインにする決定を下したと説明した。

このデータセットは2006年に作成された。その際、プリンストン大学認知科学研究所のWordnetからコピーした5万3464語の名詞をラベルとして使い、これらの用語に対応する画像を検索エンジンを使って自動ダウンロードし、8000万件の画像を収集したという。

このデータセットを使ってトレーニングしたニューラルネットワークは当然、データセットで使われているラベルを使うことになる。

問題を指摘したプラブー氏とビルハネ教授は論文で、この問題は社会的および文化的構造に深く根ざしており、簡単な解決策はないと指摘。Tiny Imageだけでなく、広く利用されているデータセット「ImageNet」にも同様の問題があるという。だが、解決のために例えばバイアスを完全に取り除くという考えは、単に問題を隠すことに繋がるとしている。「機械学習コミュニティが、社会的弱者への影響に細心の注意を払うことを強く推奨する。そのためには、歴史的前例、コンテキスト、政治的側面の認識が不可欠だ。この論文が意識向上に貢献し、機会学習における倫理と正義についての議論に役立つことを願う」

Copyright © ITmedia, Inc. All Rights Reserved.

関連記事

IBM、顔認識事業からの撤退を宣言 「人種プロファイリングや自由の侵害を容認しない」

IBM、顔認識事業からの撤退を宣言 「人種プロファイリングや自由の侵害を容認しない」

IBMが、汎用的な顔認識技術の開発と提供を廃止すると発表した。黒人男性が白人警官の暴行で死亡したことを契機に全米で人種差別抗議運動が続く中、「今こそ、法執行機関が顔認識技術を採用すべきかどうか話し合うべき時だ」とクリシュナCEO。 Google、プライバシーを保護しながらデータセットを解析する「Private Join and Compute」をオープンソース化

Google、プライバシーを保護しながらデータセットを解析する「Private Join and Compute」をオープンソース化

Googleが、プライバシー保護の取り組みの一環で、データを暗号化したまま処理するツール「Private Join and Compute」をオープンソースで公開した。 Microsoft、セレブ(以外も含まれていた)顔データセットをひっそり削除──Financial Times報道

Microsoft、セレブ(以外も含まれていた)顔データセットをひっそり削除──Financial Times報道

Microsoftが2016年に公開した約100万人の顔画像を含むデータセット「MS Celeb」に非セレブの個人画像も含まれていたとFinancial Timesが指摘した後、Microsoftがこのデータセットを削除した。 私たちの顔はアート向き? GoogleのAIが苦慮する人種対応

私たちの顔はアート向き? GoogleのAIが苦慮する人種対応

2年前、黒人女性の写真を「ゴリラ」と判断してしまったGoogleの画像認識AI。最近米国でスタートしたセルフィーをアート作品とマッチングする機能は大丈夫でしょうか?