ニュース

単眼カメラの映像から人物の3Dモデル(衣服込み)をリアルタイム生成 深層学習で:Innovative Tech

深度センサーなしで背面の衣服のテクスチャも推定し、高精度の3Dモデルを作成できる。

Innovative Tech:

このコーナーでは、テクノロジーの最新研究を紹介するWebメディア「Seamless」を主宰する山下裕毅氏が執筆。新規性の高い科学論文を山下氏がピックアップし、解説する。

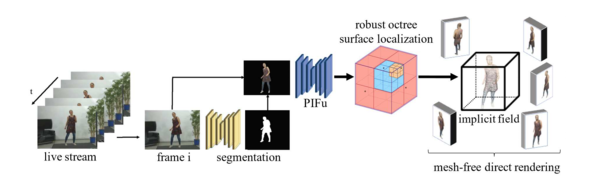

南カリフォルニア大学、USC Institute for Creative Technologies、Pinscreenによる米研究チームが開発した「Monocular Real-Time Volumetric Performance Capture」は、衣服を着た動く人物の3次元モデルをリアルタイムに生成する深層学習ベースのフレームワークだ。

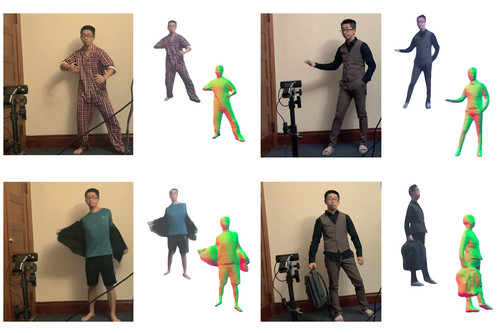

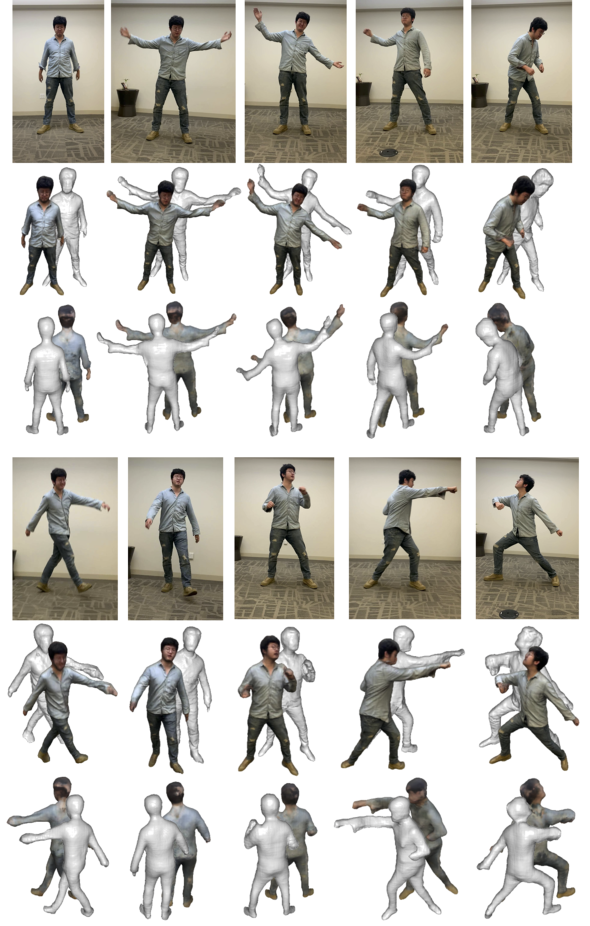

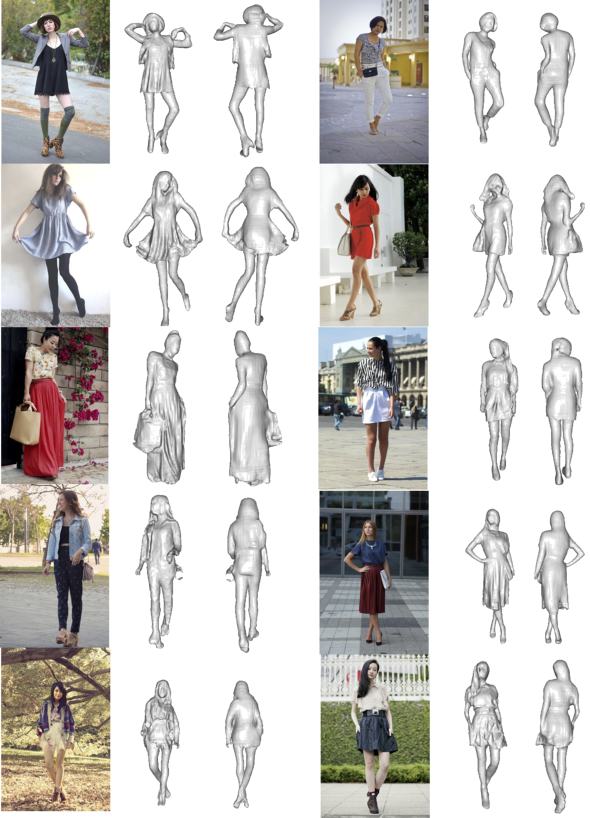

単眼のRGBカメラで一方向から撮影した映像から、見えない背面などを含む全身の演技をリアルタイムでキャプチャーする。隠れた部分のテクスチャも推定するため、質感を持った衣服を着た人間の、多様なポーズを生成できる。

1枚の画像から完全なテクスチャを持つ着衣の人物の3次元モデルを再構築する「PIFu」(Pixel-Aligned Implicit Function)を利用して、各フレームから生成する。計算コストが高いPIFuをリアルタイムで処理するために、新しいテクスチャ再構成アルゴリズムと、メッシュを抽出する必要のないダイレクトレンダリング法を採用した。

さまざまな角度、異なる照明、ポーズ、服のスタイルなどの困難な条件で実験を行ったところ、安定した精度を実証したという。

今回は人間が対象だったが、他の物体への実装も可能だとしている。

Copyright © ITmedia, Inc. All Rights Reserved.

関連記事

表と裏を独立検知できる布地タッチセンサー Google、「ZebraSense」開発

表と裏を独立検知できる布地タッチセンサー Google、「ZebraSense」開発

表裏のセンサーを交互に組み込むことで、表からも裏からも操作可能。 協調して動く球体ロボット群「FreeBOT」 くっついたり離れたり、転がったり壁を登ったり

協調して動く球体ロボット群「FreeBOT」 くっついたり離れたり、転がったり壁を登ったり

自律システムの構築も目指す。 レトロゲーム機でレトロゲームを自作 Microsoftが「TileCode」開発

レトロゲーム機でレトロゲームを自作 Microsoftが「TileCode」開発

「ツクール」など同種のものはあるが、今回はMSが構築した。