生成AIに“生成AIが作った文章”を学習させ続けるとどうなる? 「役立たずになる」と英国チームが報告:Innovative Tech

英オックスフォード大学や英ケンブリッジ大学、英インペリアル・カレッジ・ロンドン、米トロント大学に所属する研究者らは、GPT-4などの大規模言語モデル(LLM)が別のLLMが生成したテキストを学習し続けるとどうなるかを調査した研究報告を発表した。

Innovative Tech:

このコーナーでは、テクノロジーの最新研究を紹介するWebメディア「Seamless」を主宰する山下裕毅氏が執筆。新規性の高い科学論文を山下氏がピックアップし、解説する。Twitter: @shiropen2

英オックスフォード大学や英ケンブリッジ大学、英インペリアル・カレッジ・ロンドン、米トロント大学に所属する研究者らが発表した論文「The Curse of Recursion: Training on Generated Data Makes Models Forget」は、GPT-4などの大規模言語モデル(LLM)が別のLLMが生成したテキストを学習し続けるとどうなるかを調査した研究報告である。

今後、LLMモデルを使って生成した文章がネット上に溢れかえる未来、それらを多く含むデータをトレーニングする後続のLLMモデルはどうなるかを検証する。

LLMモデルの開発には、大量の学習データが必要になる。ユーザーがLLMモデルを利用して文章を生成するケースが増えており、その結果、多くの文章がインターネット上に公開される。近年の強力なモデルの中には、Web上の情報を学習データとして使用するものもある。将来のモデルの学習データがほとんどがWebからのスクレイピングに頼る場合、前のモデルが生成したデータを学習に使用する必要が生じる。

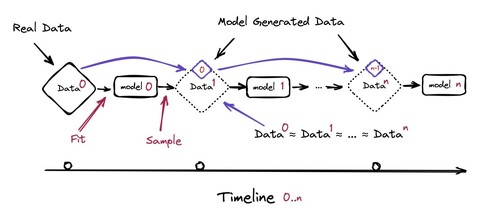

この研究では、例えばGPTの特定のバージョンから生成したテキストが、後続モデルの学習データセットの大部分を占める場合、どのような影響が生じるのかを調査する。

研究の結果、他のAIモデルの出力を使用してトレーニングしたAIモデルは、大きく偏りが生じ、過度に単純化され、現実との接点を失ってしまうことが明らかになった。その結果、最終的には機能的に役に立たなくなり、モデルが崩壊する可能性を示した。

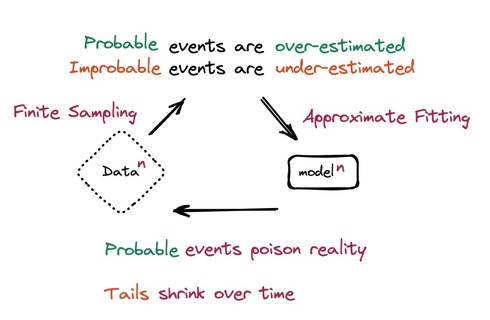

このエラーは、AIモデルがテキストを統計的に表現する方法に起因する。AIモデルは、フレーズや文を何度も見ることで学習するため、そのフレーズを出力の中で繰り返す傾向が高くなり、まれに見るフレーズを生成する可能性が低くなる。

その後、新しいモデルが他のAIモデルからのテキストでトレーニングすると、元のAIモデルの可能な出力のごく一部しか認識されないという問題が生じる。

トレーニングデータの多様性が十分に確保されていない場合、モデル自体やそのトレーニング方法に欠陥が生じる可能性がある。実際、基礎となるデータを完全に表現することは困難であり、その結果、状況は一層悪化する。

このプロセスがどれくらい早く起こるかは、AIモデルのトレーニングデータ内のAI生成コンテンツの量と、AIが使用するモデルの種類によって異なるが、AI生成のデータにさらされる全てのモデルは最終的に崩壊するという。これはLLMモデルだけでなく、変分オートエンコーダー(VAE)、混合ガウスモデルでも同様の結果が得られた。

これを回避する唯一の方法は、人間が作成した本物のコンテンツへのアクセスが不可欠であり、それを実現するためには、AIモデルが生成した出力にラベルを付けて除外することだという。

Source and Image Credits: Shumailov, Ilia, Zakhar Shumaylov, Yiren Zhao, Yarin Gal, Nicolas Papernot, and Ross Anderson. “Model Dementia: Generated Data Makes Models Forget.” arXiv preprint arXiv:2305.17493(2023).

Copyright © ITmedia, Inc. All Rights Reserved.

関連記事

ChatGPTでフィッシングサイトを自動検出する方法 NTTセキュリティが開発 精度は98%以上

ChatGPTでフィッシングサイトを自動検出する方法 NTTセキュリティが開発 精度は98%以上

NTTセキュリティ・ジャパンに所属する研究者らは、ChatGPTでフィッシングサイトを検出する手法を提案した研究報告を発表した。 草津温泉、AIフル活用のPR動画を公開 「本物との違いをお楽しみいただけたら」

草津温泉、AIフル活用のPR動画を公開 「本物との違いをお楽しみいただけたら」

草津温泉観光協会は19日、ChatGPTなどのAIを活用して制作した観光PR動画をYouTubeで公開したと発表した。 「マイナカード、国会でどう議論された?」 議事録を自然文で検索できるChatGPTプラグイン公開

「マイナカード、国会でどう議論された?」 議事録を自然文で検索できるChatGPTプラグイン公開

ChatGPT上で動作する、国会議事録の検索プラグイン公開。「マイナンバーカードのセキュリティ問題について、国会で出た主な意見を整理して教えて」などと自然文に回答。 社長から「ChatGPTを調べろ」と言われた──そんなときに役立つ“ChatGPT概論” データ分析企業が公開

社長から「ChatGPTを調べろ」と言われた──そんなときに役立つ“ChatGPT概論” データ分析企業が公開

「ChatGPTについて調べてくれ」と社長から特命を受けた──そんな人たちに向けた資料が無償公開され話題を集めている。 「自社版ChatGPT」をグループ全社導入 約1万5000人で2カ月使った手応えは? ベネッセに聞いた

「自社版ChatGPT」をグループ全社導入 約1万5000人で2カ月使った手応えは? ベネッセに聞いた

「自社版ChatGPT」をグループ全社に導入したベネッセ。導入から2カ月余り、現状の手応えをキーパーソンに聞いた。