言語生成AIの入力文、最初と最後に“重要情報”を入れた方が良い結果に 米スタンフォード大などが検証:Innovative Tech

米スタンフォード大学などに所属する研究者らは、大規模言語モデル(LLM)の性能について、入力コンテキストの長さや関連情報の位置を変えることでどのような影響があるかについて調査した研究報告を発表した。

Innovative Tech:

このコーナーでは、2014年から先端テクノロジーの研究を論文単位で記事にしているWebメディア「Seamless」(シームレス)を主宰する山下裕毅氏が執筆。新規性の高い科学論文を山下氏がピックアップし、解説する。

Twitter: @shiropen2

米スタンフォード大学などに所属する研究者らが発表した論文「Lost in the Middle: How Language Models Use Long Contexts」は、大規模言語モデル(LLM)の性能について、入力コンテキストの長さや関連情報(答えを含む文書)の位置を変えることでどのような影響があるかについて調査した研究報告である。

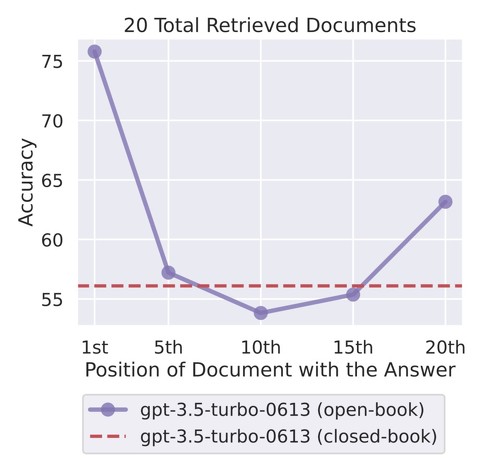

調査結果から、関連情報を入力コンテキストの最初に記入すると最も高い精度が得られ、入力コンテキストの最後に関連情報を記入すると次に高い精度が得られることが分かった。一方、関連情報を中央に配置すると精度が著しく低下した。つまり、重要な情報をモデルに意識させたい場合は、最初と最後に配置することが望ましいとなる。

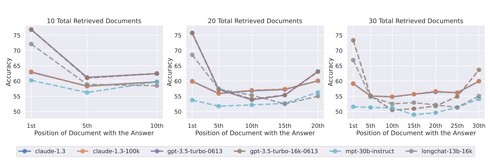

入力コンテキストが長くなるほどパフォーマンスが低下することも明らかになった。

言語モデルは一般的にTransformerで実装されるが、Transformerは長いシーケンス(トークン数)を弱点としている。トークンとは、テキストを単語や文字、句読点、記号などに分解したパーツを指す。そのためChatGPT(GPT-4)でもトークン数は3万程度である。

この研究では、一般的な言語モデルにおいて、入力コンテキストのサイズと入力コンテキスト内の関連情報の位置に制御された変更を加え、モデルのパフォーマンスへの影響を調査する。

具体的には、入力コンテキストにより多くの文書を追加することで入力コンテキストの長さを増加させ、入力コンテキスト内の文書の順序を変更することでコンテキスト内の関連情報の位置を変更し、関連文書をコンテキストの先頭、中間、または末尾に配置する。

言語モデルには、オープン(MPT-30B-Instruct、LongChat-13B(16K)とクローズ(OpenAIのGPT3.5-TurboとAnthropicのClaude)を用いる。

結果、関連情報が入力コンテキストの最初か最後にあるとき、言語モデルの性能は最も高く、入力コンテキストの途中の情報にアクセスして使用しなければならないとき、性能は著しく低下すると分かった。

さらに、文脈が長くなるとモデルの性能は着実に低下することが分かった。これはモデルが長い入力コンテクストから関連する情報を検索して利用するのに苦労していることを示している。

トークンの制限数を増やせば増やすほど、より多くの背景を考慮できるため、適切な回答が可能と考えられる仮説もあるが、この研究結果により、その仮説に疑問が投げかけられた。

Source and Image Credits: Nelson F. Liu, Kevin Lin, John Hewitt, Ashwin Paranjape, Michele Bevilacqua, Fabio Petroni, Percy Liang. Lost in the Middle: How Language Models Use Long Contexts

Copyright © ITmedia, Inc. All Rights Reserved.

関連記事

生成AIに“生成AIが作った文章”を学習させ続けるとどうなる? 「役立たずになる」と英国チームが報告

生成AIに“生成AIが作った文章”を学習させ続けるとどうなる? 「役立たずになる」と英国チームが報告

英オックスフォード大学や英ケンブリッジ大学、英インペリアル・カレッジ・ロンドン、米トロント大学に所属する研究者らは、GPT-4などの大規模言語モデル(LLM)が別のLLMが生成したテキストを学習し続けるとどうなるかを調査した研究報告を発表した。 GPT-4以上? 自分で何度も“推敲”し完成度を上げる言語生成AI「Self-Refine」

GPT-4以上? 自分で何度も“推敲”し完成度を上げる言語生成AI「Self-Refine」

米カーネギーメロン大学などの研究者らは、大規模言語モデル(LLM)が、より高品質な出力を生成するために、反復的な改良と自己評価を利用することを可能にする新しいフレームワークを提案した研究報告を発表した。 言語生成AIは文章を“盗作”しているのか? 21万件の文章から米国の研究者らが分析

言語生成AIは文章を“盗作”しているのか? 21万件の文章から米国の研究者らが分析

米ペンシルベニア州立大学と米ミシシッピ大学に所属する研究者らは、自然言語生成モデルが剽窃(ひょうせつ)している可能性を分析した研究報告を発表した。 画像生成AIの「高品質なプロンプト」を0.01秒で盗むサイバー攻撃 ドイツの研究機関が発表

画像生成AIの「高品質なプロンプト」を0.01秒で盗むサイバー攻撃 ドイツの研究機関が発表

ドイツの研究機関CISPA Helmholtz Center for Information Securityに所属する研究者らは、テキストから画像を生成するモデルで生成した画像からテキストプロンプトを盗用する攻撃を提案した研究報告を発表した。 画像生成AIが「トレパク」していた? 学習画像と“ほぼ同じ”生成画像を複数特定 米Googleなどが調査

画像生成AIが「トレパク」していた? 学習画像と“ほぼ同じ”生成画像を複数特定 米Googleなどが調査

米Google、米DeepMind、スイスのETH Zurich、米プリンストン大学、米UC Berkeleyに所属する研究者らは、テキストから画像を生成する拡散モデルが学習データとほぼ同じ画像を生成していたことを実証した研究報告を発表した。