Cerebras、「NVIDIAのGPUベースより20倍高速」謳うAI推論サービス提供開始

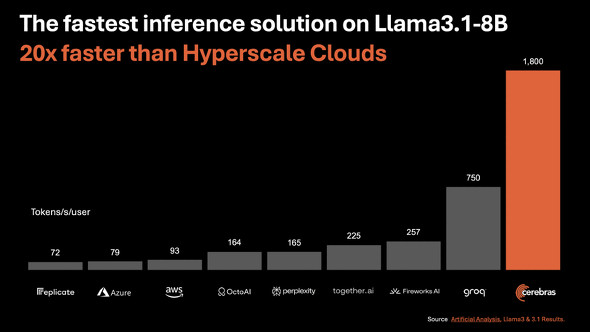

Cerebras Systemsは、AI推論ソリューション「Cerebras Inference」を発表した。「世界最速」でNVIDIAのサービスより20倍高速ではるかに安価だとしている。

米Cerebras Systemsは8月27日(現地時間)、AI開発者が同社のシステムにアクセスしてアプリを実行できるようにするAI推論ソリューション「Cerebras Inference」を発表した。「米NVIDIAのGPUベースのハイパースケールクラウドより20倍高速」で、はるかに安価だとしている。

Llama3.1 8Bで1秒当り1800トークン、Llama3.1 70Bで1秒当り450トークンを提供し、価格はLama 3.1 8Bで100万トークン当り10セント、Llama 3 70Bで100万トークン当り60セント。

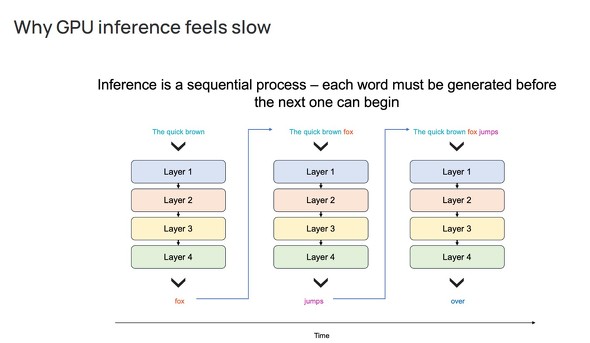

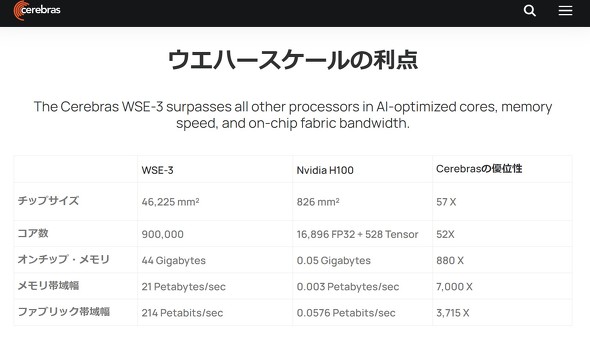

Cerebrasは発表文で、NVIDIAなどのGPUシステムが推論に向かない理由を説明し、自社のシステムは「世界最大のチップを構築し、モデル全体をオンチップに保存することで、メモリ帯域幅のボトルネックを解決する」ことで、GPUのような遅延を解消したと主張する。

Cerebrasのチップは独自のウェーハスケール設計により、44GBのSRAMを1つのチップに統合できるという。総メモリ帯域幅は21ペタバイト/秒で、NVIDIAのH100の7000倍に当たる。

同日から、チャットとAPIアクセスを介してのCerebras Inferenceの提供を開始する。まずはLlama3.1 8Bおよび70Bモデルを提供し、数週間中により大規模なモデルのサポートを追加する予定だ。

Cerebras Systemsは、米国カリフォルニア州サニーベールに拠点を置く2016年創業の非公開企業。AIやディープラーニングの処理専用のコンピュータシステムの開発を手掛けている。

Copyright © ITmedia, Inc. All Rights Reserved.

関連記事

Cloudflare、CDNエッジで生成AIを実行できる「Workers AI」正式リリース 世界150都市のデータセンターでGPU基盤を提供

Cloudflare、CDNエッジで生成AIを実行できる「Workers AI」正式リリース 世界150都市のデータセンターでGPU基盤を提供

米Cloudflareは、同社のグローバルに展開するCDNのエッジで生成AIの推論処理を実行できる「Worker AI」の正式サービス化を発表しました。 NVIDIA、AI需要で過去最高の売上高 「次の産業革命が始まった」とファンCEO

NVIDIA、AI需要で過去最高の売上高 「次の産業革命が始まった」とファンCEO

NVIDIAの2月〜4月の決算は、売上高は前年同期比約3.6倍の260億4400万ドル、純利益は約7.3倍だった。AI需要でデータセンター向けGPUが快調で、ファンCEOは「次の産業革命が始まった」と語った。 AIの「学習」と「推論」って何が違うの? “ハコ”に例えてカンタン解説

AIの「学習」と「推論」って何が違うの? “ハコ”に例えてカンタン解説

AIの「学習」と「推論」は何が違うのか。この違いを押さえておくことで、AIに関する議論をする際にもポイントが分かりやすくなるはずだ。 Cerebrasが1億ドルのAIスパコンを販売

Cerebrasが1億ドルのAIスパコンを販売

AIアクセラレーターシステムを手掛けるCerebrasが、同システムをベースにしたAIスーパーコンピュータ(スパコン)を構築する。5400万のAIコアと4EFLOPSの演算性能を持つスパコンで、価格は1億米ドルを超えるという。