「iPhone XS/XR」でハッキリした“進化の道筋” Appleは何をやりたいのか:本田雅一のクロスオーバーデジタル(2/4 ページ)

米サンフランシスコで行われたAppleの発表会を現地で取材し、iPhone XS/XS Max/XRを知って見て触ってハッキリしてきたこと、Appleが今後何をやろうとしているのかをお伝えする。

「Neural Engineの進化」に力を注いだ2018年モデル

2018年のiPhoneは、iPhone Xシリーズに進化版と新サイズのバリエーション、それに低価格版が追加され、全部で3モデルの展開となった。

iPhoneは多くの利用者にとって生活の基盤になっているため、当然ながらハードウェアのスペックやカラーリング、持ちやすさなどに注目が集まるところだが、一方で“プラットフォームとしてのiPhone”に着目すると、その価値は新しいSoCのA12 Bionicにある。

なぜここに注目するかといえば、Appleは半導体設計を7nmに微細化することで増えた搭載トランジスタ数のうち、かなり多くを「Neural Engine(ニューラルエンジン)」と呼ぶApple独自のニューラルネットワーク処理に特化したプロセッサに割り当てていると推察されるためだ。

先代の「A11 Bionic」は43億個、今回のA12 Bionicは69億個のトランジスタで構成されている。

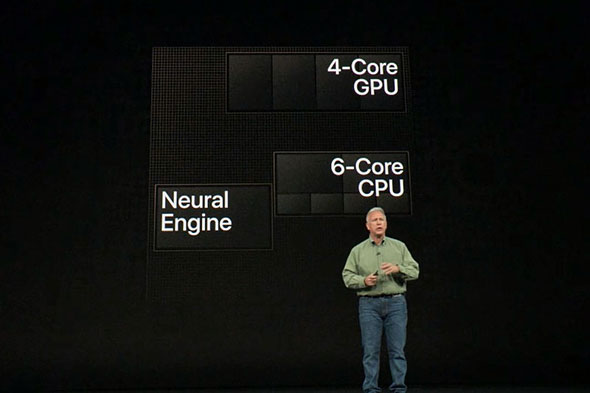

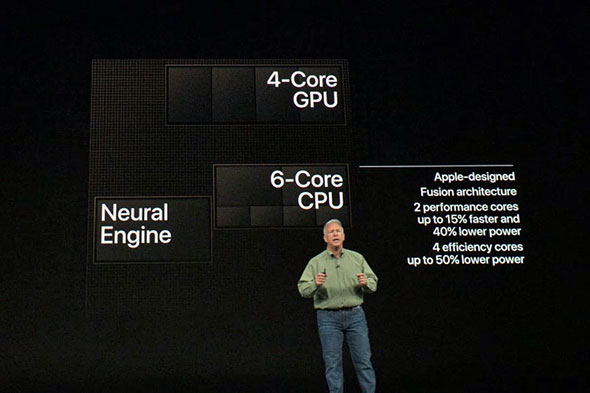

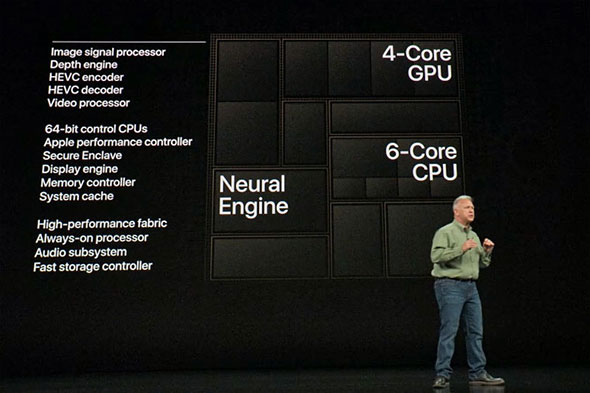

CPUの改良も施されているが、主に高効率化を図ることによるパフォーマンスのチューニングが主で、高性能コア2個と低消費電力高効率コア4個を用いた合計6コアの構成はA11 Bionicと全く同じだ。

このうち高性能コアの性能は最大15%高速かつ40%省電力に、低消費電力高効率コアは“iPhone 6世代の高性能コアと同等”のパフォーマンスをそのままに、A11 Bionicに比べ50%省電力になった。

Appleは例によって多くを語らないが、大幅なアーキテクチャの変更というよりはプロセッサ全体の動作を調整することで効率を高め、消費電力当たりのパフォーマンスを向上させる中でピーク性能も上がったものだと推察される。

既にベンチマークテスト「Geekbench」の結果が報告されるなどしているが、その結果もこうした説明を反映しており、性能は上がっているが劇的なものではない。

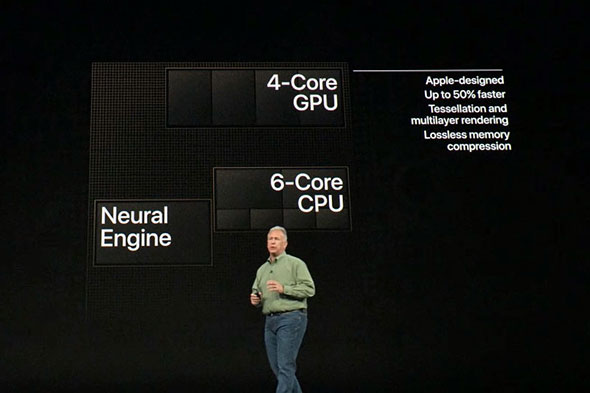

GPUに関してはコア数が3個から4個に増え、最大で50%高速と公開された。Apple独自アーキテクチャのGPUはA12 Bionicで2世代目となるが、アーキテクチャの更新について言及はない。しかし3個だったGPUコアは4個に増加し、さらにテクスチャ圧縮、展開のハードウェアを搭載することでメモリの実効帯域を2倍に拡大したことで、トータル50%の性能向上を実現している。

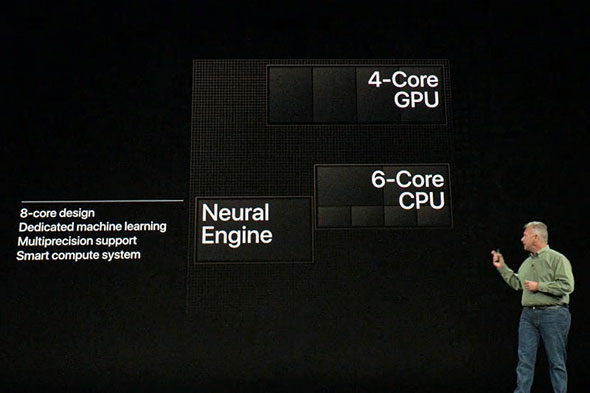

しかし、これだけではトランジスタ数が1.5倍以上に激増している理由は説明できない。もちろん、後述するISP(イメージシグナルプロセッサ)の性能向上も大きいが、Neural Engineは2コアだったA11 Bionicに対して、A12 Bionicは8コアにまで増量されている。

しかも、Appleの機械学習用クラスライブラリ「Core ML」を用いた場合の性能はおよそ9倍。単純なコア数の増加だけでなく、アーキテクチャの面で大幅な進歩があったことをうかがわせる数字だ。しかも、消費電力当たりの計算能力は10倍に達する。

ダイ上でCPUに迫る面積を占めるようになったNeural Engine

AppleはA12 Bionicに使っている回路規模の内訳を公開していないが、プレゼンテーションで使われたプロセッサコアの図が正確なものであると仮定するなら(慣例からいえば、大抵は正しい比率になっている)、新しいNeural Engineには、GPUコア×2.5個分ぐらい、CPUブロック全体と比較すると80〜85%程度の面積が割り当てられている模様だ。

これまでの常識であれば、CPUとGPUにトランジスタを割り当て、ピーク性能を高めることで新たなアプリケーションの登場を促しつつ、自社で開発するアプリ(OS標準搭載を含む)の向上に力を入れるところだ。

恐らく消費者に対しても「何倍の性能」と訴求しやすかっただろうが、あえてそうはせず、Neural Engineに多くのトランジスタを割り当てたのは、単にiPhone XS/XS Max/XRの性能や機能を向上させるということではなく、今後、進化していく方向として(コア数を増やしたGPUはともかく)、CPUの強化によるジェネラルコンピューティング能力の向上だけでは未来がない、と考えたからではないだろうか。

現時点においては、GPU、CPUと比べても規模はまだ小さいものの、今後はCPUを超えてGPUと同等、あるいはそれ以上の面積を占めるようになるだろう。なぜなら、Neural Engineが実行している機械学習の処理を、より深みのあるものにしていくには処理能力がいくらあっても無駄にならないからだ。このジャンルはまだスタート段階にすぎない。

そして、その可能性を示す一種の“サンプル”として用意されているのが、新たなカメラ機能だとも捉えられる。もちろん、カメラ機能の向上は端末そのものの魅力を高めるものでもあるのだが、それは一つの用途にすぎない。そこでインスパイアされたエンジニア、あるいは昨年開発者に提供したCore MLを使ったアプリが、9倍の能力を得たことで何らかのチャレンジに取り組む基礎を作ろうとしているのだ。

同時にA12 Bionicでは写真や動画の信号処理を行うISPの規模も大きくなっており、Neural Engineと連動して被写体深度の認識処理を行ったり、より高度なノイズ処理が可能となったりしたようだ。

このやり方は、戦略的にも極めて重要なものだ。なぜなら、まだ初期段階にあるニューラルネットワーク処理においては、OSだけでも、アプリ(および開発するためのツール)だけでも解決はせず、専用プロセッサの改良とともに歩んでいかねば、新たな価値を生み出す速度に制約が出てくるためだ。

例えばだが、一般的にスマートフォンの上位機種に用いられることが多いQualcommのSoCは、ISPの機能に関して低レベルのソースコードへのアクセスができず、開発ツールで調整を行うか、一定のインタフェースを通じてしか映像処理に関与できない。端末メーカーとしては、そこがカメラ機能を進化させる上での制約になる。

しかしAppleならば自社で開発したISP、GPU、Neural Engineを用いて、カメラをつかさどるあらゆる機能を調整した上で、最終的にNeural Engineを用いて“人が好ましいと感じる絵柄”を自動的に生み出していける。

このように今世代のiPhoneで最も顕著なのは、カメラ機能の部分でNeural Engineが多く活用され、そこに着目する開発者を誘引し、興味を引く……簡単に言うならば、開発者がワクワクするような場を提供しようとしていることだろう。

Copyright © ITmedia, Inc. All Rights Reserved.