M4 Mac miniで「gpt-oss」は動く? 動作が確認できたローカルLLMは……:“超”初心者向けローカルAI「gpt-oss」導入ガイド(5)(2/5 ページ)

本連載ではローカルLLMの導入方法から活用方法に至るまで、「手元にハイエンドPCがあって、生成AIをローカル環境で動かしてみたい」という初心者の方にも分かりやすく連載で解説する。

M4 Mac miniでgpt-oss-20bを動かしてみよう

M4 Mac miniでもWindowsと変わらず、LM Studioを使って簡単にgpt-oss-20bの導入が可能だ。macOS向けに本記事ではLM Studioの導入から、gpt-oss-20bの実行まで分かりやすく解説しよう。

LM Studioの導入

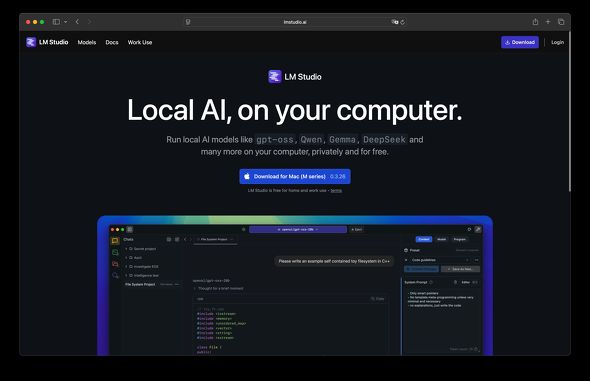

LM Studioの公式サイトにアクセスし、「Download for Mac(M series)」ボタンをクリックしてLM Studioをダウンロードする。

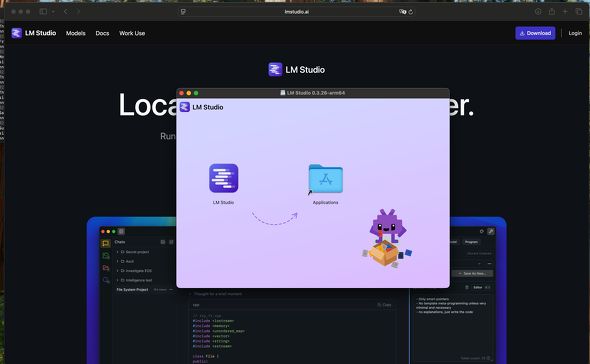

「LM-Studio-0.3.26-6-arm64.dmg」(記事公開時の最新バージョン)ファイルがFinder上にダウンロードされるので、ダブルクリックして開く。

すると、LM Studioアプリが表示されるので「Applications(アプリケーション)」ディレクトリにドラッグ&ドロップしてアプリのインストールを完了させよう。

コピーが完了したら、Finderでアプリケーションディレクトリを開き、「LM Studio」をダブルクリックして起動する。

Windowsと比べると、アプリのインストールは基本的にドラッグ&ドロップで済むので、初心者にとってはWindowsよりmacOSの方が直感的で分かりやすい。

インターネットからダウンロードしてきたアプリを導入すると必ず表示される確認画面が表示されるので、「開く」をクリックしてLM Studioを立ち上げる。

LM Studioの初期設定を済ませよう

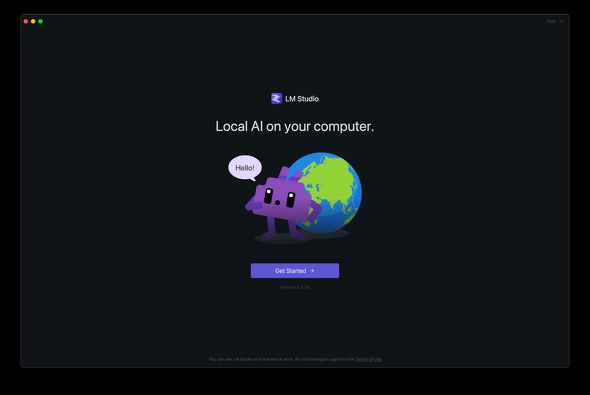

LM Studioの導入はこれで完了だが、これだけではgpt-oss-20bを利用できないため、初期設定の手順を引き続き詳しく見ていこう。

LM Studioを立ち上げると初期設定画面が表示されるので、「Get Started」ボタンをクリックして初期設定を進めよう。

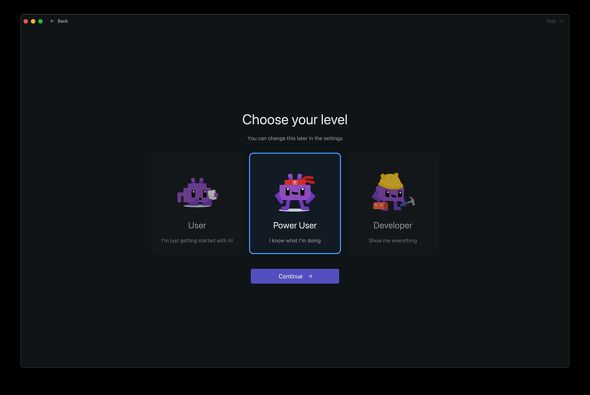

続いて「Choose your level(熟練度)」を選択する画面が表示される。これは、LM Studioのユーザーインタフェースの複雑さを指定するもので、Userはどちらかというと初心者向けの構成となる。

前回で触れた通り、MCP Serverの導入や、モデル読み込み時のパラメータ設定が必要になることもあるため、ここでは「Power User」を選択して「Continue」をクリックすることをオススメする。

すると、gpt-oss-20bが初めて使うオススメモデルとして表示されるので、この段階で「Download gpt-oss-20b」をクリックしてモデルのインストールを済ませてしまおう。

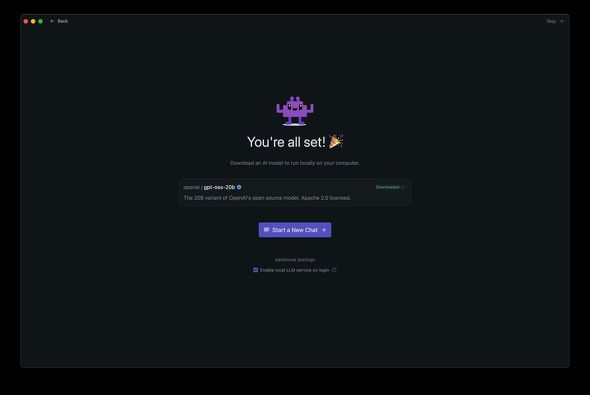

「You’re all set!(準備完了)」と表示されれば、これでLM Studioの初期設定は完了だ。早速「Start a New Chat」をクリックしてgpt-oss-20bを使ってみよう。

Copyright © ITmedia, Inc. All Rights Reserved.

関連記事

テキストだけじゃない? 画像データも理解できる「VLM」(視覚言語モデル)を導入する方法

テキストだけじゃない? 画像データも理解できる「VLM」(視覚言語モデル)を導入する方法

本連載ではローカルLLMの導入方法から活用方法に至るまで、「手元にハイエンドPCがあって、生成AIをローカル環境で動かしてみたい」という初心者の方にも分かりやすく連載で解説する。 「gpt-oss」はチャット機能以外にも活用方法がたくさん? 最新のWeb情報を利用するやり方も伝授

「gpt-oss」はチャット機能以外にも活用方法がたくさん? 最新のWeb情報を利用するやり方も伝授

本連載ではローカルLLMの導入方法から活用方法に至るまで、「手元にハイエンドPCがあって、生成AIをローカル環境で動かしてみたい」という初心者の方にも分かりやすく連載で解説する。 手元にあるゲーミングPCを活用して生成AIを動かす! 無料で使える「LM Studio」のキホンを解説

手元にあるゲーミングPCを活用して生成AIを動かす! 無料で使える「LM Studio」のキホンを解説

本連載ではローカルLLMの導入方法から活用方法に至るまで、「手元にハイエンドPCがあって、生成AIをローカル環境で動かしてみたい」という初心者の方にも分かりやすく連載で解説する。 手元にゲーミングPCがあれば、オフライン環境でも生成AIが利用できるってホント? ローカルLLM(大規模言語モデル)導入を解説

手元にゲーミングPCがあれば、オフライン環境でも生成AIが利用できるってホント? ローカルLLM(大規模言語モデル)導入を解説

本連載ではローカルLLMの導入方法から活用方法に至るまで、「手元にハイエンドPCがあって、生成AIをローカル環境で動かしてみたい」という初心者の方にも分かりやすく連載で解説する。 米AMD、RyzenやRadeonで生成AIをローカル実行するハウツーガイドを公開

米AMD、RyzenやRadeonで生成AIをローカル実行するハウツーガイドを公開

GPTベースのLLM(大規模言語モデル)を使ったAIチャットbotの実行、LLMをローカルでカスタマイズできる検索拡張生成(RAG)の導入、プログラミングにおけるコーディングアシスタントの実行という3つの手順を紹介している。 NVIDIAがPC上のデータを使うAIチャットbotツール「Chat with RTX」公開/AMD製CPUに複数の脆弱性

NVIDIAがPC上のデータを使うAIチャットbotツール「Chat with RTX」公開/AMD製CPUに複数の脆弱性

うっかり見逃していたけれど、ちょっと気になる――そんなニュースを週末に“一気読み”する連載。今回は、2月11日週を中心に公開された主なニュースを一気にチェックしましょう!