生成AIが世界を変える理由 トレンドから「ものすごい能力のNVIDIA製GPU」まで 知っておきたい基礎知識

米NVIDIAの株価が上昇し、時価総額が世界1位になった――こんなニュースが2024年6月に世界を駆け巡った。生成AIブームによる半導体需要の高まりを受けて、同社の株価は上場から四半世紀で約3400倍に膨れ上がっている。

生成AIを開発するには高性能のGPUが大量に必要なことから、生成AI領域のプレイヤーは大手IT企業が中心だった。しかし、オープンソースの大規模言語モデル(LLM)などが多数登場したことで大手以外の企業でも生成AIをビジネスに利用しやすくなると語るのは、東京大学 松尾研究室出身のAI研究者、今井翔太氏だ。

企業は生成AIをどのように使えばいいのか。今井氏とエヌビディア、NVIDIAのGPUを搭載したサーバを生産する米Supermicro日本法人のキーパーソンが登壇したセミナー「AI革命を加速するプラットフォーム戦略」(2024年7月、主催:SB C&S)から、生成AIの現在地と導入方法を解き明かす。

「生成AIは再現性が高い」 “世界を変える”チャンスがそこに

「生成AIは著しく進化しています。直近1年間だけでも、革命的な技術やサービスが数週間、数日ごとに発表され続けました。他の工学分野でこうした状況が起こるとは到底考えられません」(今井氏)

対話型生成AIの性能ランキング「LMSYS Chatbot Arena Leaderboard」のトップが激しく入れ替わっている状況が、生成AIの進化の速さを物語っている。対話を重ねるマルチターン部門のトップは2024年6月後半まで米OpenAIの「GPT-4o」だった。7月中旬には米Anthropicの「Claude 3.5 Sonnet」が1位に躍り出た。米Googleの「Gemini Advanced」も上位を追っている。

LLMのトレンドの一つが「マルチモーダル」だ。テキストによる対話だけでなく音声や画像、動画の入出力にも対応するようになり、音声生成や画像生成に特化したAIよりも高い性能を示すケースもあると今井氏は説明する。

今井氏が注目するもう一つのトレンドが「小規模LLM」だ。小規模言語モデル(SLM)と呼ばれることが多い。一般的なLLMのパラメーター数は数百億〜数千億に上るといわれ、推論には高性能なコンピューティングリソースや大量の電力が必要だ。技術革新によってSLMのような数十億パラメーターの小さなモデルでも高い性能を発揮できるようになったことで、スマートフォンやPCなどのエッジ端末でも生成AIを実行できる可能性が出てきた。すでに米Microsoftは同社のSLM「Phi-3」を、次世代のWindows PC「Copilot+ PC」に搭載すると発表した。

今井氏は「生成AIは魔法ではなく、再現性が高い技術」という元OpenAIの研究者の言葉を引用しながら「データとハードウェアを準備できれば誰でもスタート地点に立てます。大手IT企業の独自モデルとオープンソースのモデルの差は限りなく小さくなるでしょう。いま頑張ればどの企業にも世界を変えるチャンスがあります」とエールを送った。

生成AIの“民主化”が進む オンプレでも導入しやすく

企業の間で、生成AI導入の機運が高まっている。ITベンダーの一次代理店として“ITの流通”を手掛けるSB C&Sの榊原衛氏は、2024年1〜3月にChatGPTの導入状況などを調査したところ「すでに導入済み」「導入を検討中」という回答が全体の60%以上に達していたと紹介する。全体の約23%は自社用にカスタマイズしたChatGPTを導入済みか導入を検討していて、全体の約17%は自社専用のChatGPT基盤を導入済みあるいは検討中だった。

生成AI導入の選択肢の一つがオンプレミスだ。情報セキュリティやデータ保護、社内の人材育成などの点に強みがある。クラウドを使う場合は大量のデータを送る必要があるので移動コストが発生する。人間の活動で生まれるデータの近くに計算リソースを置くことで、移動コストや処理の遅延を低減できるとSB C&Sの幸田章氏は解説する。

生成AIが登場した当初は、GPUなどのハードウェアや基盤モデルの情報やノウハウの乏しさがオンプレミスに導入する際の課題になっていた。しかし現在は状況が好転している。基盤モデルと業務アプリケーションをAPIで連携させる方法が整ってきた。複数のAIモデルやソフトウェアを組み合わせる手間を省けるワンパッケージ化や、AIベンダーによる検証や互換性の認証、レファレンス資料の公開などが進んでいる。

NVIDIAの“スーパーチップ”と「ものすごい能力」のGPU

生成AIをオンプレミスに導入するためのキーアイテムがGPUだ。NVIDIAは主力GPUの「NVIDIA A100 Tensor コア GPU」(A100)、「NVIDIA H100 Tensor コア GPU」(H100)などでAI市場をけん引している。エヌビディアの川井源氏は、生成AIの進化スピードに対応するためにデータセンター向けGPU製品の市場投入ペースを上げていると話す。

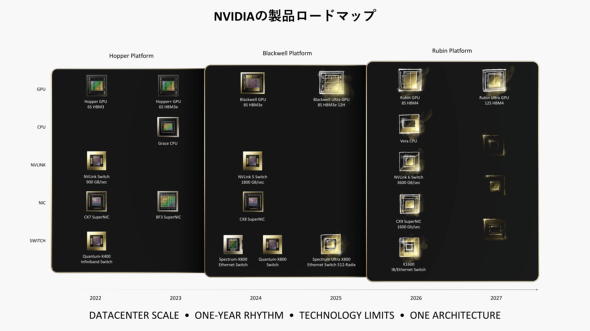

同社GPUのアーキテクチャはA100に採用されている「NVIDIA Ampere」、H100に使われている「NVIDIA Hopper」の順で性能が向上している。2024年後半にHopperの後継である「NVIDIA Blackwell」をローンチし、2025年にBlackwellのアーキテクチャを採用したアップグレードバージョン「Blackwell Ultra」を展開。2026年に次世代アーキテクチャ「NVIDIA Rubin」を投入する予定だ。

NVIDIAの注目製品として川井氏が紹介するのが、2023年に発表した「NVIDIA GH200 Grace Hopper Superchip」(GH200)だ。生成AI向けの“スーパーチップ”と銘打ち、GPUにHopper、CPUに同社が開発したARMベースのCPU「NVIDIA Grace」を搭載。両者を一体化したアーキテクチャになっている。CPUとGPU間の通信にNVIDIA独自のインターコネクトテクノロジー「NVLink-C2C」を採用することでCPUとGPU間の通信の高速化を図り、ワークロードによってはH100とX86ベースのCPUを組み合せたシステムと比べて最大8倍の処理能力を発揮するという。電力効率の高さもポイントで、1ワット当たりのパフォーマンスが現行モデルの最大2倍になるケースもあると川井氏は説明する。

NVIDIA GH200 Grace Hopper Superchipを搭載したSupermicroのサーバ。ヒートシンクに覆われている部分に、GPUとCPUが設置されている。(写真右側の資料のイメージ)

NVIDIA GH200 Grace Hopper Superchipを搭載したSupermicroのサーバ。ヒートシンクに覆われている部分に、GPUとCPUが設置されている。(写真右側の資料のイメージ)川井氏が「ものすごい能力を持った巨大なチップ」と説明するのが、2024年後半に登場するNVIDIA Blackwellだ。1兆パラメーターもの大規模な生成AIに対応できるGPUアーキテクチャになっている。主な生成AIが数百億〜数千億パラメーターであることを考えると、桁違いの能力を持つ生成AIになることは容易に想像できる。現在の製造方法では単一のチップとして作れないので、2つのGPUを組み合わせて作るという。

同じGPUなのに処理性能がアップした理由

NVIDIAは「GPUの会社」というイメージが強いが、AI向けのミドルウェアやソフトウェアライブラリ、HPC、ネットワーク機器など、AIシステムを構築するためのコンポーネントをフルスタックで取りそろえている。GPUの性能を最大限に引き出すためのソフトウェアに力を入れていて、従業員の約半数はソフトウェアの開発に従事していると川井氏は明かす。

GPUなどのハードウェアは導入時点からそれ以上は性能が向上しないと思われがちだが、NVIDIAはソフトウェアのアップデートを通じてGPUが持つ力を生かそうとしている。例えば、ハードウェア的に全く同じH100クラスタを使った生成AIのベンチマークテストで2023年と2024年の学習性能を比較すると、最新版のソフトウェアを使用することで「GPT-3」の学習性能は約27%、「Stable Diffusion v2」の学習性能は約80%も向上した。

さらにNVIDIAの知見を結集して、企業がAIをこれまでよりも容易に利用できる基盤「NVIDIA AI Enterprise」を提供している。事前検証済みのハードウェアやソフトウェア、学習モデルを組み合わせたプラットフォームだ。NVIDIA AI Enterpriseで使えるAIアプリケーションの開発やデプロイを支えるマイクロサービス「NVIDIA NIM」やクラウドネイティブな開発フレームワーク「NVIDIA NeMo」を通じて開発期間を抜本的に短縮できる。

株価上昇率は約1000% 躍進するサーバベンダー

NVIDIAのGPUを搭載したサーバを販売するSupermicroも生成AIで躍進している企業だ。奇遇にもNVIDIAと同じ1993年に米国カリフォルニア州サンノゼ市で創業。サーバやストレージ、ネットワーク機器などのデータセンター向け製品を多く手掛けており、株価の上昇率は2023年から2024年にかけて約1000%に上る。国内でもサーバの出荷台数で高いシェアを誇っている。

スーパーマイクロの佐野晶氏は、最新技術をハードウェア製品に取り込むための研究開発力の高さと速さが同社の強みだと胸を張る。

「生成AI用の製品は、ハードウェアの性能だけではなくネットワークを含めた包括的な組み合わせによって処理能力を最大限に高められます。当社はその点に重点的に取り組み、特にハイエンド領域でユーザーの支持を獲得しています」

同社はNVIDIAのスーパーチップであるGH200に対応したサーバを2023年10月から出荷している。将来のAI技術に対応できるサーバとして排熱や電力効率などの課題に対処する設計になっている。NVIDIA Blackwellが発売されたら即座に組み込んで出荷できる体制を整えていると佐野氏は強調する。

AI向けサーバの“敵”を倒す方法

活況を呈するAI向けサーバ市場が直面している課題が「熱」だ。CPUやGPUの性能向上に伴ってシステム全体の消費電力と発熱量が右肩上がりで増加している。膨大な計算処理を行うAI領域で、この傾向が顕著に表れている。発熱量が増えれば冷却のための電力消費も増す。データセンターの電源が不足したり環境保護の観点から批判されたりしかねない。

「サーバの熱問題を解決する冷却方式が『水冷』です。熱伝導率は空冷の約60倍で、効率的に冷却できます。水を循環させる仕組みなので、消費電力も空冷より抑えられます」(佐野氏)

水冷方式は幾つか方法があり、Supermicroは「Direct-To-Chip Liquid Cooling」(DLC)方式を採用している。ヒートシンクの代わりになるコールドプレートがGPUやCPUに直接触れることで冷却して、熱くなった水をクーリングタワーに運んで冷却して循環させる方法だ。DLC方式を使ったSupermicroの水冷ソリューションは、台湾で2024年6月に開催されたコンピュータの見本市「Computex」でベストアワードを受賞している。

NVIDIA Blackwellを搭載する予定のサーバは、1筐体に8枚のGPUを搭載する空冷式の「X14 10U HGX B200 8GPU搭載 SYS-A22GA」だけでなく、水冷式の「X14 4U HGX B200 8GPU搭載 SYS-422GA-NBRT-LCC」を用意する。GPUの性能を引き出すべく、CPUに「インテル Xeon 6 プロセッサー 6900 シリーズ」を搭載するとスーパーマイクロの本間延孝氏は説明する。

水冷式はサーバの小型化にも貢献する。前述したNVIDIA BlackwellのGPUを8枚搭載するサーバのサイズは、空冷式が10Uなのに対して水冷式はわずか4Uだ。水冷式なら、単純計算で同一のスペースに空冷式の2倍以上のGPUサーバを設置できる。

佐野氏は「生成AIをはじめHPCや機械学習などの“超高速コンピューティング”へのシフトが始まっていて、パワフルなGPUをベースにしたサーバが求められています。市場のニーズに対して、ネットワーク製品や冷却技術などを生かして今後も企業を支援し続けます」と結んだ。

Copyright © ITmedia, Inc. All Rights Reserved.

提供:スーパーマイクロ株式会社、エヌビディア合同会社、SB C&S株式会社

アイティメディア営業企画/制作:ITmedia AI+編集部/掲載内容有効期限:2024年9月15日

AI研究者の今井翔太氏

AI研究者の今井翔太氏 SB C&Sの榊原衛氏(ICT事業本部 システム基盤推進本部 AIインフラ推進統括部 統括部長)

SB C&Sの榊原衛氏(ICT事業本部 システム基盤推進本部 AIインフラ推進統括部 統括部長) SB C&Sの幸田章氏(ICT事業本部 技術本部 技術統括部 第1技術部 2課)

SB C&Sの幸田章氏(ICT事業本部 技術本部 技術統括部 第1技術部 2課) エヌビディアの川井源氏(エンタープライズ事業本部 シニアマネジャー データセンターGPUビジネス推進)

エヌビディアの川井源氏(エンタープライズ事業本部 シニアマネジャー データセンターGPUビジネス推進)

スーパーマイクロの佐野晶氏(ゼネラルマネージャー FAE&ビジネスデベロップメント)

スーパーマイクロの佐野晶氏(ゼネラルマネージャー FAE&ビジネスデベロップメント) スーパーマイクロの本間延孝氏(プリンシパルFAE)

スーパーマイクロの本間延孝氏(プリンシパルFAE)