大学の試験を生成AIで回答してもばれなかった…… しかも高得点 英国の大学でこっそり検証:Innovative Tech(AI+)

英レディング大学などに所属する研究者らは、大学の試験において生成AIで回答した答案がバレるかを抜き打ちで実施した現実世界のチューリングテストの研究報告を発表した。

Innovative Tech(AI+):

このコーナーでは、2014年から先端テクノロジーの研究を論文単位で記事にしているWebメディア「Seamless」(シームレス)を主宰する山下裕毅氏が執筆。新規性の高いAI分野の科学論文を山下氏がピックアップし、解説する。

X: @shiropen2

英レディング大学などに所属する研究者らが発表した論文「A real-world test of artificial intelligence infiltration of a university examinations system: A “Turing Test” case study」は、大学の試験において生成AIで回答した答案がバレるかを抜き打ちで実施した現実世界のチューリングテストの研究報告である。

研究チームは、英レディング大学の心理学の学士課程5科目の試験に対し、GPT-4を使用して63の回答を作成した。これらの回答は実際の学生の回答と共に提出され、平均して採点された全回答の約5%を占めた。採点者には、33人の架空の学生(その名前もGPT-4が生成)の回答を採点していることは知らされなかった。

学生はこれらの試験を自宅で受けたため、メモや参考文献を見ることが許可されており、許可されていなかったもののAIを使用することもできた。

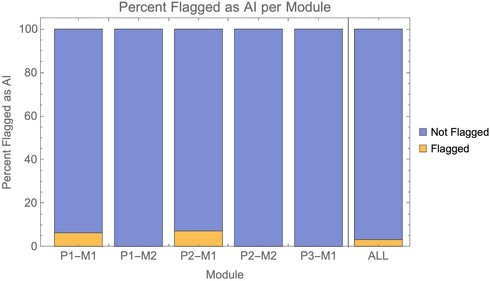

評価には短答式と長文エッセイの2種類の問題が含まれていた。全科目を通じて、AI生成の回答のうち学生自身の回答でない可能性があるとして指摘されたのはわずか6%であった。つまり、GPT-4を使用して作成された大学の試験回答の94%がAI生成だとは検出されなかった。

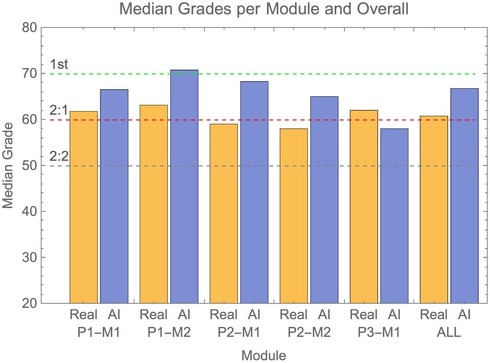

研究チームによると、平均してAI回答は実際の学生の回答よりも高い成績を獲得した。ただし、科目によって多少のばらつきがあった。63のAI回答全体では、AI回答が学生の回答を上回る確率は83.4%であった。

この結果は、生成AIが単純で制約のあるテキスト質問に対して、もっともらしい回答を生成できることを示している。また、監督なしの評価、特に短答式の問題は常に不正行為の影響を受けやすいことも指摘している。

採点者の負担も、AI生成の回答を見抜く能力に影響を与えている可能性がある。時間的制約のある採点者が、軽々しくAIの不正使用を指摘することは難しい。この問題は、他の教育機関でも起こっている可能性が高いと推測される。

Source and Image Credits: Scarfe P, Watcham K, Clarke A, Roesch E (2024)A real-world test of artificial intelligence infiltration of a university examinations system: A “Turing Test” case study. PLOS ONE 19(6): e0305354. https://doi.org/10.1371/journal.pone.0305354

Copyright © ITmedia, Inc. All Rights Reserved.

関連記事

「もうAIって人間と区別つかないよね……」 米研究者らがGPT-4などでチューリングテスト 結果は?

「もうAIって人間と区別つかないよね……」 米研究者らがGPT-4などでチューリングテスト 結果は?

米カリフォルニア大学サンディエゴ校に所属する研究者らは、AIが人間と区別がつかないレベルに達しているかどうかを調べるために、チューリングテストを実施した研究報告を発表した。 AI「はっきりしませんが……」 “自信がないAI”に人はどう反応する? 米Microsoftらが400人以上で実験

AI「はっきりしませんが……」 “自信がないAI”に人はどう反応する? 米Microsoftらが400人以上で実験

米プリンストン大学とカナダと米国のMicrosoftに所属する研究者らは、自信がない回答をする大規模言語モデル(LLM)に対して人々はどう反応するかを調査した研究報告を発表した。 LLMが別のLLMを何度も改善 より良い回答を出す最適化手法をAIが発見する技術 Sakana AIなどが開発

LLMが別のLLMを何度も改善 より良い回答を出す最適化手法をAIが発見する技術 Sakana AIなどが開発

AIベンチャーのSakana AIやFLAIR、英ケンブリッジ大学、オックスフォード大学に所属する研究者らは、人間の介入を最小限に抑えて新しい最適化アルゴリズムをAIによって発見する手法を提案した研究報告を発表した。 ChatGPT vs. Wikipedia──生成AIの登場でウィキペディアはどう変わったか? 英国の研究者らが調査

ChatGPT vs. Wikipedia──生成AIの登場でウィキペディアはどう変わったか? 英国の研究者らが調査

英キングス・カレッジ・ロンドンに所属する研究者らは、2022年11月にChatGPTが一般公開されたことを受け、Wikipediaの利用状況にどのような変化が生じたのかを調査した研究報告を発表した。 陰謀論者 vs. 生成AI──大規模言語モデルは陰謀論を説得できるか? 米MITなどが2000人以上で検証

陰謀論者 vs. 生成AI──大規模言語モデルは陰謀論を説得できるか? 米MITなどが2000人以上で検証

米MITや米コーネル大学に所属する研究者らは、大規模言語モデル(LLM)を用い、陰謀論者の考えを説得できるかを検証した研究報告を発表した。