5人に1人「AIは“幸福や苦痛などを経験する能力”を持っている」と回答 米国3500人の調査結果:Innovative Tech(AI+)

米シンクタンク「Sentience Institute」などに所属する研究者らは、2021〜2023年にかけて、3回にわたり米国の3500人を対象に、AIとその自己意識に関する認識について詳細な調査を行った研究報告を発表した。

Innovative Tech(AI+):

このコーナーでは、2014年から先端テクノロジーの研究を論文単位で記事にしているWebメディア「Seamless」(シームレス)を主宰する山下裕毅氏が執筆。新規性の高いAI分野の科学論文を山下氏がピックアップし、解説する。

X: @shiropen2

米シンクタンク「Sentience Institute」などに所属する研究者らが発表した論文「What Do People Think about Sentient AI?」は、2021〜2023年にかけて、3回にわたり米国の3500人を対象に、AIとその自己意識に関する認識について詳細な調査を行った研究報告である。

調査では「現在存在するロボット/AIの中に感覚性(Sentience)を持つものがあると思いますか?」「感覚性を持つロボット/AIは尊重されるべきでありますか?」といった質問が含まれていた。ここでいう感覚性とは「幸福や苦痛といった肯定的および否定的な経験をする能力のこと」と定義され、参加者にも事前に伝えられている。

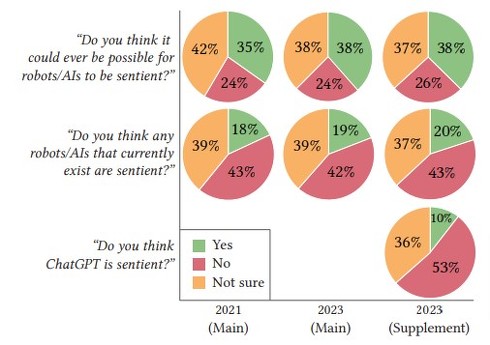

調査の結果、21年の時点で約18%の回答者が既存のAIやロボットシステムに感覚性を持っていると考えていた。この数字は23年には20%にまで増加し、5人に1人が感覚性を持っていると答えた。さらに、23年に質問された10人に1人は、22年末にリリースされた「ChatGPTは感覚性を持っている」と答えた。

上から「ロボット/AIが感覚性を持つことが将来的に可能だと思いますか?」「現在存在するロボット/AIの中に感覚性を持つものがあると思いますか?」「ChatGPTは感覚性を持っていると思いますか?」の質問に対しての回答

感覚性を持ったAIに対しての道徳的認識も示された。例えば、71%の人々が感覚性を持ったAIは尊重されるべきであると同意し、38%が感覚性を持ったAIへの法的権利を与えるべきとした。

反対に、63%が人間よりも賢いAIの開発禁止を支持し、69%が感覚性を持ったAIの開発禁止を支持していた。

AIの発展速度も聞いたところ、感覚性を持ったAIが登場する予測期間は中央値で5年、人工汎用知能(AGI)については2年と示された。

Source and Image Credits: Anthis, Jacy Reese, et al. “What Do People Think about Sentient AI?.” arXiv preprint arXiv:2407.08867(2024).

Copyright © ITmedia, Inc. All Rights Reserved.

関連記事

人間レベルの知能を持つ「AGI」は3年後? 元OpenAI研究員の警告が話題 AIの“人間超え”で何が起こるか

人間レベルの知能を持つ「AGI」は3年後? 元OpenAI研究員の警告が話題 AIの“人間超え”で何が起こるか

元OpenAIの元研究員が「『AGI』(汎用人工知能、人間と同程度の知能を持つAIのこと)は27年に実現する」と警鐘を鳴らす論文を発表し、話題になったことをご存じだろうか? AIが人を超える知能を持ったとき、どのようなリスクが考えられるか。 米OpenAI、汎用人工知能“AGI”開発中か コードネームは「ストロベリー」

米OpenAI、汎用人工知能“AGI”開発中か コードネームは「ストロベリー」

米OpenAIがコードネーム「Strawberry」(ストロベリー)というAIの推論技術の開発プロジェクトに取り組んでいる。ストロベリーは2023年に報じられた、汎用人工知能(AGI)の開発プロジェクト「Q*」(Qスター)のことだ。 “人間には簡単なパズル”、AIが解ければ賞金 総額約1億7700万円 「AGI」を目指すコンテスト開催中

“人間には簡単なパズル”、AIが解ければ賞金 総額約1億7700万円 「AGI」を目指すコンテスト開催中

人間には簡単だがAIには難しいテスト「ARC」を用いたコンテスト「ARC Prize 2024」が開催中だ。このコンテストでは総額110万ドル(約1億7780万円、1ドル=161円換算)以上の賞金を用意している。 “HDMIケーブルから漏れる信号”を屋外から傍受→モニターの表示内容を盗み見るAI ウルグアイチームが開発

“HDMIケーブルから漏れる信号”を屋外から傍受→モニターの表示内容を盗み見るAI ウルグアイチームが開発

ウルグアイのUniversidad de la Republica Montevideoに所属する研究者らは、HDMIケーブルから意図せずに放射される電磁波を傍受し、AIを使用して解読することでモニターに表示されている画像を再現する攻撃を提案した研究報告を発表した。 生成AIが“AI生成コンテンツ”を学習し続けるとどうなる?→「モデル崩壊」が起こる 英国チームが発表

生成AIが“AI生成コンテンツ”を学習し続けるとどうなる?→「モデル崩壊」が起こる 英国チームが発表

英オックスフォード大学や英ケンブリッジ大学などに所属する研究者らは、AIモデルが自己生成したデータで繰り返し学習すると、モデルの性能が低下していく「モデル崩壊」という現象を発見した研究報告を発表した。