中国テンセント、3890億パラメータのオープンソース大規模言語モデル「Hunyuan-Large」発表:Innovative Tech(AI+)

中国Tencentに所属する研究者らは、TransformerベースのMixture of Experts(MoE)モデルであるオープンソース大規模言語モデル(LLM)を提案した研究報告を発表した。

Innovative Tech(AI+):

このコーナーでは、2014年から先端テクノロジーの研究を論文単位で記事にしているWebメディア「Seamless」(シームレス)を主宰する山下裕毅氏が執筆。新規性の高いAI分野の科学論文を山下氏がピックアップし、解説する。

X: @shiropen2

中国Tencentに所属する研究者らが発表した論文「Hunyuan-Large: An Open-Source MoE Model with 52 Billion Activated Parameters by Tencent」は、TransformerベースのMixture of Experts(MoE)モデルであるオープンソース大規模言語モデル(LLM)を提案した研究報告である。

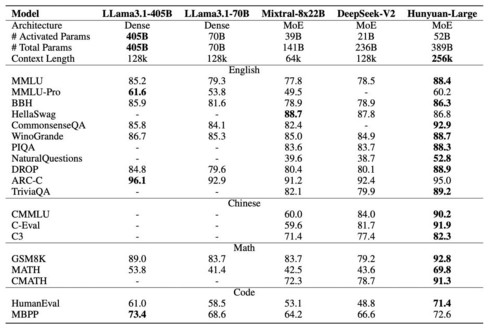

このモデル(Hunyuan-A52B)は総パラメータ数3890億、実際に活性化されるパラメータ数520億という規模を持ち、一度に25万6000トークンまでの処理が可能である。従来のモデルと比較して、より少ない計算リソースで優れた性能を実現している。

特筆すべき技術的特徴として、7兆トークンという大規模なデータでの学習を実施し、そのうち1.5兆トークンは高品質な合成データを使用している。合成データの質を確保するため、指示生成や指示の進化、応答生成、応答のフィルタリングという4段階のプロセスを採用した。

モデル構造では、全てのトークンで使う1つの共有専門家と、特定のタスクに特化した16の専門家を組み合わせた戦略を導入している。また、メモリ使用量を削減する圧縮技術や、専門家ごとに最適化された学習率の設定など、効率的な学習方法を実装している。

事後学習段階では、教師あり微調整と人間フィードバックによる強化学習を実施。特に、数学やコーディング、論理的推論、知識ベースの質問応答、エージェントアクション、テキスト生成などの能力向上に焦点を当てている。

評価実験では、英語と中国語の両方で、常識理解や質問応答、数学的推論、コーディング、長文脈処理など、さまざまなベンチマークで既存のオープンソースモデルを上回る性能を達成した。特に、数学データセットのMATHでは69.8%、コーディングデータセットのHumanEvalでは71.4%という高いスコアを記録している。この結果は、Llama 3.1-405B、Mistral-8x22B 、DeepSeek-V2などを上回る。

Source and Image Credits: Sun, Xingwu, et al. “Hunyuan-Large: An Open-Source MoE Model with 52 Billion Activated Parameters by Tencent.” arXiv preprint arXiv:2411.02265(2024).

Copyright © ITmedia, Inc. All Rights Reserved.

関連記事

画像生成AI vs. イラストレーター 生成時に“二酸化炭素”を多く排出するのはどっち? 米国チームが検証 「最大2900倍もの差」

画像生成AI vs. イラストレーター 生成時に“二酸化炭素”を多く排出するのはどっち? 米国チームが検証 「最大2900倍もの差」

米カリフォルニア大学アーバイン校などに所属する研究者らは2月、文章作成やイラスト制作においてAIシステムと人間、二酸化炭素の排出量が多いのはどちらか比較した研究報告を発表した。 富士通、大規模言語モデル「Takane」提供開始 「世界一の日本語性能を持つ」とうたう

富士通、大規模言語モデル「Takane」提供開始 「世界一の日本語性能を持つ」とうたう

富士通は、カナダのAI開発企業Cohereと共同開発した大規模言語モデル(LLM)「Takane」の提供を始めた。同社はこのLLMについて「世界一の日本語性能を持つ」とうたっている。 科学研究をAIで全自動化──論文執筆や査読ができる「The AI Scientist」 Sakana AIが発表

科学研究をAIで全自動化──論文執筆や査読ができる「The AI Scientist」 Sakana AIが発表

AIモデルを使って、科学研究を自動化できないか?──AIベンチャーのSakana AIは、そんな需要に対応するAIシステム「The AI Scientist」を発表した。 「著作権トラップ」――生成AIに作品を“無断盗用”されたか後から証明する方法 英ICLなどが開発

「著作権トラップ」――生成AIに作品を“無断盗用”されたか後から証明する方法 英ICLなどが開発

英インペリアル・カレッジ・ロンドンなどに所属する研究者らは、大規模言語モデル(LLM)の訓練データに著作権所有者の作品が含まれているかを特定する方法を開発した研究報告を発表した。 生成AIが“AI生成コンテンツ”を学習し続けるとどうなる?→「モデル崩壊」が起こる 英国チームが発表

生成AIが“AI生成コンテンツ”を学習し続けるとどうなる?→「モデル崩壊」が起こる 英国チームが発表

英オックスフォード大学や英ケンブリッジ大学などに所属する研究者らは、AIモデルが自己生成したデータで繰り返し学習すると、モデルの性能が低下していく「モデル崩壊」という現象を発見した研究報告を発表した。