PFN、新LLM「PlaMo 2 8B」(仮称) 開発中 パラメータ数1000億→80億に、でも性能は維持

Preferred Networksの岡野原大輔代表取締役が、開発中の新しい大規模言語モデル「PlaMo 2 8B」(仮称)について明らかにした。同社の既存モデル「PLaMo-100B」の性能を維持しつつ、パラメータ数を約12分の1に削減したという。

Preferred Networksの岡野原大輔代表取締役は2月18日、開発中の新しい大規模言語モデル「PlaMo 2 8B」(仮称)について明らかにした。同社の既存モデル「PLaMo-100B」の性能を維持しつつ、パラメータ数を約12分の1に削減したという。アイティメディアが同日から開催しているオンラインイベント「ITmedia AI Boost」で言及した。

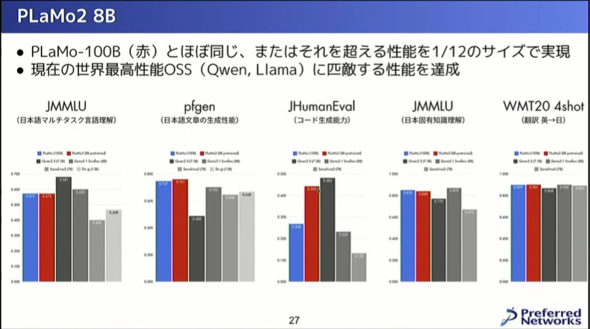

新しく開発したPlaMo 2 8Bはパラメータ数を80億(PLaMo-100Bは1000億)まで抑えつつ、PLaMo-100Bと同等以上の性能を実現したとうたう。日本語や日本固有の知識の理解について問う「JMMLU」やコード生成能力を問う「JHumanEval」などのベンチマークで、PLaMo-100Bと同等あるいはそれ以上のスコアを記録したという。なお、まだ事後学習が済んでいないため、コーディング能力は今後上昇する可能性があるとしている。

PLaMo-100Bは同社が2024年に発表したモデル。日本語性能を評価するベンチマーク「Jaster2 0shot」で、GPT-4oやClaude 3.5 Sonnet、Llama-3 70Bを上回るスコアを記録したという。

【修正:2025年2月19日午前10時 当初、PLaMo-100Bのパラメータを1兆としていましたが、正しくは1000億でした。訂正しておわびします。】

Copyright © ITmedia, Inc. All Rights Reserved.

関連記事

GPT-4を超える日本語性能のLLM、PFN子会社がフルスクラッチで開発 無料トライアルを開始

GPT-4を超える日本語性能のLLM、PFN子会社がフルスクラッチで開発 無料トライアルを開始

AIスタートアップ・Preferred Networks(PFN)の子会社であるPreferred Elementsは8月7日、大規模言語モデル「PLaMo β版」の無料トライアルの申し込み受付を始めたと発表した。 PFNから金融特化LLM「PLaMo-fin-base」登場 AIエージェントに活用で金融機関の業務効率化に貢献

PFNから金融特化LLM「PLaMo-fin-base」登場 AIエージェントに活用で金融機関の業務効率化に貢献

Preferred Networks(PFN)は、大規模言語モデル(LLM)「PLaMo」の金融に特化した派生AIモデル「PLaMo-fin-base」の提供を始めると発表した。 国産AIスタートアップ・PFNが“生成AI向けプロセッサ”独自開発、2026年提供へ 「GPUの10倍高速で省電力」

国産AIスタートアップ・PFNが“生成AI向けプロセッサ”独自開発、2026年提供へ 「GPUの10倍高速で省電力」

AIスタートアップ・Preferred Networksは、大規模言語モデルなどの生成AI向けプロセッサ「MN-Core L1000」の独自開発を始めると発表した。 “GPT-4超え性能”の日本語特化型LLM AIスタートアップ・ELYZAが開発 国外プレイヤーとの競争も「諦めない」

“GPT-4超え性能”の日本語特化型LLM AIスタートアップ・ELYZAが開発 国外プレイヤーとの競争も「諦めない」

東大発のAIスタートアップ企業であるELYZAは、GPT-4を超える性能を持つ日本語特化型の大規模言語モデル(LLM)「Llama-3-ELYZA-JP-70B」を開発したと発表した。 1000億パラメータのLLM、AIスタートアップが公開 フルスクラッチで開発 「ハルシネーションを大幅抑止」

1000億パラメータのLLM、AIスタートアップが公開 フルスクラッチで開発 「ハルシネーションを大幅抑止」

AIスタートアップ企業のストックマークは、1000億パラメータ規模の大規模言語モデルを開発したと発表した。同社がフルスクラッチで開発したものでハルシネーションを大幅抑止しているのが特徴という。