中国発、オープンなAIモデル「Kimi K2」登場 「GPT-4.1」など上回る性能うたう パラメータ数は“1兆”

中国のAI開発企業であるMoonshot AIは、オープンな大規模言語モデル(LLM)「Kimi K2」を発表した。

中国のAI開発企業であるMoonshot AIは7月11日(現地時間)、オープンな大規模言語モデル(LLM)「Kimi K2」を発表した。総パラメータ数は1兆に達し、一部のベンチマークでは、米OpenAIのAIモデル「GPT-4.1」などを上回る性能を見せたという。

Kimi K2では、複数のサブモデルを組み合わせ、タスクに応じて使う領域を選んで計算効率を高める技術「Mixture of Experts」(MoE)を採用した。全体で1兆パラメータを持ち、1回の入力に対しては320億パラメータがアクティブになる。なお同モデルは、思考のプロセスを明示的に扱ってタスクを解くリーズニングモデルではない。

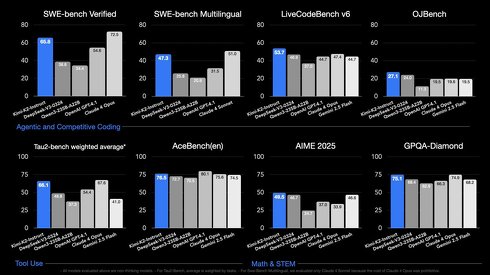

コーディングや数学の問題を解く能力を測る複数のベンチマークでは、GPT-4.1に加え、米Googleの「Gemini 2.5 Flash」や米Anthropicの「Claude Opus 4」などと同等、または上回る性能を示したという。例えば、コーディング性能を測るベンチマークの1つである「LiveCodeBench v6」では、GPT-4.1とGemini 2.5 Flashが44.7ポイント、Claude Opus 4が47.4ポイントだったのに対し、Kimi K2は53.7ポイントを獲得したとアピールしている。

Kimi K2の開発には、独自の最適化アルゴリズム「MuonClip」を導入した。Moonshot AIによると、最適化アルゴリズム「Muon」は、LLMの開発で広く使われている最適化アルゴリズム「AdamW」より高性能である一方、「exploding attention logits」(アテンションロジットの爆発)という現象のため、AdamWに比べて安定性に欠けるという。

そこで、クエリとキーを調整する「qk-clip」という手法でMuonを改良し、安定性を高めたMuonClipを開発。Muonによって学習したAIモデル「Moonlight」を、MuonClipによってスケールアップし、Kimi K2を開発したとしている。

他にも、合成データを含む数千のAIツールのデータによって学習。AIエージェントとして活用する際の最適化も図った。

Kimi K2は、基本モデル「Kimi-K2-Base」と、事後学習済みのモデル「Kimi-K2-Instruct」をGitHub上で公開している。商用利用も可能だが、月間アクティブユーザーが1億人以上、または月間収益が2000万ドル(29億円、1ドル145円換算、以下同)以上のサービスに利用する場合、UIに「Kimi K2」と表示する必要がある。

Webサイトからもアクセス可能。APIでの利用もでき、100万トークンあたり、入力で0.6ドル(87円)、出力で2.5ドル(362.5円)。

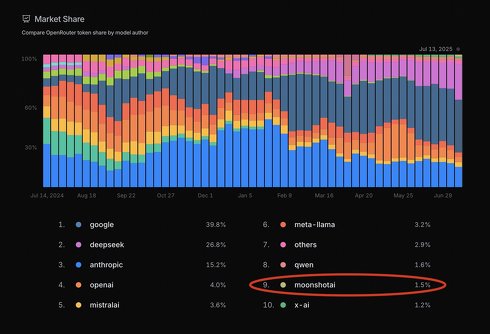

なお、複数のAIモデルに1つのAPIキーからアクセスできるプラットフォーム「OpenRouter」によると、Kimi K2の登場後13日時点で、同プラットフォームにおけるMoonshot AIのAIモデルのマーケットシェアが、AIモデル「Grok」を開発する米xAIを上回ったとしている。

Copyright © ITmedia, Inc. All Rights Reserved.

関連記事

AIの明日は「失望」or「希望」?──Appleとサム・アルトマンの“2つの未来予測” その意味を考える

AIの明日は「失望」or「希望」?──Appleとサム・アルトマンの“2つの未来予測” その意味を考える

6月、AIの未来に関する2つの予測がされた。米Appleの研究者らが執筆した論文と、米OpenAIのサム・アルトマンCEOのブログ記事だ。今回はこの2つの主張を取り上げ、その意義について考えてみたい。 中国発AI「DeepSeek-R1」がアップデート 長考での推論やコーディング性能向上か

中国発AI「DeepSeek-R1」がアップデート 長考での推論やコーディング性能向上か

AI開発企業の中国DeepSeekは、大規模言語モデル「DeepSeek-R1」のアップデート版を公開した。パラメータ数は6850億で、商用利用もできるMITライセンスの下で提供する。 第2のDeepSeekショック? オープンな中国LLM「Qwen3」シリーズが破格の性能で話題 最大モデルはOpenAI o1やGemini 2.5 Proに匹敵、たった4BでもGPT-4oレベルに

第2のDeepSeekショック? オープンな中国LLM「Qwen3」シリーズが破格の性能で話題 最大モデルはOpenAI o1やGemini 2.5 Proに匹敵、たった4BでもGPT-4oレベルに

Alibabaの最新LLM「Qwen3」シリーズが話題。フラグシップモデルはDeepSeek-R1やOpenAIの「o1」「o3-mini」、Google「Gemini 2.5 Pro」など他のトップクラスモデルと並ぶ性能の他、「Qwen3-4B」は非常に小さなモデルでありながらも「GPT-4o」を多くの項目で上回るとしている。全てのモデルがオープンウェイトなので完全ローカルで動作させることが可能。 「DeepSeek V3」に“改良版”がひっそり登場 「性能が大幅に向上」とXで話題に 応答速度も4倍速く?

「DeepSeek V3」に“改良版”がひっそり登場 「性能が大幅に向上」とXで話題に 応答速度も4倍速く?

中国AI企業のDeepSeekは、AIモデル「DeepSeek V3-0324」をHugging Faceで公開した。2024年12月にリリースしたAIモデル「DeepSeek V3」の改良版とみられる。 NVIDIA、GPUクラスタ最適化で「DeepSeek-R1のスループット30倍」 オープンソースで提供

NVIDIA、GPUクラスタ最適化で「DeepSeek-R1のスループット30倍」 オープンソースで提供

米NVIDIAはが、大規模言語モデル(LLM)の推論を最適化するオープンソースソフトウェア「NVIDIA Dynamo」を発表した。GPU群における処理の割り当てを最適化。計算を最小限に抑え、電力当たりの応答速度や処理能力を向上させるという。