米Google、AIと対話しながら“ストリートビュー”できる「StreetViewAI」開発 視覚障害者の外出支援に活用:Innovative Tech(AI+)

米Google Researchと米Google DeepMindの研究チームは、AIと対話しながらストリートビューで地球上を探索できる視覚障害者向けツールを開発した研究報告を発表した。

Innovative Tech(AI+):

このコーナーでは、2014年から先端テクノロジーの研究を論文単位で記事にしているWebメディア「Seamless」(シームレス)を主宰する山下裕毅氏が執筆。新規性の高いAI分野の科学論文を山下氏がピックアップし、解説する。

X: @shiropen2

米Google Researchと米Google DeepMindの研究チームが発表した論文「StreetViewAI: Making Street View Accessible Using Context-Aware Multimodal AI」は、AIと対話しながらストリートビューで地球上を探索できる視覚障害者向けツールを開発した研究報告だ。

Googleストリートビューのような没入型の街並みマッピングツールは、100カ国以上で2200億枚を超える360度画像を保有しているにもかかわらず、その視覚依存性の高さゆえに、これまで視覚障害者には閉ざされた世界であった。

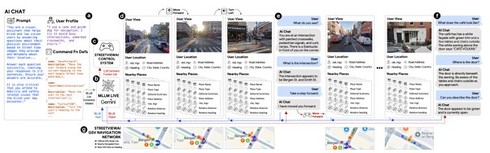

今回開発した「StreetViewAI」は、マルチモーダルAIモデルを活用することで、視覚障害者がバーチャルに街並みを探索できるようにしたシステムだ。利用者は矢印キーで45度ずつ視点を回転させ、前後に移動しながら、現在地、向いている方角、近隣の施設情報などを音声で確認できる。

システムでは、Google Gemini Flash 2.0モデルを基盤とした3つのAIサブシステムで、それぞれ「AI Describer」「AI Chat Agent」「AI Tour Guide」として機能する。AI Describerでは、視界の重要な物体、空間的関係、ナビゲーションの手掛かりなどを簡潔な音声説明として提供する。

AI Chat Agentとの対話機能により、利用者は現在見ている光景について自由に質問できる。「歩道は日陰になっているように見えますか」「コーヒーショップの入り口は車椅子でアクセス可能ですか」「このルート沿いに何か驚くようなものはありますか」といった具体的な情報を得ることが可能だ。

AIモデルは最大104万8576の入力トークンを保持し、過去の視点や会話履歴を考慮した文脈に即した応答を生成する。AI Tour Guideは、歴史的事実や文化的意義、建築様式など観光向けの情報を提供する役割を担う。

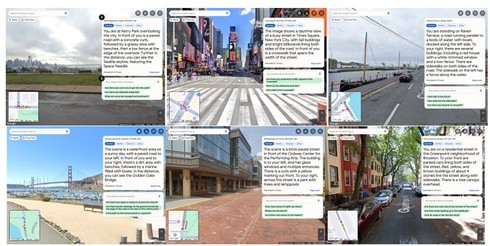

研究チームは11人の視覚障害者を対象に評価研究を実施。参加者全員が白杖を使用し、JAWSやVoiceOverなどのスクリーンリーダーを日常的に利用している。研究では、目的地調査タスクと自由探索タスクの2種類の課題を設定した。

前者では、バス停、遊び場、メキシコ料理レストランなどの特定の場所について調査し、後者では、ミネアポリスのアイスクリーム店やパリの日本料理店へのバーチャル的な経路探索を行った。

結果、参加者はAI Chat Agentを917回、AI Describerを136回使用し、インタラクティブな対話を好む傾向が見られた。816の質問のうち、86.3%が正確に回答され、誤答は3.9%にとどまった。質問内容を分析すると、最も多かったのは空間的な位置関係に関する質問(27.0%)で、次いで物体の存在確認(26.5%)、現在の視界の説明要求(18.4%)と続いた。

参加者の多くは音声入力を好み、AI Chatの94.4%以上が音声で行われた。参加者の一人は「これまでのナビゲーションシステムは目的地の5〜10フィート(約1.5〜3m)手前までしか案内してくれなかったが、このツールはドアまで導いてくれ、そのドアの様子まで説明してくれる」と評価した。

Source and Image Credits: Jon E. Froehlich, Alexander J. Fiannaca, Nimer M Jaber, Victor Tsaran, and Shaun K. Kane. 2025. StreetViewAI: Making Street View Accessible Using Context-Aware Multimodal AI. In Proceedings of the 38th Annual ACM Symposium on User Interface Software and Technology(UIST ’25). Association for Computing Machinery, New York, NY, USA, Article 43, 1-22. https://doi.org/10.1145/3746059.3747756

Copyright © ITmedia, Inc. All Rights Reserved.

関連記事

Google、「Nano Banana」(Gemini 2.5 Flash Image)を本番環境で提供開始

Google、「Nano Banana」(Gemini 2.5 Flash Image)を本番環境で提供開始

Googleは、画像生成AIモデル「Nano Banana」を一般公開し、開発者向けモデル「Gemini 2.5 Flash Image」を本番環境で利用可能にしたと発表した。このモデルは、既に50億件以上の作品を生み出しているという。開発者向けでは多様なアスペクト比に対応するなど、新機能も追加された。 Googleの「Gemini」に、ロボット向け新モデル 自律的にタスクを分解して動作、“雑な指示”にも対応

Googleの「Gemini」に、ロボット向け新モデル 自律的にタスクを分解して動作、“雑な指示”にも対応

米Googleは、ロボット向けのAIモデル「Gemini Robotics 1.5」と「Gemini Robotics-ER 1.5」を発表した。複雑な手順が必要なタスクに対し、自律的にタスクを分解してロボットを駆動できるという。 YouTube、Googleの動画生成AI「Veo 3」が使えるように スマホで「音声付きショート」を無料生成 米国などで

YouTube、Googleの動画生成AI「Veo 3」が使えるように スマホで「音声付きショート」を無料生成 米国などで

米Google傘下のYouTubeは、YouTubeにGoogleの動画生成AI「Veo 3 Fast」を導入したと発表した。スマートフォンから、音声付きのショート動画を無料で作成できるようになるという。米国やイギリス、カナダなどから展開を始める。日本への導入は未定。 米Google、“個別健康指導”を行うAIコーチ「PH-LLM」開発 スマートウォッチからデータ収集

米Google、“個別健康指導”を行うAIコーチ「PH-LLM」開発 スマートウォッチからデータ収集

米Google Researchに所属する研究チームは、ウェアラブルデバイスから収集した健康データを活用して、睡眠とフィットネスの個別指導を行う大規模言語モデル(LLM)を開発した研究報告を発表した。 AIで画像を“フィギュア化”する方法は? Google公式が紹介 一方“バンダイ風ロゴ”を問題視する声も

AIで画像を“フィギュア化”する方法は? Google公式が紹介 一方“バンダイ風ロゴ”を問題視する声も

米Googleの生成AI「Gemini」アプリの公式Xは、Geminiを活用し、AIで画像をフィギュア風に加工する方法を紹介した。その性能の高さに驚きの声を上げるXユーザーがいる一方で、Googleがアップした加工例の画像内に、バンダイのロゴに類似した模様が確認できることを問題視するユーザーも一部で見られる。