LLMの開発効率化に革新? 中国DeepSeekが「DeepSeek-OCR」発表 “テキストを画像化”でデータ圧縮:Innovative Tech(AI+)

中国のDeepSeek-AIに所属する研究者らは、本や画像などをスキャンして書いてある文字をデジタルテキストデータに変換するOCR(光学文字認識)を用い、長文を画像に圧縮する技術を発表した。

Innovative Tech(AI+):

このコーナーでは、2014年から先端テクノロジーの研究を論文単位で記事にしているWebメディア「Seamless」(シームレス)を主宰する山下裕毅氏が執筆。新規性の高いAI分野の科学論文を山下氏がピックアップし、解説する。

X: @shiropen2

中国のDeepSeek-AIに所属する研究者らが発表した論文「DeepSeek-OCR: Contexts Optical Compression」は、本や画像などをスキャンして書いてある文字をデジタルテキストデータに変換するOCR(光学文字認識)を用い、長文を画像に圧縮する技術を発表した研究報告だ。

大規模言語モデル(LLM)が長文を処理する際、文章の長さに応じて計算量が二次関数的に増大するという根本的な課題がある。DeepSeek-OCRは、文書を画像として扱い、視覚トークンへと変換することで大幅なデータ圧縮を実現している。

実験では、600〜1300トークンを含む文書100ページ分で検証を実施。圧縮率が10倍以内であれば約97%という高い精度でテキストを復元でき、20倍という極端な圧縮でも約60%の精度を維持できることを実証した。これは「一枚の画像は千の言葉に値する」という概念を、技術的に具現化したものといえる。

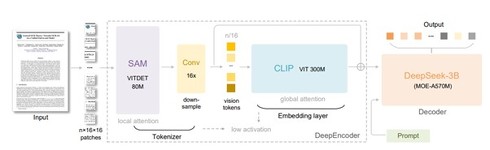

システムは、「DeepEncoder」と「DeepSeek-3B-MoE decoder」という2つの主要コンポーネントで構成。DeepEncoderは約3億8000万のパラメータを持ち、文書画像を効率的に圧縮する。DeepSeek-3B-MoE decoderは5億7000万の活性化パラメータを持ち、圧縮データから元の文章を復元する。

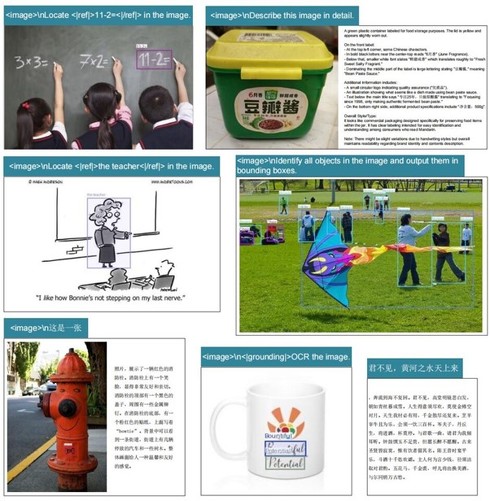

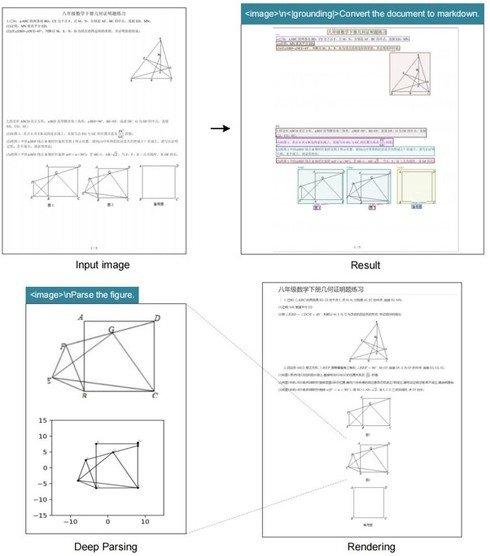

さらに、単純な文字認識だけでなく、文書内のグラフや図表、化学式、幾何学図形なども理解し、構造化されたデータとして出力できる。約100の言語に対応しており、アラビア語や少数言語の文書も処理可能だ。

実用性を高めるため、DeepEncoderは複数の解像度モードをサポートしている。最小のTinyモード(512×512、64トークン)から、最大のGundam-masterモード(1024×1024ローカルビュー、1280×1280グローバルビュー)まで、文書の種類や必要な精度に応じて選択可能だ。

ベンチマーク評価では優れた実用性を示している。PDF文書の解析に関する評価指標「OmniDocBench」において、わずか100視覚トークンで、OCRモデル「GOT-OCR2.0」(256トークン使用)を上回り、800トークン未満ではOCRモデル「MinerU2.0」(約6000トークン使用)を超えた。

生産環境では、1台のA100-40G GPUで1日当たり20万ページ以上の規模でLLM/VLM用の訓練データを生成できる処理能力を持つ。

なぜこの技術が重要なのか。現在のLLMは、長い文章を扱うときに計算コストが急激に増大するという問題を抱えている。DeepSeek-OCRのアプローチは、この問題に対する新しい解決策を提示している。文字を文字として扱うのではなく、画像として扱うことで、処理効率を向上させることができる。

Source and Image Credits: Haoran Wei, Yaofeng Sun, Yukun Li. DeepSeek-OCR: Contexts Optical Compression

Copyright © ITmedia, Inc. All Rights Reserved.

関連記事

パラメータ数は1兆超──“超巨大”なLLM「Qwen3-Max」は何がすごいのか? 中華製フラッグシップAIの現在地

パラメータ数は1兆超──“超巨大”なLLM「Qwen3-Max」は何がすごいのか? 中華製フラッグシップAIの現在地

中国Alibabaが9月に発表した、同社のLLM「Qwen」シリーズの新たなフラッグシップモデル「Qwen3-Max」。AI分野の中心が、AIエージェントへと移りつつある中、Qwen3-Maxはどのような存在といえるのだろうか。 意外と知らない中国AI事情 外資モデル締め出す法制度と、存在感示す中華LLMたち

意外と知らない中国AI事情 外資モデル締め出す法制度と、存在感示す中華LLMたち

中国のソブリンAI政策が外資系企業に与える影響と、存在感を強める“中華モデル”の動向について、概観を整理します。 OpenAIの「オープンなAI(gpt-oss-120b)」はGPUサーバじゃないと動かない?→約30万円の自作PCで動かしてみた

OpenAIの「オープンなAI(gpt-oss-120b)」はGPUサーバじゃないと動かない?→約30万円の自作PCで動かしてみた

米OpenAIの「オープンなAI」の実行にはサーバ向けのGPU「H100」が必要ということだったので、約30万円の自作PCで実行してみた。 中国発AI「DeepSeek-R1」がアップデート 長考での推論やコーディング性能向上か

中国発AI「DeepSeek-R1」がアップデート 長考での推論やコーディング性能向上か

AI開発企業の中国DeepSeekは、大規模言語モデル「DeepSeek-R1」のアップデート版を公開した。パラメータ数は6850億で、商用利用もできるMITライセンスの下で提供する。 第2のDeepSeekショック? オープンな中国LLM「Qwen3」シリーズが破格の性能で話題 最大モデルはOpenAI o1やGemini 2.5 Proに匹敵、たった4BでもGPT-4oレベルに

第2のDeepSeekショック? オープンな中国LLM「Qwen3」シリーズが破格の性能で話題 最大モデルはOpenAI o1やGemini 2.5 Proに匹敵、たった4BでもGPT-4oレベルに

Alibabaの最新LLM「Qwen3」シリーズが話題。フラグシップモデルはDeepSeek-R1やOpenAIの「o1」「o3-mini」、Google「Gemini 2.5 Pro」など他のトップクラスモデルと並ぶ性能の他、「Qwen3-4B」は非常に小さなモデルでありながらも「GPT-4o」を多くの項目で上回るとしている。全てのモデルがオープンウェイトなので完全ローカルで動作させることが可能。