“人知を超えたAI”はビジネスに不適切 「説明可能なAI」が求められるワケ 機械学習の“グランドマスター”(Kaggle Grandmaster)が解説

一昔前まで、AIはフィクションの中の話だった。「2001年宇宙の旅」に登場したAI「HAL 9000」のように、人間の理解が遠く及ばない判断を実行する“人知を超えた存在”として描かれることが多かった。

しかし現在、AIは私たちの生活に浸透している。あらゆる分野でAIのビジネス活用が進む一方で、さまざまな課題も見えてきた。その一つがAIのブラックボックス化だ。AIで満足のいく結果を出力できても、「なぜその結果になったのか」「根拠はどこにあるのか」が分からない点を懸念する声がある。万が一トラブルが起きたとき、その理由を説明できないのはビジネス上のリスクだ。

「AIの創造は人類史上で最大の出来事ですが、リスク回避の方法を学ばなければ、残念ながら最後の出来事になるかもしれません」――スティーブン・ホーキング博士の言葉を引用して、このリスクに警鐘を鳴らす人物がいる。世界的な機械学習のコンペティションプラットフォーム「Kaggle」の最高位ランクの称号「Grandmaster」(グランドマスター)を持つシバム・バンサル氏だ。

バンサル氏は、世界に248人しかいないGrandmasterの称号を持ち、AI生成プラットフォームを手掛ける米H2O.ai社のシニアデータサイエンティストとして活躍している。世界トップクラスのデータサイエンティストは、一体何を語るのか。

今回はバンサル氏が「説明可能なAIがもたらすビジネス拡大」と題した基調講演をレポートする。講演はデル・テクノロジーズ主催のセミナー「AI Experience Zone セミナー 2022 Spring」(2022年4月22日開催)で実施したものだ。

AIに関する懸念点 倫理面や技術面の課題に、大手IT企業も直面

基調講演の冒頭で、バンサル氏はAIやデータサイエンスにおける懸念点が2種類あると説明した。1つ目は一般的なリスクだ。専門知識が必要なこと、規制の対象になる可能性があること、技術の宣伝要素が大きいといった内容を指す。こうしたリスクは一般消費者やビジネス関係者の目に見えるので分かりやすい。一方で注意すべきは2つ目の隠れたリスクだ。技術的な課題やサイバーセキュリティ上の懸念、倫理面での問題などを挙げられる。

特に倫理面に関しては、AI活用に注力する大手IT企業でも透明性や信頼性の高いAIの開発に失敗した例が後を絶たない。例えば、米国大手EC企業の採用AIは女性を低く評価する傾向があると判明したのち、停止に追い込まれる出来事があったのは記憶に新しいだろう。

技術面でも、学習モデルの欠陥によってAI制御の自動運転車が歩行者を死亡させるなど、重大な事故が度々起こっている。こうしたリスクを避けるためには、AIの判断や分析の過程、判断の理由を明示できる「説明可能なAI」が重要だとバンサル氏は説明する。

説明可能なAIにとって重要な6つの要素とは

AIの出力結果を信頼する上で、説明可能性は欠かせない。これは、AIの動作を人間が理解できる言葉や形式で説明する解釈可能性とも深く関わっている。では、実際に説明可能なAIのモデルを作成するとはどういうことなのか。バンサル氏は重要な要素を6つに分けて解説した。

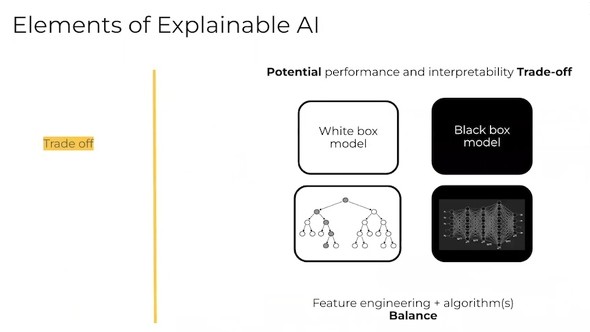

性能と解釈可能性の「トレードオフ」

機械学習などのAIやデータサイエンスについて、エンジニアが考える評価基準はAIの性能と解釈可能性の2種類に分かれる。

例えば機械学習について考えるとき、複雑なディープニューラルネットワークを活用した学習モデル(ブラックボックスモデル)は高性能だが、判断の過程を解釈するのは難しい。一方でノードが少なくシンプルなディシジョンツリー(決定木)の学習モデル(ホワイトボックスモデル)は解釈可能だが、性能面で劣ってしまう。

説明可能なAIを実装する場合には、性能と解釈可能性の間でトレードオフが起こるため、ある程度の妥協が必要になる。

学習モデルの「多様性」

AIを実装する際、考えるべき要素が学習モデルの多様性だ。複雑な現実世界を扱うとき、複数の学習モデルを活用することで、高い価値を発揮できる。

ただしこれには長所と短所がある。長所は、異なる学習モデルを活用することで、ビジネス上でも複数の結果や成果につながる可能性があるところだ。一方で複雑性が増し、説明可能性が低くなる短所がある。

AI活用を考える企業やデータサイエンスチームにとっては、この長所と短所を理解した上で、多様性について適切な選択基準を用意することが重要だとバンサル氏は話した。

ジェンダーや人種を平等に扱う「公正性」

実際にAIを使う前に注意すべきなのが公正性の問題だ。AIを使う場面では、ジェンダーや人種、年齢、宗教などデリケートな要素を含むことがある。本来、AIはこうした要素を平等かつ公正に扱うべきだが、前述した米国大手EC企業の採用AIのように特定の要素が不利になるような結果を出力するケースがある。

そうしたケースでは、学習用のデータか構築したモデルに偏りがある場合が多い。この偏りはAIを使い始める前に修正することが肝心だ。

AI活用のためらいを拭い去る「信頼性」

公正性の問題をクリアした後、ビジネスでAIを活用するときに重要なのが信頼性だ。大きな決断に関わる場合や、医療分野など人命に関わる場合、AIだけで答えを出すのは難しい。

例えば患者の病気を診察するとき、AIの判定結果を参考にしつつ、最終的な判断を人間が下すことになるだろう。そのとき、学習モデルの信頼度が低いと適切な判断ができなくなる。

医療分野に限らず、AIの信頼性が足りないとAI活用に疑問を抱く人が出てきてしまう。ためらいを拭い去るために、信頼性の構築に取り組む必要があるとバンサル氏は言う。

予測結果に影響する変数などの「属性」

信頼性や説明可能性に関わる重要な要素が、属性だ。属性とは学習モデルに影響する変数や特徴量を指す。AIで、ある予測結果を算出したとき、その結果に影響した変数は何か、それぞれの特徴量の貢献度はどのくらいかといった内容を知ることが大切になる。

学習モデルにおける属性の効果を知る分析技術は複数あるため、それらを活用してどの属性が出力結果に影響を与えたか判断できる。これは、AIの説明可能性を引き上げることに役立つ。

AIの正当性を担保する「規制」

バンサル氏が最後に挙げた要素は、規制だ。AIで導いた判断の正当性や説明可能性を担保する上で必要な、公的な判断の枠組みと言い換えられる。

例えば、銀行に融資を依頼した人について、その人の属性の1〜2つ程度で融資を拒否するようなAIは公正性に欠ける。こうしたことを避け、一定の品質を保つ上でも規制は重要だ。

AIの解釈可能性を担保する2つの方法

ここまで説明可能なAIの構築や活用に関わる6つの要素を紹介してきた。こうした要素を満たそうとすると、信頼性や説明責任を追求する声が大きくなり、結果的に解釈可能性の必要性が高まってきた。

AI開発の全プロセス――データ準備やデータマイニング、特徴量エンジニアリング、機械学習モデリング、実装といった工程で、開発者だけでなくエンドユーザーが解釈できるようにすることが求められている。それはつまり、前述した6つの要素を完全に満たすことだとバンサル氏は説明する。

一般的に、AIで解釈可能性を担保することは難しい。ニューラルネットワークなどの学習モデルに多くの特徴量を入力する場合、ネットワーク内でさまざまな組み合わせをして予測結果などを出力する。その際、ネットワーク内部では高度な相互作用が起きており「出力結果がこの特徴量に基づいている」と断定できない。予測に至る道筋をさかのぼって追うのも難しい。

解釈可能性の高いAIを開発する一つの方法は、学習モデルを構築する段階で、調整するという方法だ。特徴量同士の相互作用を制約したり、極端に単純化した特徴量エンジニアリングを行ったりして説明可能な学習モデルを構築する。これにより、機械学習の全工程が解釈可能になる場合がある。

もう一つの方法は、学習モデルが完成した後にもう1ステップ追加する方法だ。モデルの挙動や予測を分析する技術を加えることで、学習済みのモデルであっても説明可能な結果を得られるメリットがある。

学習済みモデルに適用できる技術を紹介

学習済みモデルに適用できる技術を活用したほうが、ビジネスにとって都合がいい。モデルの機能を制限せず、いまあるモデルに使えるからだ。ここで、その技術の一部を簡単に紹介する。

1つ目の差別的インパクト解析(Disparate Impact Analysis)は、データやモデルの偏りを解析して、AIに影響を与えるかどうか分析できる技術だ。データの偏り具合を確認し、是正に向けて調整する助けになる。

2つ目のシャープレイ値(Shapley value)は、学習モデルにおいてある1つの変数の重要性や、特徴量の貢献度を評価できる技術だ。ある予測値に影響を与えた変数を検証できる。

3つ目のK-LIME(Local Interpretable Model-agnostic Explanations)は、データサンプルの変更によってモデルがどのような影響を受けるのか検証できる技術だ。これによりモデルが変化するかどうかの堅牢性を測定できる。

4つ目の部分従属プロット(Partial Dependence Plot)は、ある特徴量が変化したとき予測結果にどれだけの影響があるかを表せる技術だ。特徴量に変化があった場合、モデルの変化と効果を検証できる。

「本当に素晴らしいAIの価値は、説明可能性で解釈可能なモデルがもたらす」

機械学習の解釈可能性(MLI:Machine Learning Interpretability)をどう確保するか見てきた。H2O.ai社では予測モデルの解釈を手助けする機能「MLI」を用意しており、予測モデルの動作の特徴をさまざまな手法で可視化できる。これを活用すれば、モデル全体(グローバル)の可視化と、個々の予測(ローカル)の可視化をどちらも実現できる。

バンサル氏は基調講演を通して、説明可能なAIとその解釈可能性について解説した。

「データサイエンティストは、AIや学習モデルが実現した優れた正確性に魅了されるかもしれません。しかし、本当に素晴らしい価値は説明可能性で解釈可能なモデルがもたらします。なぜなら、データサイエンティストでない人でも解釈でき、その価値を理解できるからです」(バンサル氏)

ビジネスでのAI活用を成功させるには、AIの価値を正しく生かせるかが鍵になる。バンサル氏は、ビジネスに活用するのに適したAI像を示した。説明可能なAIを筆頭に、本当にビジネスに役立つAIを考え、開発または導入し、自社に生かすときが来たといえる。

「Dell de AI(でるであい)」からのおすすめ記事一覧

Dell de AI(でるであい)とは──

「AIをビジネスで活用する」──そう言い表すのは簡単です。しかし、組織にとって本当に価値のあるアクションへ落とし込むには、考えるべきことがあまりに多すぎます。誰に相談すればいいのか、どうすれば成果を生み出せるのか。「Dell de AI “デル邂逅(であい)”」は、そんな悩みを持つ企業や組織にポジティブな出会いや思いもよらぬうれしい発見──「Serendipity(セレンディピティ)」が生まれることを目指した情報発信ポータル(https://www.itmedia.co.jp/news/special/bz211007/)です。

おすすめ(1)AI導入時の課題を解決するには

AI活用をもっと身近に メリットを気軽に体験できる“専門施設”がある! デル・テクノロジーズが使い勝手を紹介

「AIを使えない企業は衰退する」――勝機はAI活用にアリ 明大教授が訴える“知っておくべきこと”とは?

AIの動作環境、「サーバ」採用が約30% 調査で見えた、GPUサーバが役立つ訳 導入・更改時の懸念を払うには?

AIは“特別な投資”ではない 「知見も人材もない」企業が自社導入に成功するコツは? データサイエンティストに聞く

「AIでデータを英知に変える」 450超の施策でDX推進 大手IT企業のノウハウは? “AIスペシャリスト”が明かす

おすすめ(2)「統計学が最強の学問である」著者が語るデータ活用

【前編】

DX時代のデータ活用に役立つツール 「統計学が最強の学問である」著者が起業して開発に至った背景に迫る

【後編】

データ分析にAIを使うメリットを解説 “データサイエンティストいらず”の専用ツールを活用事例と一緒に紹介

おすすめ(3)事例で知るAI活用の最新事情

8つのAI導入サービスを紹介 製造業向け、オフィス業務効率化、DX推進など ビジネス活用のメリットも併せて解説

AIやDXは事業サイクルを加速させる武器だ――松尾豊教授が語る 企業のAI活用を後押しするセミナーを徹底レポート

「乗り遅れると大変なことに」 AIの大変革期、一般企業はどうすればいい? AI活用のヒントを6社に学ぶ

DXにAIを生かすには? “AI基盤の鉄板構成”で手軽に成果を享受する方法

AIで心疾患を見つけ出せ――医療現場のAI活用、その現状を追う AIは「勉強熱心で優秀な研修医」になるのか

“人知を超えたAI”はビジネスに不適切 「説明可能なAI」が求められるワケ 機械学習の“グランドマスター”が解説

化粧品の商品開発にAI活用、データ分析を自動化 材料開発を加速する「マテリアルズ・インフォマティクス」を解説

建設業界向けAIサービス 図面のデジタル化で設計業務を効率化 構造計画研究所の専用ツールとは

「AIは即戦力だ」 人材不足の製造業、“職人の経験”頼りの現場をAIは救えるか 専門知識なしでAI開発する方法とは?

数分かかる検査作業を3秒以下に AI活用で工事現場の安全確認を迅速化 速さのカギは「仮想GPU基盤」にあり

1秒の遅延が損失に――クラウド中央処理の課題3つ 解決策は「エッジAI」 システム構築のポイントは?

勝率2.6倍――AIで“勝てる広告”を生むサイバーエージェント GPU基盤を“あえて自社開発” そのワケは?

おすすめ(4)人間とAIの未来を知るには

これは、私が夢で見た「人間とAIの未来」の“ちょっと不思議”なお話

AIの“カンブリア爆発期”? 2022年を編集長と振り返る この先、AIはどう進化するのか考えた

Copyright © ITmedia, Inc. All Rights Reserved.

提供:デル・テクノロジーズ株式会社

アイティメディア営業企画/制作:ITmedia NEWS編集部/掲載内容有効期限:2022年6月26日

米H2O.ai社のシバム・バンサル氏(シニアデータサイエンティスト)

米H2O.ai社のシバム・バンサル氏(シニアデータサイエンティスト)