独自LLM開発のサイバーエージェント “和製生成AI”で広告制作を効率化 性能を約5.14倍にしたGPUサーバーとは?

日本語の大規模言語モデル(LLM)を開発 オープンソースで公開

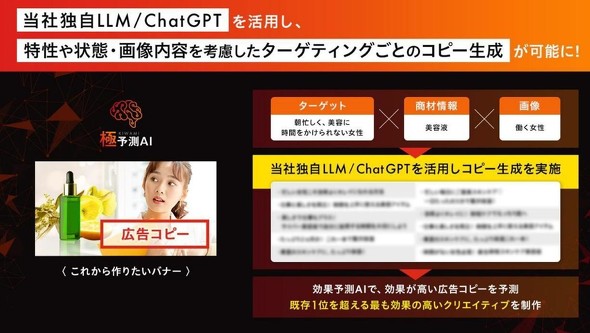

国内トップクラスのシェアを誇るインターネット広告事業や、「新しい未来のテレビ」をキャッチコピーにして「ABEMA」を展開するなど、グループ全体でさまざまな事業を行っているサイバーエージェント。同社では、2016年にAI研究組織「AI Lab」を設立し、広告クリエイティブの制作をAIで支援するなど積極的にAIの研究開発を行ってきた。2020年にはAIを活用して広告クリエイティブを制作できる「極予測AI」を提供し、より広告効果の高いバナー広告のキャッチコピーや画像の組み合わせなどを効率的に制作できるようにしている。

またサイバーエージェントは、130億パラメータからなる、日本語に特化した独自の大規模言語モデル(LLM: Large Language Model)を開発。2023年5月には、和製生成AI開発基盤用に、最大68億パラメータの日本語LLMを「OpenCALM」(オープンカーム)という名称で商用利用可能なオープンソースで公開した。多くのLLMが英語を中心に学習している中、日本語に強いLLMとして大きな注目を集めている。

OpenCALMは「CyberAgent Language Models」の略で、例えばChatGPTはチャットができるようにチューニングされているが、OpenCALMは汎用の日本語モデルとなっており、使う人が用途に合わせてファインチューニングすることが可能だ。サイバーエージェントとしては、クローズドに日本語LLMを開発するよりもオープンにしたほうが多くの人のフィードバックをもらえ、他社との協業や国内のAI技術発展への貢献ができるというメリットがあると考えて、OpenCALMを公開している。

さらに130億パラメータの日本語LLMはすでに、極予測AIや効果の高い広告文を生成する「極予測TD」、ランディングページの最適化を行う「極予測LP」などのAIを活用した広告クリエイティブ制作領域のサービスにおいて活用を始めているという。同LLMはさまざまな場面で使える汎用のAIモデルとして作られているが、サイバーエージェントでは各広告媒体のユーザー層に適したキャッチコピーを作れるようにファインチューニングして極予測AIで使っている他、極予測AI専用のAIモデル「効果予測AI」を開発して広告効果を予測するために使っている。将来的にサイバーエージェントは、日本語LLMだけでなく、画像なども扱えるマルチモーダルAIの開発を目指している。

NVIDIAの最新GPU搭載サーバーを求めて「PowerEdge XE9680」を採用

サイバーエージェントがAI Labを設立した2016年の段階では、研究者が1人1台のワークステーションを使って研究・開発を行っていた。しかし、2020年のコロナ禍でオフィスにあるGPUワークステーションのメンテナンスを行いづらい状況となり、当時最新のNVIDIA® A100 GPUが出てきたことで、データセンターにGPUサーバーを置いて機械学習基盤として運用していくことを考え始めた。

「GPUを使うだけならパブリッククラウドという選択肢もありますが、パブリッククラウドでは最新のGPUがいつ提供されるようになるのか分かりません。また、GPUを使いたいときに在庫を確保できるという保証もないため、オンプレミスにGPUリソースを確保した上で、パブリッククラウドと使いやすいほうをユーザーに選んでもらえるようにしました。パブリッククラウドとプライベートクラウドをユーザーが行き来しやすいように、できるだけパブリッククラウドの仕様に近づけてユーザーインタフェースなども工夫しています」とサイバーエージェントの高橋大輔氏(グループIT推進本部CIU, Solution Architect)は説明する。機械学習基盤として、NVIDIA® A100 GPUを搭載したデル・テクノロジーズの「PowerEdge XE8545サーバー」も採用している。

NVIDIAの最新GPUであるNVIDIA® H100 GPUにもリリース前から注目していたという高橋氏は、「単純に計算性能が向上するだけでなく、特定の計算アルゴリズムを高速化する『Transformer Engine』などの仕組みも魅力だと考えていました」と話す。NVIDIAによれば、Transformer Engineによって、前世代のNVIDIA® A100 GPU と比較して、大規模言語モデルのAI学習を最大9倍、AI推論を最大30倍高速化できるという。

「最新のGPUを求める社内ユーザーは一定数いるため、NVIDIA® H100を搭載したGPUサーバーについても調べました。一方で、コストパフォーマンスも含めて、最新のGPUでなくてもよいという需要もあるため、ユーザーの求めるGPUインフラを用意していくことがわれわれの使命だと考えています」(高橋氏)

最終的にサイバーエージェントでは、8基のNVIDIA® H100 GPUを搭載したサーバー「PowerEdge XE9680」を採用しているが、その理由を高橋氏は次のように話してくれた。「サーバーメーカー各社の話を聞いている中で、生成AI用途にも適したNVIDIA® H100 GPUの効果を生かせるPowerEdge XE9680サーバーが、タイムリーにリリースされると分かったため、いち早く導入することにしました。NVIDIA® H100 GPUが発表された後、同GPU搭載のPowerEdge XE9680がどのような構成になるかといった情報をデル・テクノロジーズと密にやりとりできたことも良かったと思います。なるべく少ない台数で稼働率を高めたいと考えていたため、デル・テクノロジーズが4時間オンサイト(4時間以内の訪問修理)などの高い保守レベルをリーズナブルな価格で実現してくれたのはうれしいポイントでした。過去導入したPowerEdge XE8545などを安定して保守してくれていたことや、管理ツールの『iDRAC』が使いやすいこともPowerEdge XE9680を採用した理由の1つです」(高橋氏)

2023年3月に発注して1カ月強先のゴールデンウイーク明けには納品されたことも、高橋氏は高く評価している。「コロナ禍でサプライチェーンが混乱している中で、デル・テクノロジーズは比較的安定したサプライチェーンを持っていることも安心でき、短納期で提供してくれるのはうれしいですね」(高橋氏)

また、納品後の構築では、さまざまな工夫を行ったと高橋氏は振り返る。「パラメータ数が多い大規模言語モデルでは、複数のGPUを使う必要があります。そこで各サーバーに400Gbpsのネットワークカード(NIC)を8枚挿し、RDMA(Remote Direct Memory Access)の技術を使ってサーバー間を高速につなぐインターコネクトを構築し、大規模な深層学習のモデルを学習する際のボトルネックを減らすようにしています。GPUサーバーは発熱量が多いため、効率的に冷却できる設計であることが重要ですが、冷却のために8Uのサーバーが主流となっている中で、PowerEdge XE9680は6Uのサイズでしっかりと冷却できる設計になっているのも評価できます。それに加えて、データセンターの部屋全体を冷やすのではなく、ラック背面に水冷式のリアドア空調機を取り付けることで効果的な冷却を行えるよう、データセンターもリアドア空調機が使える新たな場所に移転しました」(高橋氏)

Transformer Engineへの最適化でキャッチコピーの大幅な精度向上に期待

PowerEdge XE9680を導入することによって、同社はさまざまなメリットを実感しつつある。「パフォーマンスが大幅に向上したことで、日本語LLMの更新をより早く頻繁に行えるようになると期待しています。日本語LLMの進化速度も向上していくでしょう。また、NVIDIA® A100 GPUを4基搭載のPowerEdge XE8545に比べてNVIDIA® H100 GPUを8基搭載するPowerEdge XE9680では約5.14倍の性能向上が実現できていて、今後Transformer Engineへの最適化を行うことで十数倍の性能向上ができることを期待しています。最新のデータセットに合わせた機械学習モデルのファインチューニングなどもかなり高速に行えるようになっているので、サービスを進化させるという要望に応えやすくなっていますし、キャッチコピーの候補の精度を上げることができるようになると思います」と高橋氏は語る。

また、PowerEdge XE9680をベースとした機械学習基盤は、ユーザーにも高評価を得ていると高橋氏は続ける。「パブリッククラウドでGPUを確保できなかったり、長期の利用で課金額が大きくなったりすることもありましたが、社内のリサーチャーからは、より大量のリソースを確保できて課金額を気にせずに安心して利用できるという話が出ています。ユーザーがビジネスインパクトを出せるように、インターコネクトも含めてハイスペックなインフラを提供できたこともメリットだと言えます」(高橋氏)

以前から使ってきたデル・テクノロジーズの管理ツールiDRACによって、管理の負荷が低減されていることも高橋氏は評価している。「われわれはデータセンターに常駐していないので、リモートでさまざまなことができるiDRACは便利ですね。OSに入らなくてもGPUの温度や状態を確認でき、ファームウェアの更新などもできます」(高橋氏)

業界特化型LLMの構築も議論 今後もGPUの最新情報に注目

今後、サイバーエージェントではOpenCALMに対して集まってきたさまざまなフィードバックを改善に生かし、社内向けの大規模言語モデルにも反映させていく方針だ。また、OpenCALMを通じて、広告以外の業種の企業や団体との協業も模索しており、小売りなどリテール業界や金融業などと連携し、それぞれの固有データを学習して、その業界で使える「業界特化型のLLM」を構築するような議論が始まっているという。

その上で今後もGPUやその市場には注目し、新たな技術とそれがどのように製品化されていくかを見ていきたいと高橋氏は説明する。「現在のところ、GPUの選択肢はNVIDIAがとても有力となっていますが、積極的にGPU市場に参入してきている他のGPUベンダーの動きにも注目しています。NVIDIAが実現しているようなソフトウェアのエコシステムをどれだけ他のベンダーが作っていけるかも楽しみですね。また、GPUの性能を出すためにPCIeバス(データ伝送の規格)がボトルネックとなる場合もあるので、CPUとGPUをつなぐNVLink-C2Cや新たな規格のCXL(Compute eXpress Link)などが製品に実装される動きにも興味があります。CPU、GPU、メモリを筐体内でどのように接続するかで性能が変わっていくので、デル・テクノロジーズには、新たな技術をスピード感を持って取り入れ、高い性能が出る設計を今後も行ってくれることを期待しています」(高橋氏)

最新のGPUからコストパフォーマンスの高いGPUまで、ユーザーの求める機械学習基盤を常に提供することでサイバーエージェントのAIの研究・開発は進化し続けていく。また、日本語LLMのさらなる開発などで、サイバーエージェントは自社の広告事業のみならず、日本のAI市場で大きく注目され続けていくだろう。

この記事はデル・テクノロジーズから提供された原稿を、ITmedia NEWS編集部で一部編集したものです。

「Dell de AI(でるであい)」からのおすすめ記事一覧

Dell de AI(でるであい)とは──

「AIをビジネスで活用する」──そう言い表すのは簡単です。しかし、組織にとって本当に価値のあるアクションへ落とし込むには、考えるべきことがあまりに多すぎます。誰に相談すればいいのか、どうすれば成果を生み出せるのか。「Dell de AI “デル邂逅(であい)”」は、そんな悩みを持つ企業や組織にポジティブな出会いや思いもよらぬうれしい発見──「Serendipity(セレンディピティ)」が生まれることを目指した情報発信ポータル(https://www.itmedia.co.jp/news/special/bz211007/)です。

【関連記事】AIのビジネス活用 その先端を追う

勝率2.6倍――AIで“勝てる広告”を生むサイバーエージェント GPU基盤を“あえて自社開発” そのワケは?

数分かかる検査作業を3秒以下に AI活用で工事現場の安全確認を迅速化 速さのカギは「仮想GPU基盤」にあり

AIの動作環境、「サーバ」採用が約30% 調査で見えた、GPUサーバが役立つ訳 導入・更改時の懸念を払うには?

AIやDXは事業サイクルを加速させる武器だ――松尾豊教授が語る 企業のAI活用を後押しするセミナーを徹底レポート

「AIを使えない企業は衰退する」――勝機はAI活用にアリ 明大教授が訴える“知っておくべきこと”とは?

Copyright © ITmedia, Inc. All Rights Reserved.

提供:デル・テクノロジーズ株式会社

アイティメディア営業企画/制作:ITmedia NEWS編集部/掲載内容有効期限:2023年12月4日

サイバーエージェントの高橋大輔氏

サイバーエージェントの高橋大輔氏