Google I/O 2017基調講演まとめ 「AI First」をすべてのサービスに:Google I/O 2017

Googleの年次開発者会議「Google I/O」の基調講演で発表されたことを時系列にまとめた。詳細はリンク先をどうぞ。

米Googleは5月17日(現地時間)、本社キャンパス近くの野外ホールShoreline Amphitheatreで年次開発者会議「Google I/O 2017」の基調講演を開催した。本稿では発表された主な事項を時系列で簡単にまとめた。詳細についてはリンク先を参照されたい。

オープニングには小さな卵(アイデア)を持った人(開発者)がそれを育て、共に育っていく様子を描いたアニメーションで始まった。それに続いて登場したスンダー・ピチャイCEOは、会場には今年も7000人以上が参加しており、昨年のフィードバックを受けて野外会場にサンスクリーンを貼ったと語った。

同氏はGoogleドライブ(8億人)、Googleフォト(5億人)、Android(20億台)などの数字を披露した後、昨年と同様に同社は「Mobile FirstからAI First」にシフトしていると語った。

音声入力、画像入力の精度が高まっているとして、金網越しに野球の試合に出ている子どもを撮影した写真から金網をきれいに除去する方法などを紹介した。

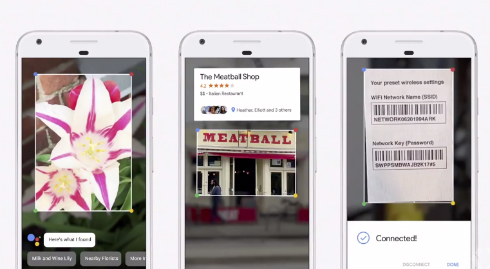

画像内を検索する「Google Lens」

同氏がまず紹介したのは「Google Lens」という新しい技術。機械学習による画像認識技術で、例えば「Google Assistant」に端末のカメラで写した花の写真を見せるとその花の種類を教えてくれたり、Googleフォトの写真に写っている建造物の情報を表示してくれたりする。

(詳細記事はこちら)

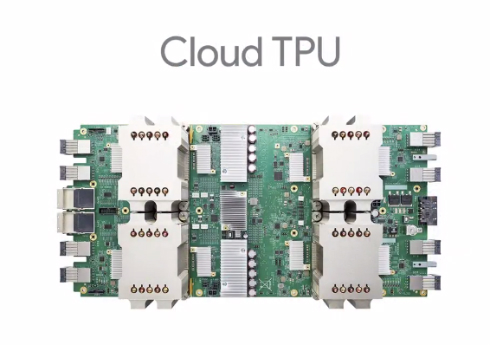

第二世代TPUと「Cloud TPU」

ピチャイ氏は次に、昨年のI/Oで発表した機械学習に最適化したプロセッサ「TPU(Tensor Processing Unit)」の新世代版と、クラウドサービス「Cloud TPU」を発表した。

前世代のTPUは機械学習の「推論」フェーズ向けだったが、新TPUはさらにパワーを必要とする「学習」向けにも最適化したという。

Cloud TPUは、「Google Compute Engine」でこの新TPUを利用できるクラウドサービスだ。

(詳細はGoogle公式ブログへ)

Google Assistantの新機能と日本でのリリース

ピチャイ氏の次に登壇したGoogle Assistant担当エンジニアリング担当副社長、スコット・ハフマン氏が、「Google Assistant」の新機能などを披露。

iPhone版Google Assistantアプリの提供や「Google Assistant SDK」での提携企業についても言及した。

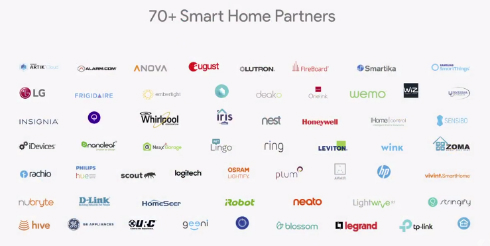

また、Google Assistantで決済できるようになったことも紹介され、スマートホーム対応ではパートナーが70社以上になったことも発表された。

(詳細記事はこちら)

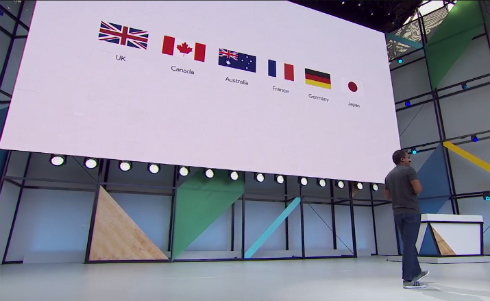

Google Homeが日本にやってくる

次はHome製品担当副社長リシ・チャンドラ氏による「Google Home」のデモ。

ようやく日本でも今夏以降に発売されることや、北米ではハンズフリーで電話がかけられること、Bluetooth対応、Chromecastとの連係による画面表示、新たなコンテンツパートナーなどが発表された。

(詳細記事はこちら)

Googleフォトにも機械学習機能

Googleフォトの紹介では、機械学習を応用した3つの新機能と、Google Lens機能が紹介された。いずれも向う数週間中にWeb、Android、iOS版アプリで使えるようになる見込みだ。

(詳細記事はこちら)

YouTubeの進捗について

続いてGoogle傘下のYouTubeのスーザン・ウォジスキCEOが初めてGoogle I/Oに登壇。Android TVのYouTubeで360度動画をリモコンで見られるデモや、投げ銭機能「Super Chat」でのクリエイターとファンの交流についてのデモが行われた。

「Android O」の一般向けβ版公開

次は人気者、Androidエンジニアリング担当副社長のデイブ・バーク氏。Androidのアクティブ端末が20億台を超えたこと、Google Playからのダウンロードが820億本に上ることなどを発表した後、次期Android OS「Android O」の新機能の幾つかをデモした。

(詳細記事はこちら)

アプリ向け機械学習ライブラリ「TensorFlow Lite」

Android Oの高度な機械学習機能を支えるものとして、「TensorFlow Lite」が発表された。これは、アプリ向けのライブラリで、高速・軽量でかつ、ContinentやLSTMなどの最新技術を使えるものとバーク氏は説明した。TensorFlow Liteは、TensorFlowプロジェクトの一部としてオープンソースで公開される見込み。

Androidの正式開発言語として「Kotlin」採用

次に登壇したAndroidのプロダクト管理ディレクター、ステファニー・サード・カスバートソン氏がAndroidアプリ開発者を支援する幾つかの新機能を紹介した後「One More Thing」としてオブジェクト指向言語「Kotlin」をAndroidの正式開発言語として採用すると発表すると、会場から歓声が上がった。

(詳細記事はこちら)

メモリ1GBでも稼働する「Android Go」

(詳細記事はこちら)

VR/AR関連の進捗

VRについては、昨年のI/Oで発表した「Daydream」のHMD「Daydream View」に韓国Samsung Electronicsの最新フラッグシップ端末「Galaxy S8」が対応したことや、DaydreamプラットフォームがスマートフォンもPCも不要の“スタンドアロンVR”ヘッドセットをサポートすることなどが発表された。年内にHTCとLenovoから対応端末が発売される見込みだ。

ARについては、ASUSの端末が出たことや、TangoとGoogleマップを組み合わせた「Visual Positioning Service(VPS)」の取り組みなどが紹介された。

(詳細記事はこちら)

ピチャイ氏によるクロージング

最後に「TensorFlow+Everyone」というメッセージと共にピチャイ氏が再登壇し、Googleのオープンソースツールを駆使して可能性を広げたシカゴ在住の若き開発者の物語動画を流した。

その後、Google検索で職探しができる「Google for Jobs」を紹介。これは、職種や地域で求人情報を検索し、給料や時間帯などのフィルタで絞り込んでいけるツール。少なくとも米国で向う数週間中にGoogle検索に組み込まれる。

(詳細は公式ブログ)

Copyright © ITmedia, Inc. All Rights Reserved.

関連記事

ロシア出身の「Kotlin」がAndroidの正式開発言語に

ロシア出身の「Kotlin」がAndroidの正式開発言語に

ロシア生まれのオブジェクト指向プログラミング言語「Kotlin」がAndroidの正式開発言語になり、「Android Studio 3.0」の一部として提供される。 「Daydream」にスマホ・PCレスの「スタンドアロンVR」登場 Galaxy S8/S8+対応も AR「Tango」は着実に進化

「Daydream」にスマホ・PCレスの「スタンドアロンVR」登場 Galaxy S8/S8+対応も AR「Tango」は着実に進化

「Googleフォト」に機械学習採用の3つの新機能

「Googleフォト」に機械学習採用の3つの新機能

Googleの写真サービス「Googleフォト」に、機械学習を採用した新機能が追加される。写っている人との共有を勧める「Suggested Sharing」、決まった相手と限定コンテンツを自動で共有する「Shared Libraries」、自動でアルバムを編集しフォトブックとして出力する「Photo Books」の3つだ。 「Google Lens」は画像内情報検索AI技術 Assistantやフォトと連係

「Google Lens」は画像内情報検索AI技術 Assistantやフォトと連係

「Google Lens」は、かつての「Google Goggles」や「Word Lens」が機械学習技術で大きく進歩したような新しい画像での検索技術。まずは「Google Assistant」と「Googleフォト」に組み込まれる。 Google、次期OS「Android O」のパブリックβを配布 メモリ1GB以下の「Android Go」も

Google、次期OS「Android O」のパブリックβを配布 メモリ1GB以下の「Android Go」も

Googleが、次期OS「Android O」のパブリックβを配布。より詳細な機能も明らかになった。Android Oを搭載した低スペック端末「Android Go」も2018年にリリースする。 「Google Assistant」のiPhoneアプリ登場

「Google Assistant」のiPhoneアプリ登場

Googleが、Appleの「Siri」と競合するパーソナルアシスタント「Google Assistant」のiPhoneアプリを米国のApp Storeで公開した。「Google Assistant」搭載のソニーやオンキヨーの製品も開発されている。 「Google Home」、日本で年内発売へ

「Google Home」、日本で年内発売へ

GoogleのAmazon Echo対抗スマートスピーカー「Google Home」が今夏以降にようやく日本で発売される。米国ではGoogle Homeから電話を掛ける機能も使えるようになる。