Microsoft、推論特化チップ「Maia 200」 競合比3倍の性能でGPT-5.2を支援

Microsoftは自社製AI推論チップ「Maia 200」を発表した。TSMCの3nmプロセスを採用し、演算性能はAmazonやGoogleの最新チップを凌駕するとしている。推論の価格性能比を30%改善し、OpenAIの「GPT-5.2」の提供基盤としても活用される。アイオワ州リージョンで稼働を開始しており、順次グローバルへ拡大する。

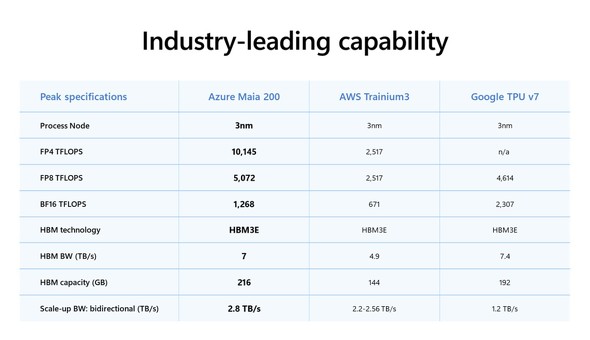

米Microsoftは1月26日(現地時間)、AI推論に特化した自社設計のカスタムアクセラレータ「Maia 200」を発表した。LLMの推論のスループットとコスト効率を最大化するデータセンター向けチップで、台湾TSMCの3nmプロセスを採用。216GBの広帯域メモリ(HBM3e)を備え、メモリ帯域7TB/sを実現している。

低精度演算(FP4/FP8)に最適化されたテンソルコアを搭載し、「第3世代Amazon Trainiumの3倍のFP4性能と、Googleの第7世代TPUを上回るFP8性能を備え、ハイパースケーラーが提供する最高性能のファーストパーティシリコンとなっている」という。

Maia 200の導入により、Azure上でのAIワークロードの価格性能比は約30%向上する見込みだ。米OpenAIの最新モデル「GPT-5.2」の推論基盤としても最適化されており、Microsoft FoundryやMicrosoft 365 Copilotのレスポンス向上や運用コストの削減にも波及するとしている。

既にAzureで稼働を開始しており、米アイオワ州のUS Centralリージョンに配備済みで、次に米アリゾナ州フェニックス近郊のUS West 3リージョンを予定し、今後ほかのリージョンにも展開していくとしている。

移行を支援するため、PyTorch統合やTritonコンパイラを含むSDKのプレビュー版も案内された。これにより、開発者は既存のAIモデルを最小限の手間でMaia 200へ移植し、チップの性能を最大限に引き出す最適化を行うことが可能になるとしている。

Copyright © ITmedia, Inc. All Rights Reserved.

関連記事

AWS、AIチップ「Trainium3」の提供開始 演算性能は先代の4.4倍に

AWS、AIチップ「Trainium3」の提供開始 演算性能は先代の4.4倍に

AWSは年次イベント「re:Invent 2025」で、3nmプロセスの新AIチップ「Trainium3」と搭載システム「Trainium3 UltraServer」を発表し、一般提供を開始した。先代比で演算性能最大4.4倍、メモリ帯域幅約4倍を達成。次世代「Trainium4」ではNVIDIAの「NVLink Fusion」をサポートし、GPUとのシームレスな連携を目指す。 Google、第7世代TPU「Ironwood」一般提供開始 Anthropicもテスト中

Google、第7世代TPU「Ironwood」一般提供開始 Anthropicもテスト中

Googleは、第7世代TPU「Ironwood」の一般提供を発表した。「推論の時代」を支えるAIアクセラレータと位置づける。併せてARMベースの「Axion」VMの拡張も発表した。Ironwoodは専門タスク、Axionは汎用タスクを担い、両者の組み合わせでワークロードを最適化できるとした。 Microsoft、AI最適化チップ「Azure Maia 100」と汎用Armチップ「Azure Cobalt」

Microsoft、AI最適化チップ「Azure Maia 100」と汎用Armチップ「Azure Cobalt」

Microsoftは2つのカスタム設計チップ、AIに最適化した「Maia 100」とArumベースの汎用「Cobalt 100」を発表した。「インフラストラクチャスタックのすべての層を最適化して統合することが重要」とガスリー氏。 クラウドインフラのシェア、Canalysの調査ではAWSがシェア30%台を維持、Azureは23%と急増

クラウドインフラのシェア、Canalysの調査ではAWSがシェア30%台を維持、Azureは23%と急増

調査会社のシンガポールCanalysは、2025年第1四半期におけるグローバルなクラウドインフラ市場に関する調査結果を発表しました。