無料でアカウント登録不要、NVIDIAのGPUがあれば超高速! 「LM Studio」で自分専用のAIアシスタントを作ろう(1/3 ページ)

本記事では、実際に「NVIDIA GeForce RTX 5060 Ti」を搭載したPCを使って、LM Studioを導入する方法や、活用方法を解説する。例えば、ゲーミングPCを持っている人であれば、GPUパワーをゲームだけでなく、生成AIにも活用できるようになる。

昨今はAI活用を推し進める声がよく挙がっているが、さまざまなサービスが乱立しており、「いまひとつピンとこない」「使いたくても活用方法が分からない」という声も少なくない。

その上、実は有料プランに加入しなければ、生成AIの力を最大限発揮できないという話も聞こえてくる。まだ活用方法が見えていない状況で、金銭を投じることにためらいもあるだろう。とはいえ、既に生成AIを活用し始めている人との差が今後大きくなってしまうのでは、といった不安もある。

そのような人にぜひ試してもらいたいものが、自身のPC上で生成AIを動かせる「LM Studio」と呼ばれるアプリだ。

Webサービスの生成AIとは異なり、手元のPC上でAI処理が完結するため、外部にデータが送信されることもなく安心して利用できる。Windowsユーザーであれば迷わず使えるUI(ユーザーインタフェース)を持ち、ローカル利用の自由の高さ、そして応用範囲の広さがそろった強力なプラットフォームだ。しかも無料である。

さまざまなライフイベントに直面する社会人はもちろんのこと、レポートや課題に日々追われている学生など、プライベートなことも含めて安心して相談できる自分専用の“相棒”が、自分のPC上に構築できるとしたら、ワクワクするのではないだろうか。

さらに、手持ちのPCにNVIDIAのGPUが搭載されていれば、より高速に生成AIを活用できるようになる。例えば、ゲーミングPCを持っている人であれば、GPUパワーをゲームだけでなく、生成AIにも活用できるようになる。

本記事では、実際に「NVIDIA GeForce RTX 5060 Ti」を搭載したPCを使って、LM Studioを導入する方法や、活用方法を解説する。ぜひ参考にしてほしい。

LM Studioの導入方法

今回は下記の検証環境を用意して実際にLM Studioを導入し、NVIDIAが8月に発表したAIモデル「NVIDIA Nemotron Nano 2」を利用できる環境を整えていく。

- 検証機の主なスペック

- CPU:AMD Ryzen 7 9700X

- メモリ:DDR5-5600 128GB

- GPU:GeForce RTX 5060 Ti(グラフィックスメモリは16GB)

今回の検証機は筆者が普段利用している環境をそのまま流用しているため、搭載メモリ量が128GBと多くなっているが、ゲーミングPCの搭載メモリで主流になりつつある32GBを搭載していれば十分な動作を期待できる。初心者の方でも分かりやすく丁寧に解説していくので、安心して読み進めていただければ幸いだ。

LM Studioのインストールと初期設定

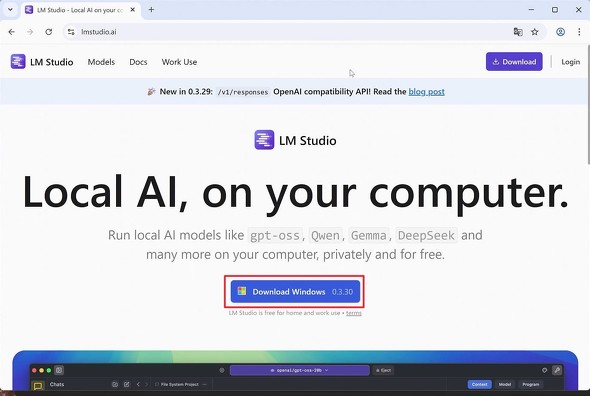

まずは、LM Studioの公式サイトにアクセスし、「Download Windows」ボタンをクリックしてインストーラーをダウンロードしよう。

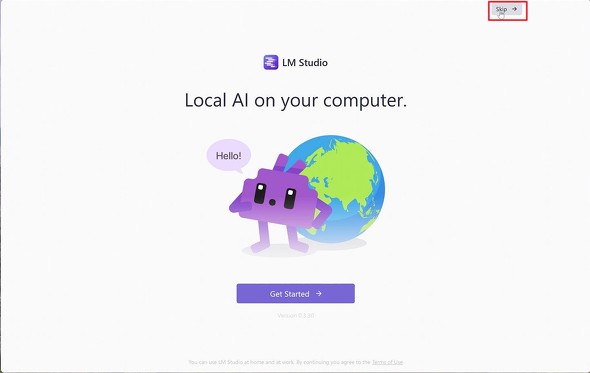

インストーラーではオプションの指定が求められるが、全てデフォルト設定のまま進めると、LM Studioの初期設定画面が表示される。

本来であれば、そのまま「Get Started」をクリックして初期ウィザードを進めていくが、今回は発表されて間もないモデルを利用するため、「Skip」をクリックして初期設定ウィザードを終了させよう。

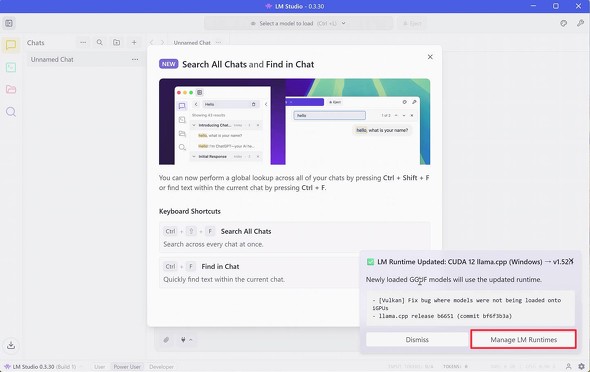

記事執筆時点で最新バージョンである「0.3.30」をインストールすると、「Search All Chats and Find in Chat」という新機能の紹介画面が表示されるので「OK」をクリックして閉じてしまおう。

続いて、LM Studioの画面右下に「LM Runtime Updated: CUDA 12llama.cpp(Windows)」というメッセージが表示されるので、「Manage LM Runtimes」ボタンをクリックする。なお、特にメッセージが表示されなかった場合はそのさらに右下の歯車アイコンをクリックしてほしい。

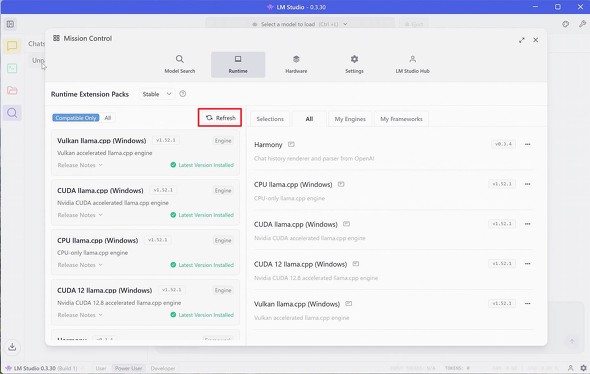

すると、「Runtime Extension Packs」の画面が表示されるので、「Refresh」ボタンをクリックし、「CUDA llama.cpp(Windows)」と「CUDA 12 llama.cpp(Windows)」が「Latest Versions Installed(最新版がインストール済み)」と表示されていることを確認しよう。

このllama.cppとは、簡単に言うと「インターネット接続不要で、プライバシーを守りながらAIが使える」というもので、CUDA llama.cppの“CUDA”は、NVIDIAが開発したGPUを使って並列計算を行うためのプラットフォームを指している。

先ほどの手順の中で「Manage LM Runtimes」ボタンが表示されず、歯車アイコンをクリックした方は「Runtime」をクリックすれば「Runtime Extension Packs」画面にアクセスできる。

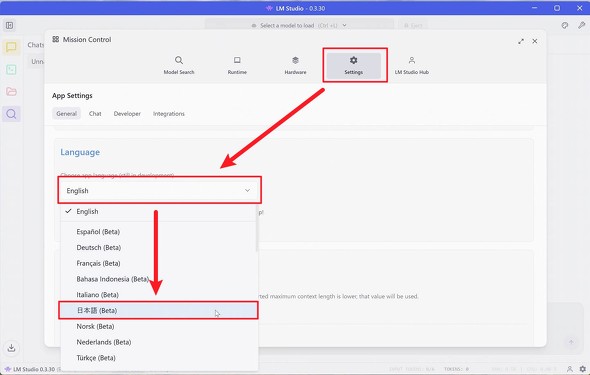

最後にLM Studioの言語設定を英語から日本語に切り替えよう。「Settings」をクリックして、「Language」の下にある「English」をクリックすると、ドロップダウンメニューが表示されるので「日本語(Beta)」をクリックしよう。

NVIDIAとllama.cppが協力し、NVIDIA RTX GPU上でのパフォーマンスを最適化している

さて、先ほど触れたローカルでAIを使うための根幹をなすllama.cppだが、なんとNVIDIAが協力して、NVIDIA RTX GPU上でさらに高いパフォーマンスを発揮するようアップデートを実施した。

このアップデートの一環で、今回実際に触れる最新のNVIDIA Nemotron Nano v2モデルのサポートや、他の人気のモデルで最大9%のパフォーマンス向上を実現している。

この協力によって、NVIDIAのGPUがあれば、超高速にAIが活用できるようになったというわけだ。

それでは、引き続きNVIDIA Nemotoron Nano v2モデルをダウンロードしてみよう。

Nemotron Nano v2モデルのダウンロード

LM Studioの初期設定は完了したものの、ローカルでAIを利用するためには膨大なデータをもとに学習した結果を保存した「モデル」というファイルをダウンロードしなければAIを利用できない。

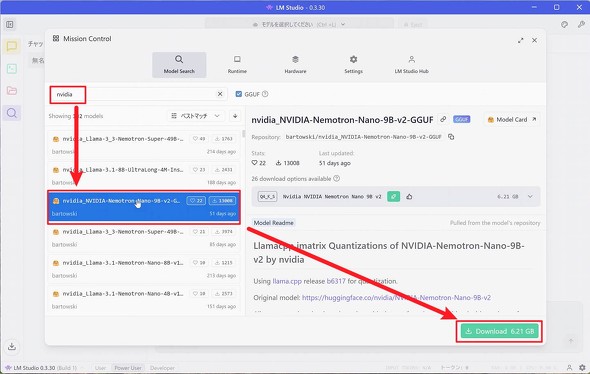

今回はNVIDIAが発表した「Nemotron Nano v2 9B」と呼ばれるモデルを実際にダウンロードしてみよう。

先ほどの設定画面で「Model Search」をクリックし、検索バーに「nvidia」と入力して、表示された「nvidia_NVIDIA-Nemotron-Nano-9B-v2-GGUF」をクリックして、さらに「Download」ボタンをクリックしよう。

しばらくするとモデルファイルのダウンロードが完了し、画面右下に「ダウンロード完了!」と表示されるので、「Load Model」をクリックしてNemotron Nano v2 9Bを読み込む。

するとチャットウィンドウが表示され、画面上部に「nvidia_nvidia-nemotron-nano-v2」と表示され、同時にプログレスバーが表示される。プログレスバーの表示が消えればモデルの読み込みは完了だ。

提供:エヌビディア合同会社

アイティメディア営業企画/制作:ITmedia PC USER 編集部/掲載内容有効期限:2025年11月3日

Copyright © ITmedia, Inc. All Rights Reserved.