「Snapdragon X2 Elite」がNPU性能「80TOPS」をアピールする理由:「Windows」フロントライン(1/3 ページ)

Qualcommが11月に開催したイベント「Snapdragon Architecture Deep Dive 2025」で語られた、最新PC向けSoC「Snapdragon X2 Elite」について細かく見ていこう。

この記事では、2026年初頭に搭載製品が市場投入されるQualcommのPC向け最新SoC「Snapdragon X2 Elite」について、引き続き同社のイベント「Snapdragon Architecture Deep Dive 2025」から得られた情報を基に深掘りしたい。今回はAI部分にフォーカスしている。

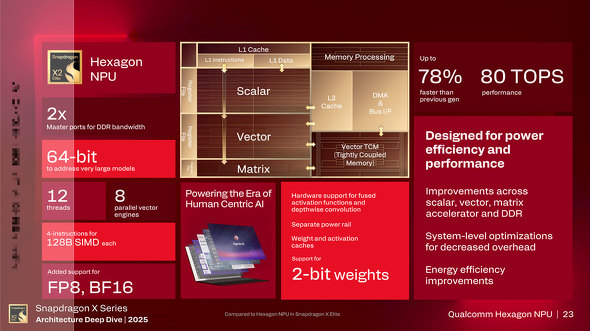

2025年9月に米ハワイ州マウイ島で開催された「Snapdragon Summit 2025」のレポートでも触れたように、同SoCではNPUで80TOPSという従来比で8割近い性能向上を実現するのみならず、高速化と省メモリ/低消費電力動作を実現するための工夫が施されるなど、ハードウェアとソフトウェアの両面で大幅にテコ入れが行われている点が特徴だ。

強化される演算ユニット

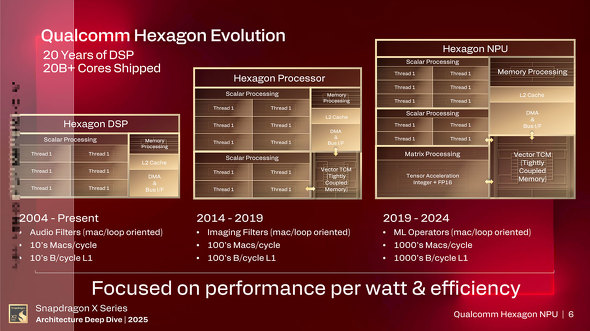

まずは基本スペックだが、「Hexagon」の名称で呼ばれるSnapdragon X2 EliteのNPUは、前述の通りハードウェアとソフトウェアの両面で改良を加えることで、前世代の45TOPSから80TOPSに性能を向上させている。

主力となるのは「スカラー(Scalar)」「ベクター(Vector)」「マトリクス(Matrix)」の3つの演算ユニットで、次のような役割を持つ。

- Scalar:NPU内の他の演算ユニット(VectorとMatrix)に流れるデータを分岐を含めて制御し、必要な形にデータを整形するシンプルな演算処理(加減算や論理演算など)を行う

- Vector:文字通りベクトル演算を行う演算ユニットで、大量の加算/乗算処理を一度に実行可能。SIMD(Single Instruction, Multiple Data)演算器の名称で呼ばれることもあり、比較的古いCPUでも演算処理高速化のためにSIMD命令拡張が行われてきた

- Matrix(Tensor):行列(Matrix)の計算に必要な大量の積和演算処理(MAC:Multiply ACcumulate)を高速に行うための演算ユニット。今日のAIにおけるさまざまな処理は行列の畳み込み演算を繰り返すことで成り立っており、NPUの実質的な中核にあたる

X2 EliteのNPUでは、前世代と比較してScalarユニットで処理可能なスレッド数が6から12へと倍増されており、トータルでのスループットが143%向上しているという。

例えば画像処理など、要求に応じて毎回サイズが変化する処理の場合、データを適切な形に変換するためにScalarユニットが重要となる。一方でVectorユニットの強化は、長大化しつつあるコンテキストのサイズを高速処理するために重要となる。

X2 EliteのNPUでは128ByteのSIMD演算器を配置し、加えてFP8やBF16のデータ型もサポートする。MatrixユニットについてはINT2の2bit値の処理をネイティブでサポートし、加えて非線形データの処理に必要な活性化関数(Activation Function)をハードウェアレベルで搭載し、さらなる高速化を実現する。

この他に重要なポイントとして、NPUの最大のメリットである「高速かつ省電力」を実現するため、ワークロードに応じて各演算ユニットの電圧を個別制御できる仕組みが実装されているのに加え、中間データをキャッシングすることでメインメモリへのアクセスを減らして高速化と省電力化を行っている(メインメモリへのアクセスはレスポンスのみならず電力消費上のオーバーヘッドもある)。

加えて、メインメモリ自体へのアクセス速度も向上しているなど、AI処理の巨大化と多重化に対応する。そして最も重要なポイントだが、現時点で3つのSKUが発表されている「Snapdragon X2 Elite/Extreme」の全てで80TOPSを実現していることが挙げられる。

つまり、CPUやGPUではSKUごとに差別化を行っていてもNPUの処理能力は同一であり、いかにSnapdragonにおいてAI処理が重視されているかということを物語る。

Copyright © ITmedia, Inc. All Rights Reserved.