生成AIでGPUがいらなくなる? 業界を揺るがす「1ビットLLM」とは何か、識者に聞いた(2/3 ページ)

米Microsoftの研究チームが発表した「BitNet」、通称「1bit LLM」と呼ばれる論文が波紋を呼んでいる。これまで必須だと思われていたGPUが不要で、CPUでもLLMが動作することを示唆している。そもそも“1bit”とは何が1bitなのか、どうして1bitになるとGPUが不要になるのか、AIソリューションの開発・提供を行うLaboro.AIの椎橋徹夫CEOに聞いた。

──bitというのはどういう意味ですか?

椎橋:bitというのは、ある数字を2進法で表したときの桁数のことです。

1bitだと、0か1の2値しか表現できません。2bitになると、00、01、10、11の4通りを表現できるようになります。3bitだと、2通りが3回重なるので、2の3乗で8通りになるんです。

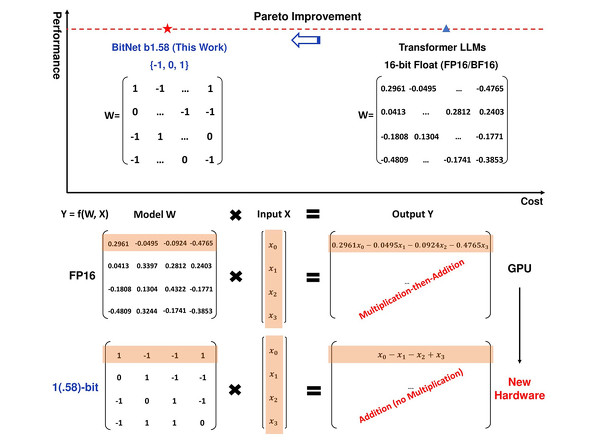

1bit LLMでは、桁をとことん丸めて、-1か1の2値にしてしまおうという発想なんです。具体的には、ニューラルネットの中の重みパラメータの数値を、大胆に-1か1にしてします。これをBitNetと呼んでいます。

この仕組みをLLMに適用してみようというのが1bit LLMの基本的なアイデアです。この基本アイデアに対して今回の論文では1つ工夫があって、-1か1だけでなく、0も加えて、0、1、-1の3値を使っています。3通りというのは、2の1.58乗に相当するんですよ。だから実際は1.58bitになります。

──1bit LLMにすると何が変わるんですか?

椎橋:メモリに乗せるモデルサイズは、4bitのモデルに比べてもだいぶ圧縮でき、これまでの量子化の延長線上にあります。でもそれだけではなく、計算量という点では、3値になると計算原理が変わってくるんです。

ニューラルネットは計算を行列計算で行っているんですが、ノード間をつないでいるエッジの重みを3値にすると、積算ではなく和算になるんです。

LLMのようなディープラーニングは行列計算をたくさん行うと聞いたことがあると思います。これまでなら行列の一番上の行、モデルのパラメータにあたる0.2961と入力のx0を掛け算して、次に-0.0495とx1を掛け算、次に-0.0924とx3を掛け算、続いてに-0.4765とx3を掛け算して、全部足し合わせたものが出力になります。小数点の掛け算をたくさんしなくてはなりません。

こんなときGPUは並列計算が得意なので、行列の掛け算を並列に計算できるんです。4個の計算を同時に行って足し合わせるようなこともできます。これがAIにGPUが必要な理由です。このとき、パラメータを4bitに減らしても、掛け算自体を行う必要があることは変わりません。

でも、3値になると符号の計算になり、入力の和算だけでいいようになります。3値、つまり-1、0、1しかない場合、先の例だと、x0と1を掛けて、x1と-1を掛けて、x2と-1を掛けて、x3と1を掛けて足し合わせることになります。これはつまりx0-x1-x2+x3という、符号だけを変えて足し合わせれば良いことになります。掛け算がなくなってしまうのです。

そうなると、CPUとGPUの計算効率がそこまで変わらなくなる、GPUよりも最適な半導体の設計があり得るかもしれません。つまり、1bitまで減らすと積和演算が和算だけになって、計算の質が変わるんです。これによって、GPUがいらなくなるんじゃないか、といわれているんですよ。

──AIを動かすのにGPUがいらなくなる! どんな可能性が開けるんですか?

椎橋:今回の結果から、LLMの推論において、GPUではなく別の半導体の機構が最適になって、劇的に計算が軽く早くなる可能性が開けてくるんです。

LLMを動かすのに必要な消費電力、計算処理能力、メモリサイズを大幅に抑えることができますからね。そうすると、推論についてはエッジ側、つまりモバイルやセンサーなどに近いデバイス側で行えるようになる可能性が高まります。大きなサーバに置かないと使えなかったものが、軽く推論できるようになるんです。サーバに置く場合でも、電力効率が良くなるので、より多くの推論を行えるようになります。

将来的には、普通のスマホでLLMが動くこともあり得るかもしれません。

Copyright © ITmedia, Inc. All Rights Reserved.