“大は小を兼ねない”生成AI 注目集める「小規模言語モデル」(SLM) そのメリットとは?:小林啓倫のエマージング・テクノロジー論考(1/3 ページ)

先日行われた、米Microsoftの開発者向けイベント「Microsoft Build 2024」の目玉の一つだった「SLM」(Small Language Model)。そもそもSLMとは何か? 何が期待されているのか? SLMの基本を整理する。

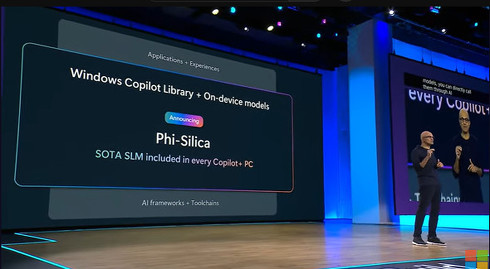

先日行われた、米Microsoftの開発者向けイベント「Microsoft Build 2024」。AI系技術を中心にさまざまな発表があったが、目玉の一つだったのが、SLM(Small Language Model)関連の新製品だ。ITmediaでも紹介記事が公開されているので、具体的な情報は以下を参照してほしい。この記事では、そもそもSLMとは何か、何が期待されているのかを整理してみよう。

(関連記事:Microsoft、Windowsローカルで実行可能なSLM「Phi Silica」を全「Copilot+ PC」に搭載へ)

(関連記事:Microsoft、マルチモーダルなSLM「Phi-3-vision」をプレビュー)

“大は小を兼ねない”「小規模言語モデル」(SLM)とは?

SLMは日本語で「小規模言語モデル」と訳されている。名前から分かるように、ChatGPTを始めとした生成AIアプリケーションのエンジンである「LLM」(大規模言語モデル)と対になる技術だ。

Microsoft「Phi-3」シリーズと、今回発表された「Phi Silica」はいずれもSLMの範囲に分類される言語モデルで、同社はその進化に力を入れている。またライバルの米Googleも、GeminiシリーズのSLM「Gemini Nano」を発表するなど、多くのIT企業が取り組みを見せている。

しかし言語モデルは、学習に使われるデータ量や、回答を導き出すためのパラメータ数(モデルがどのくらい多様で複雑な処理をできるかを表すものと考えてほしい)などが大きくなればなるほど優秀になる傾向があり、大手IT企業が競うようにその大規模化に乗り出していたはず。いまさら小規模なモデルを追求して何のメリットがあるというのだろうか。

結論から言うと、「大は小を兼ねる」ということわざは、言語モデルに対しては必ずしも正しくない。むしろ「長持枕にならず」の方が、ここで参照すべきことわざだ。

長持(ながもち)とは昔の家具で、衣服などを入れるのに使われていた、長方形の大きな箱のこと。見た目が似ているからといって、枕という用途で使うには大きすぎる。つまり何でも大きければ良いというものではなくて、時と場合によっては小さい方がちょうど良いこともあるという話だ。

では言語モデルにおいて、「小さい」ことのメリットとは何だろうか?

SLMが提供する3つのメリット

ここではSLMの主なメリットを、3つにまとめてみたい。第1に、SLMは消費する計算リソースが少ないため、スマートフォンやIoTデバイスなどの端末上で動かせる。

Copyright © ITmedia, Inc. All Rights Reserved.