Innovative Tech(AI+):

このコーナーでは、2014年から先端テクノロジーの研究を論文単位で記事にしているWebメディア「Seamless」(シームレス)を主宰する山下裕毅氏が執筆。新規性の高いAI分野の科学論文を山下氏がピックアップし、解説する。

X: @shiropen2

米ミネソタ大学と米アリゾナ大学に所属する研究者らが発表した論文「Experimental demonstration of magnetic tunnel junction-based computational random-access memory」は、データを転送せずにメモリ内で直接演算処理を行う手法を実験で実証した研究報告である。

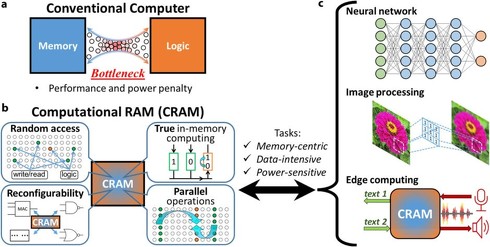

(a)演算ユニットとメモリユニットの間でデータ転送を行う従来のコンピュータアーキテクチャ (b)メモリ内でだけでデータ保存と計算処理を行うCRAM (c)CRAMは、ニューラルネットワークや画像処理、エッジコンピュータなどへの応用が期待される

機械学習などのデータ集約型アプリケーションは、膨大な計算能力を必要とするが、従来のコンピューティングアーキテクチャでは、演算ユニットとメモリユニットの間で絶え間なくデータを転送する必要があり、この転送プロセスに多大な電力とエネルギーを消費している。

この課題に対処するため、研究者たちは「Computational Random-Access Memory」(CRAM)と呼ばれる技術に着目。CRAMの特徴は、メモリセル自体を使って論理演算を直接実行できる点で、データをメモリから外部に転送することなく、メモリ内で直接計算処理が可能。この方式により、従来のアーキテクチャと比較して、大幅なエネルギー効率の向上と処理性能の改善が期待できる。

CRAMのコンセプトは以前から先行研究で提案されており、数値シミュレーションによってその潜在的な利点が示されていた。例えば、機械学習の処理において、CRAMを使うと従来のシステムと比べて約1000倍効率が良くなると推定されている。別の例として、手書き数字を認識するタスクでは、CRAMを使用すると消費エネルギーが2500分の1に、処理時間が1700分の1になるという結果が得られている。

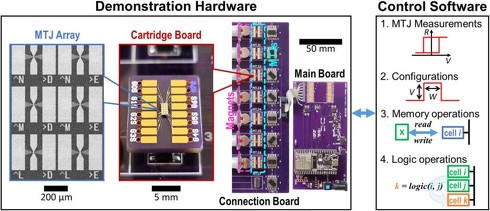

しかし、これまでCRAMの実験的な実証や、実際の計算精度の評価は行われていなかった。そこでこの研究では、磁気トンネル接合(Magnetic Tunnel Junction、MTJ)デバイスを用いた1×7のCRAMアレイを実際に作製し、その動作を実験的に実証することに成功。MTJとは、2つの強磁性層の間に非常に薄い絶縁層が挟まれた構造を指し、読み取り機能と書き込み機能の両方を備えた電気的に動作するメモリデバイスとして使用できる。

研究チームはまず、基本的なメモリ操作(CRAMアレイにデータを書き込み、そのデータを読み出す)と2入力(2つの入力に基づいて1つの出力を生成する演算)、3入力、5入力の論理演算を調査した。その結果、2入力のNAND演算では99.4%という高い精度を達成できることが分かった。一方、入力数が増えるにつれて精度は低下し、3入力のMAJ3演算では86.5%、5入力のMAJ5演算では75%の精度となった。

次に、より複雑な演算として1ビット全加算器を2つの異なる設計で実装した。1つはNANDゲートのみを使用する設計で、もう1つは多数決(MAJ)ゲートと反転(NOT)ゲートを組み合わせた設計である。実験の結果、NANDゲートのみを使用した設計の方が、78.5%とより高い精度を示した。

CRAMは特に、バイオインフォマティクス、画像処理、信号処理、ニューラルネットワーク、エッジコンピューティングなどのアプリケーションに適している可能性があり、今後の研究開発が期待される。

Source and Image Credits: Lv, Y., Zink, B.R., Bloom, R.P. et al. Experimental demonstration of magnetic tunnel junction-based computational random-access memory. npj Unconv. Comput. 1, 3(2024). https://doi.org/10.1038/s44335-024-00003-3

Copyright © ITmedia, Inc. All Rights Reserved.

関連記事

NVIDIA製GPUの数十倍速い? 次々に出てくる「AI専用チップ」とは何者か 識者に聞く高速化の仕組み

NVIDIA製GPUの数十倍速い? 次々に出てくる「AI専用チップ」とは何者か 識者に聞く高速化の仕組み

スタートアップ企業Etchedが発表した「Sohu」が、AI業界に新たな波紋を投げかけている。トランスフォーマーモデルに特化したこのAI専用チップは、NVIDIAのH100 GPUと比較して20倍高速かつ低コストで動作すると主張しているからだ。 “大は小を兼ねない”生成AI 注目集める「小規模言語モデル」(SLM) そのメリットとは?

“大は小を兼ねない”生成AI 注目集める「小規模言語モデル」(SLM) そのメリットとは?

先日行われた、米Microsoftの開発者向けイベント「Microsoft Build 2024」の目玉の一つだった「SLM」(Small Language Model)。そもそもSLMとは何か? 何が期待されているのか? SLMの基本を整理する。 生成AIでGPUがいらなくなる? 業界を揺るがす「1ビットLLM」とは何か、識者に聞いた

生成AIでGPUがいらなくなる? 業界を揺るがす「1ビットLLM」とは何か、識者に聞いた

米Microsoftの研究チームが発表した「BitNet」、通称「1bit LLM」と呼ばれる論文が波紋を呼んでいる。これまで必須だと思われていたGPUが不要で、CPUでもLLMが動作することを示唆している。そもそも“1bit”とは何が1bitなのか、どうして1bitになるとGPUが不要になるのか、AIソリューションの開発・提供を行うLaboro.AIの椎橋徹夫CEOに聞いた。 「Transformer」後継と期待される「RetNet」活用 PKSHAが日英対応の独自LLMを開発 日本MSも協力

「Transformer」後継と期待される「RetNet」活用 PKSHAが日英対応の独自LLMを開発 日本MSも協力

AIベンチャー・PKSHA Technologyは「RetNet」技術を活用した日英大規模言語モデルを開発したと発表した。RetNetを使用した日英モデルは世界初。同社の上野山勝也代表は「これによって生成AIの活用が一段前に進む」と自信を見せる。 “メルトダウンしない”原子力発電所、実験で成功 商用規模で自然冷却は世界初 中国の研究者らが発表

“メルトダウンしない”原子力発電所、実験で成功 商用規模で自然冷却は世界初 中国の研究者らが発表

清華大学に所属する研究者らは、外部電源が完全に失われた場合でも、冷却システムを使用せずに受動的に冷却するメルトダウンを起こさない商業用原子力発電所を実証した研究報告を発表した。