「レノボ」と聞いて何を連想するだろうか。すぐに思い浮かぶのは、ビジネス向けノートPC「ThinkPad」などのブランドだろう。しかし、それはレノボの一面に過ぎない。同社は「ポケットからクラウドまで」というフレーズを掲げて、スマートフォンやサーバ、ハイブリッドクラウド製品などを幅広く手掛けている。

そんな同社は、グローバルでAI戦略を着実に推進中だ。ビジネス改革やイノベーションの原動力としてAIに注目した同社は、2017年から投資を本格化。ハードウェア技術の革新や米NVIDIAをはじめとするパートナー企業との連携に基づくAIソリューションを2024年7月に発表して、企業のAI活用を支援すると宣言した。

AI企業へとかじを切ったレノボについて、AI半導体の雄であるNVIDIAの川井源氏は「日本市場で多くの企業にさまざまな製品を展開してきたレノボが、AI導入の課題を真正面から捉えて、課題解決のためにNVIDIAとの協業を選んだことは、AI導入を促進する最適な戦略だ」と評価する。

大手AIベンダーが先行する中、レノボはどう戦うのか。同社のAI戦略と支援メニューについてレノボとNVIDIAに聞いた。

取材した2人。右:レノボ・エンタープライズ・ソリューションズの早川哲郎氏(インフラストラクチャー・ソリューションズ・グループ ソリューションアーキテクト本部 本部長)、左:NVIDIAの川井源氏(エンタープライズ事業本部 データセンターGPU営業推進 シニアマネージャ)

経営層「AIはゲームチェンジャー」 でも使い方が分からない

「AIの活用方法は企業ごとに異なります。何でもできる“魔法のつえ”ではなく、オーダーメイドのAIが有効です。私たちは『AIを自社にどう適用すればいいか分からない』という悩みを抱える企業をサポートします」――こう話すのはレノボ・エンタープライズ・ソリューションズの早川哲郎氏だ。

企業のAI利用は、大手プラットフォーマーがパブリッククラウドで提供するAIサービスを使うのが一般的だ。何にでも使える汎用(はんよう)性があるが、何でもできるからこそ自社ならではの利用方法を見つけにくいという面がある。

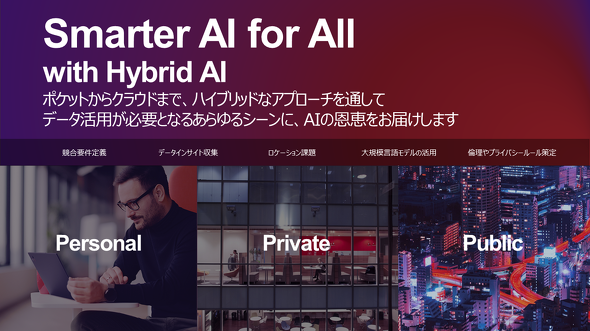

そこでレノボは「ハイブリッドAI」という戦略を採る。利用シーンごとに適したAIやITインフラを提案するというもので、「ChatGPT」のように不特定多数の利用を想定した「パブリック」、社内の利用に限定する「プライベート」、従業員のPCやスマホで完結する「パーソナル」という区分を作ることでユースケースを考えやすくする。パブリックなAIを手軽に使う、社内データによるAIモデルのカスタマイズをオンプレミスで実施する、端末搭載のAIアシスタントで従業員をサポートするなど、セキュリティやITインフラの観点による使い分けが可能だ。

レノボはAI活用支援においてユースケースの明確化を重視している。背景にあるのが、企業のCIO(最高情報責任者)やCTO(最高技術責任者)、部門の責任者との会話で集めた「AIへの関心は高いが、どう使えばいいか分からない」という実態だ。アジア太平洋地域の経営層900人を対象にしたIDCの調査「CIO Playbook 2024」によると、日本の経営幹部の41%が「AIはゲームチェンジャーだ」と考えている。しかし生成AIに投資済みと答えたのは2%にとどまった。ギャップを生んでいる要因の一つが、AIの利用方法が分からないという悩みにあると早川氏は指摘する。

社内で生成AI活用 レノボ自身が使ってみる

自ら率先してAIを活用し、ユースケースとなればいい――こうして始めたのが「Lenovo Powers Lenovo」という取り組みだ。レノボ社内で活用事例を蓄積することで、AIをビジネスにどう生かせばいいか説得力を持って提案できると早川氏は説明する。

Lenovo Powers Lenovoの成果は大きい。AIの利用によってサプライチェーンの意思決定を60%迅速化できた。生産ラインの能力を24%多く引き出す、コンタクトセンターの処理時間を20%短縮する、マーケティング用のコンテンツ作成時間を90%削減するなどの効果があった。

レノボが作った“AI活用サポート専門組織”とは

Lenovo Powers Lenovoの取り組みで培った知見を基に顧客のAI活用を支援すべく、レノボは専門組織「Lenovo AI Services Center of Excellence」(Lenovo AI CoE)を2024年7月に設立した。

Lenovo AI CoEを通して、「Lenovo AI Advisory and Professional Services」というサービスを提供する。同社のAIエキスパートやエンジニア、NVIDIAなどのパートナー企業と一緒に顧客のAI活用を支援するプロフェッショナルサービスだ。

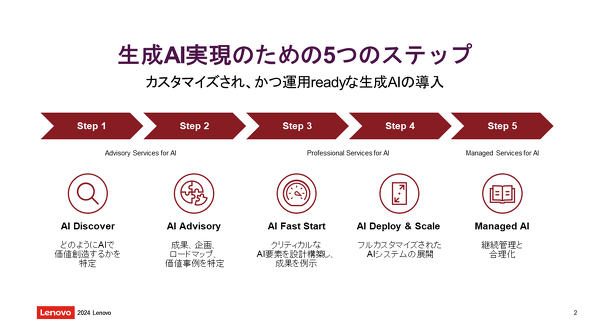

Lenovo AI Advisory and Professional Servicesは、顧客のAI活用に優先順位を付けて計画からPoC、実装、運用までの全工程を次のように伴走支援する。

(1)AI Discovery:顧客とのワークショップを通じて、コンサルティング的な観点からAIを適用すると効果的な業務や優先的に取り組むべき対象を決める。生成AIがいいのか画像認識AIがいいのかなど、用途に適したAIの選定も行う。

(2)AI Advisory:顧客が持つ技術や人材、業務プロセス、セキュリティ対策などを評価してAI活用のロードマップを作成する。どのようなデータがあるか、データをどう生かすかなども検討する。

(3)AI Fast Start:PoCでAIの効果を確かめる。NVIDIAのAI基盤「NVIDIA AI Enterprise」で利用できるAIアプリケーション開発用のマイクロサービス「NVIDIA NIM」を使ってAIを構築。完成したものを顧客に提供することでAIを素早く展開できる。

(4)AI Deploy and Scale:オンプレミスのサーバやレノボが提供するIaaS「TruScale」などを使ってAIシステムを導入、拡張する。

(5)AI Management:AIシステムの運用をレノボが担う。マネージドサービスやAI用サーバを預かるホスティングサービスなどがある。

AI基盤もAIチップも NVIDIAとの提携で実現するAI活用支援

レノボは、AIサービスを展開するに当たりNVIDIAと戦略的提携を結んだ。Lenovo AI Advisory and Professional Servicesにおける重要なパートナーであるNVIDIAの川井氏は「現状ではAI市場を主導しているのはクラウドです。しかし、今後ハイブリッドにかじを切る上でこのソリューションが重要になります」と語る。

両社の提携で、レノボは同社のサービスにNVIDIA AI Enterpriseを組み込めるようになった。これはAIの学習や推論、データサイエンスなどのAIワークロードを実行するためのソフトウェアソリューションだ。NVIDIAの認定GPUサーバと組み合わせることで、エンタープライズ用途に適した検証済みかつサポート付きのAI基盤が完成する。多様なAIソフトウェアをコンテナ化して提供、サポートすることでAIシステムの素早い構築を実現した。特に生成AIについては、同基盤で使えるNVIDIA NIMを使うことでAIモデルや推論エンジン、各種APIといったAIシステムの構成要素を迅速にデプロイできる。

「ハードウェア面でも連携を強化中です。2024年後半に登場する次世代AIチップ『NVIDIA Blackwell』を搭載したGPUサーバをいち早く提供できるように準備しています。AI活用の支援においてNVIDIAは欠かせないパートナーです」(早川氏)

「GPUコンピューティング環境をフルスタックでデザインして提供できることがNVIDIAのコアコンピタンス(企業の中核になる強み)の一つです。導入するシステムが問題なく動作することはもちろん、性能や保守性まで検証済みで、サポートも担えることがお客さまに提供できる最大の価値となります。レノボとのパートナーシップは、このエンタープライズ用途に適したAI環境を包括的にサポートして、展開を加速するものです。大規模クラウドサービスのインフラとしてはもちろん、企業内での比較的コンパクトなAI活用においても簡便かつ迅速な構築と運用が可能になります。レノボには自社でのAI展開の実績と知見があり、説得力を持った提案ができるので、日本のAIの進化をともに強力に推進できると期待しています」(川井氏)

AIエコシステムがレノボの強み 165以上の検証済みシステムを用意

レノボのAI戦略は、NVIDIAなどのパートナー企業との連携を重視している点が特徴だ。早川氏はハードウェアに強みを持つレノボとAIのソフトウェアが得意な企業が手を取り合うことで、AI活用を確実に推進できると説明する。

その中核を担うのが、レノボが世界中で発掘、協業してきた50社以上のパートナーが参画するエコシステムを生かした「Lenovo AIイノベーターズ・プログラム」だ。検証済みのAIシステムを業界、業務別に165以上そろえていて、在庫確認システムや無人レジなど幅広いニーズに対応できる。国内企業からも「詳細を聞きたい」という声が届くなど好反応だと早川氏は胸を張る。

AI利用が加速させる電力消費増 スパコンで培った独自の冷却技術で解決

レノボはAIが抱える課題にも目を向けている。サーバの排熱問題だ。GPUで高度なAI処理をするとサーバの発熱量が増大する。サーバの冷却用ファンが消費する電力はデータセンターの約30%を占めると早川氏は説明した上で「今後も消費電力量が右肩上がりに増えるでしょう。GPUが高密度化する中、空調で冷やす『空冷式』は限界を迎えています」と指摘する。

レノボはこの課題への“解”を持っている。独自の液体冷却技術「Lenovo Neptune」だ。発熱したGPUやサーバの各ノードに熱伝導率が高い金属を当てて、その金属を液体で冷やす「コールドプレート」方式だ。空冷式よりも効率的な冷却が可能で、消費電力も抑えられるので環境負荷を低減できるという。レノボがスーパーコンピュータのITシステムで磨いてきた技術はコールドプレート方式の中でも飛びぬけた熱回収率を誇り、最新の「第6世代Lenovo Neptune」はHPCやAIに最適化した新設計だと早川氏は話す。

空冷式は1ラック全てにサーバを詰めると冷却効率が下がるのでデッドスペースが生まれていた。液冷式は1ラックをフルに利用できるのでデータセンターのスペースを有効活用できる。この特徴を生かして、企業の敷地に設置しやすい輸送コンテナ型のデータセンターも提供している。

「和洋折衷で“良いAI”を展開」 企業の競争力アップを支援

「レノボがグローバル規模で蓄積した知見を基に、日本人に合うAIを提供したいと考えています。和洋折衷で“良いAI”を展開することで、日本企業の競争力アップをお手伝いします」(早川氏)

「AIシステムを構成するソフトウェアスタックは複雑であり、導入を成功させるには豊富な実績とノウハウを持った信頼できるパートナーとの協業が重要です。レノボとNVIDIAはAI活用を検討する多くのお客さまにとって優れた選択肢であると確信しています」(川井氏)

AI活用は始まったばかりでベストプラクティスは見つかっていない。多くの企業が試行錯誤する中、レノボはユースケースを提示することでAI活用を支援するという戦略を選んだ。培ってきた専門技術やパートナーシップを総動員して取り組む姿は正真正銘のAI企業と言える。今後の活躍に注目だ。

Copyright © ITmedia, Inc. All Rights Reserved.

関連リンク

提供:レノボ・エンタープライズ・ソリューションズ合同会社

アイティメディア営業企画/制作:ITmedia AI+編集部/掲載内容有効期限:2024年9月24日